Intelligenza Artificiale

Intelligenza artificiale assassina: le armi autonome potrebbero essere più destabilizzanti delle armi nucleari

L’era delle armi autonome è arrivata. I robot killer sono realtà. E uccidono vicino al nostro Paese.

Secondo un recente rapporto del Consiglio di sicurezza delle Nazioni Unite sulla guerra civile libica, i sistemi d’arma autonomi, comunemente noti come robot killer, potrebbero aver ucciso esseri umani per la prima volta in assoluto proprio lo scorso anno.

Gli storici non avrebbero quindi torto a identificare i robot killer libici come il punto di partenza della prossima grande corsa agli armamenti, quella che ha il potenziale per essere quella finale dell’umanità.

Gli apparati militari di tutto il mondo stanno investendo in maniera molto seria nella ricerca e lo sviluppo di armi autonome. Gli Stati Uniti da soli hanno stanziato 18 miliardi di dollari per armi autonome tra il 2016 e il 2020

I sistemi d’arma autonomi sono robot armati che possono operare in modo indipendente, selezionando e attaccando bersagli – il tutto, dettaglio importante che li separa dai più comuni droni da combattimento, senza che un essere umano sia coinvolto nelle decisioni.

Gli apparati militari di tutto il mondo stanno investendo in maniera molto seria nella ricerca e lo sviluppo di armi autonome. Gli Stati Uniti da soli hanno stanziato 18 miliardi di dollari per armi autonome tra il 2016 e il 2020.

Nel frattempo, le organizzazioni per i diritti umani stanno facendo a gara per stabilire regolamenti e divieti sullo sviluppo di tali armi.

In mancanza di un vero controllo su questa corsa agli armamenti (e senza un vero processo di elaborazione dell’opinione pubblica, che crede si tratti ancora di fantascienza) si pensa che le armi autonome possano destabilizzare le attuali strategie nucleari.

In mancanza di un vero controllo su questa corsa agli armamenti (e senza un vero processo di elaborazione dell’opinione pubblica, che crede si tratti ancora di fantascienza) si pensa che le armi autonome possano destabilizzare le attuali strategie nucleari

Ciò può avvenire sia perché potrebbero cambiare radicalmente la percezione del dominio strategico, aumentando il rischio di attacchi preventivi, sia perché potrebbero combinarsi con armi NBCR: nucleari, biologiche, chimiche, radiologiche.

Vi sono almeno quattro problemi sollevati dalle armi autonome.

Il primo è il problema dell’errata identificazione. Quando si seleziona un bersaglio, le armi autonome saranno in grado di distinguere tra soldati ostili e bambini che giocano con pistole giocattolo? Tra civili in fuga da un luogo di conflitto e insorti in ritirata tattica? Vedi il robot cattivo ED-209 – nel famoso film Robocop – che durante una dimostrazione dinanzi ai dirigenti, non sente cadere l’arma del volontario che si presta a fare da esca crivellandolo di colpi.

Quando si seleziona un bersaglio, le armi autonome saranno in grado di distinguere tra soldati ostili e bambini che giocano con pistole giocattolo?

L’esperto di armi autonome Paul Scharre usa la metafora della runaway gun, la «pistola in fuga» per spiegare questa sostanziale differenza. Una pistola in fuga è una mitragliatrice difettosa che continua a sparare dopo il rilascio del grilletto. L’arma continua a sparare fino all’esaurimento delle munizioni perché, per così dire, l’arma non sa che sta commettendo un errore. Le pistole in fuga sono estremamente pericolose, ma fortunatamente hanno operatori umani che possono interrompere il collegamento delle munizioni o cercare di puntare l’arma in una direzione sicura. Le armi autonome, per definizione, non hanno tale salvaguardia.

È importante sottolineare che l’Intelligenza Artificiale armata non deve nemmeno essere difettosa per produrre l’effetto della pistola in fuga. Come hanno dimostrato numerosi studi sugli errori algoritmici in tutti i settori, i migliori algoritmi, operando come previsto, possono generare risultati internamente corretti che tuttavia diffondono rapidamente errori terribili tra le popolazioni.

Ad esempio, una rete neurale progettata per l’uso negli ospedali di Pittsburgh ha identificato l’asma come un fattore di riduzione del rischio nei casi di polmonite; il software di riconoscimento delle immagini utilizzato da Google ha identificato gli afroamericani come gorilla e così via.

Il problema non è solo che quando i sistemi di intelligenza artificiale sbagliano, sbagliano alla rinfusa. È che quando sbagliano, i loro creatori spesso non sanno perché lo hanno fatto e, quindi, come correggerli

Il problema non è solo che quando i sistemi di intelligenza artificiale sbagliano, sbagliano alla rinfusa. È che quando sbagliano, i loro creatori spesso non sanno perché lo hanno fatto e, quindi, come correggerli. Il problema della scatola nera dell’Intelligenza Artificiale rende quasi impossibile immaginare uno sviluppo moralmente responsabile di sistemi d’arma autonomi.

I prossimi due pericoli sono i problemi della proliferazione di fascia bassa e di fascia alta.

Cominciamo con la fascia bassa. Le forze armate che stanno sviluppando armi autonome ora procedono partendo dal presupposto che saranno in grado di contenere e controllare l’uso di armi autonome. Ma se la storia della tecnologia delle armi ha insegnato qualcosa al mondo, è questa: le armi si diffondono.

Le pressioni del mercato potrebbero portare alla creazione e alla vendita diffusa di ciò che può essere considerato l’equivalente di un’arma autonoma del fucile d’assalto Kalashnikov, uno dei più venduti e diffusi al mondo: robot killer economici, efficaci e quasi impossibili da contenere mentre circolano in tutto il mondo.

Le pressioni del mercato potrebbero portare alla creazione e alla vendita diffusa di ciò che può essere considerato l’equivalente di un’arma autonoma del fucile d’assalto Kalashnikov, uno dei più venduti e diffusi al mondo: robot killer economici, efficaci e quasi impossibili da contenere mentre circolano in tutto il mondo.

Queste nuovi armamenti potrebbero finire nelle mani di persone al di fuori del controllo del governo, inclusi terroristi internazionali e nazionali.

Tuttavia, la proliferazione di fascia alta è altrettanto negativa.

Le Nazioni potrebbero competere per sviluppare versioni sempre più devastanti di armi autonome, comprese quelle in grado di montare armi chimiche, biologiche, radiologiche e nucleari – come la Skynet nella pellicola Terminator – portando il mondo a una specie di autodistruzione.

È probabile che le armi autonome di fascia alta portino a guerre più frequenti perché diminuiranno due delle forze primarie che storicamente hanno prevenuto e accorciato le guerre: la preoccupazione per i civili e le potenziali perdite dei propri soldati.

Con molta probabilità le guerre asimmetriche – ovvero le guerre condotte sul suolo di nazioni prive di tecnologie concorrenti – diventeranno più comuni.

Si pensi all’instabilità globale causata dagli interventi militari sovietici e statunitensi durante la Guerra Fredda, dalla prima guerra per procura al contraccolpo sperimentato oggi in tutto il mondo. Moltiplichiamo per ogni Paese che attualmente punta a armi autonome di fascia alta.

Le armi autonome mineranno l’ultimo palliativo dell’umanità contro i crimini e le atrocità di guerra: le leggi internazionali di guerra

Infine, le armi autonome mineranno l’ultimo palliativo dell’umanità contro i crimini e le atrocità di guerra: le leggi internazionali di guerra.

Queste leggi, codificate in trattati che risalgono alla Convenzione di Ginevra del 1864, sono la sottile linea blu internazionale che separa la guerra con onore dal massacro. Si basano sull’idea che le persone possono essere ritenute responsabili delle proprie azioni anche in tempo di guerra, che il diritto di uccidere altri soldati durante il combattimento non dà il diritto di uccidere civili.

Ma come possono essere ritenute responsabili le armi autonome?

Di chi è la colpa di un robot che commette crimini di guerra?

Chi verrebbe processato? L’arma? Il soldato?

I comandanti del soldato? La società che ha fabbricato l’arma?

Le organizzazioni non governative e gli esperti di diritto internazionale temono che le armi autonome portino a un grave divario di responsabilità

Le organizzazioni non governative e gli esperti di diritto internazionale temono che le armi autonome portino a un grave divario di responsabilità.

«Per ritenere un soldato penalmente responsabile del dispiegamento di un’arma autonoma che commette crimini di guerra, i pubblici ministeri dovrebbero provare sia actus reus che mens rea, termini latini che descrivono un atto colpevole e una mente colpevole» scrive il professore esperto in diritti umane James Dews.

«Questo sarebbe difficile dal punto di vista della legge, e forse ingiusto per una questione di moralità, dato che le armi autonome sono intrinsecamente imprevedibili. Credo che la distanza che separa il soldato dalle decisioni indipendenti prese dalle armi autonome in ambienti in rapida evoluzione sia semplicemente troppo grande».

La sfida legale e morale non è resa più facile spostando la colpa sulla catena di comando o tornando al luogo di produzione.

In un mondo senza regolamenti che impongono un controllo umano significativo delle armi autonome, ci saranno crimini di guerra senza criminali di guerra da ritenere responsabili

In un mondo senza regolamenti che impongono un controllo umano significativo delle armi autonome, ci saranno crimini di guerra senza criminali di guerra da ritenere responsabili.

La struttura delle leggi di guerra, insieme al loro valore deterrente, sarà notevolmente indebolita.

«Proviamo a immaginare un mondo in cui militari, gruppi di insorti e terroristi nazionali e internazionali possano schierare una forza letale teoricamente illimitata a rischio teoricamente zero in tempi e luoghi di loro scelta, senza alcuna responsabilità legale risultante. È un mondo in cui il tipo di errori algoritmici inevitabili che affliggono anche i giganti della tecnologia come Amazon e Google possono ora portare all’eliminazione di intere città».

La struttura delle leggi di guerra, insieme al loro valore deterrente, sarà notevolmente indebolita.

Il mondo non dovrebbe ripetere gli errori della corsa agli armamenti nucleari.

Intanto oggi, con la scusa delle «restrizioni COVID», alcuni robot autonomi sono stati schierati per le strade per far rispettare il distanziamento sociale tra cittadini e vigilare che indossino le mascherine oppure per proteggere le élite facoltose da una potenziale ribellione di massa.

Come riportato da Renovatio 21, la Cina disporrebbe già di sciami di droni suicidi esplosivi: i famosi slaughterbots tanto temuti dai teorici del pericolo delle armi autonome.

Il futuro è già qui.

I robot killer, pure.

Qualcuno vuole cominciare a discuterne seriamente?

È un mondo in cui il tipo di errori algoritmici inevitabili che affliggono anche i giganti della tecnologia come Amazon e Google possono ora portare all’eliminazione di intere città»

In effetti, ci sarebbe la fila: quando parleremo davvero delle armi biologiche, della manipolazione genetica gain of function, del CRISPR, del gene drive?

E quando parleremo della minaccia che pongono invece le armi cibernetiche?

Quando l’umanità si renderà conto dei rischi che corre a causa della tecnologia che essa stessa si ostina a creare al di fuori di qualsiasi legge morale?

Immagine di Tigersfather via Deviantart pubblicata su licenza Creative Commons Attribution-NonCommercial-NoDerivs 3.0 Unported (CC BY-NC-ND 3.0)

Intelligenza Artificiale

Robocani italiani per pulire le spiagge

L’avvento dei robocani negli spazi pubblici investe anche l’Italia.

I ricercatori dell’Istituto Italiano di Tecnologia (IIT) hanno sviluppato un robot quadrupede innovativo. Questo robot, chiamato VERO (Vacuum-cleaner Equipped RObot), è attualmente progettato per raccogliere mozziconi di sigarette sulle spiagge della Penisola.

Il VERO è basato su AlienGo, un roboquadrupede aprodotto dalla compagnia cinese Unitree. AlienGo è un dispositivo all’avanguardia impiegato per scopi di ricerca e ha un costo di circa 50.000 dollari. Tuttavia, VERO potrebbe essere costruito anche utilizzando una versione migliorata del più economico e atletico Unitree Go 2, il cui prezzo è intorno ai 1.600 dollari.

Iscriviti al canale Telegram ![]()

Il dispositivo cinoide è in grado di individuare i mozziconi di sigaretta sul terreno tramite due videocamere di profondità e a una rete neurale convoluzionale, e quindi pianificare il percorso e passarci sopra.

Quando il robocane rileva un mozzicone, attiva l’aspirapolvere integrato nella sua struttura, lo aspira e continua la pulizia senza interruzioni.

La ricerca del team italiano sul robocane VERO è stata pubblicata sulla rivista scientifica Journal of Field Robotics. «Sono stati condotti test approfonditi in sei diversi scenari esterni per mostrare le prestazioni del nostro prototipo e del nostro metodo» scrivono gli autori nell’abstract. «Per quanto a conoscenza degli autori, questa è la prima volta che un progetto e un metodo di questo tipo vengono presentati e testati con successo su un robot dotato di gambe».

Non si tratta della prima volta dei robocani in Italia.

Un esemplare appartenente all’Università era stato filmato in piazza a Genova mentre mesi fa, mentre in Umbria esemplari di robocane furono lasciati liberi di scorrazzare nei boschi all’interno di quello che è stato detto era un esperimento scientifico.

Tuttavia, non sono i robodoghi scienziati a impensierirci, quanto le loro versioni armate già testate sul terreno.

Renovatio 21, testata oramai ribattezzabile come «La voce del robocane» vista la serqua di articoli sull’argomento, aveva parlato della militarizzazione dei robocani negli scorsi anni. Roboquadrupedi militari sono in produzione ovunque – pure in versione «telepatica».

Mesi fa era emersa negli Stati Uniti anche una versione di robocane dotato di lanciafiamme chiamato «Thermonator».

Iscriviti alla Newslettera di Renovatio 21

Come riportato da Renovatio 21, Los Angeles, come Nuova York, hanno fornito le loro forze dell’ordine di robodogghi. Anche la vicina San Francisco ha persino preso in considerazione l’idea di consentire al suo dipartimento di polizia di utilizzare i robot dotati di forza letale in caso di emergenza.

The New York Police Department added a robot dog to hit force.

(Credit: Disclose) pic.twitter.com/JYAmlYLzag

— Apex World News (@apexworldnews) April 12, 2023

Robocani sono utilizzati ai confini con il Messico. Tuttavia vi è polemica: c’è chi ritiene che il loro uso spaventa gli immigrati spingendoli verso sentieri dove poi incontrano la morte.

Impressionanti davvero i robocani militari cinesi che volano sui tetti dei palazzi trasportati da un drone.

Blood-Wing, a Chinese defense contractor, demonstrates drone-deploying an armed robodog.

The Future is Now. pic.twitter.com/tRKnKa8xvp

— Lia Wong (@LiaWong__) October 4, 2022

Aiuta Renovatio 21

Come visto in immagini scioccanti della primavera 2022, i robocani abbiano pattugliato le strade di Shanghai durante il colossale lockdown della primavera 2022, dove per sorvegliare e punire i 26 milioni di abitanti usarono, oltre agli androidi quadrupedi, anche droni che volevano tra i palazzi ripetendo frasi come «contieni la sete di libertà del tuo spirito».

Shanghai has deployed robotic dogs to blare lockdown instructions to the public. pic.twitter.com/PK72YIPfxs

— Ian Miles Cheong (@stillgray) March 30, 2022

Nel frattempo, la NATO ha schierato sul campo il suo primo esemplare di robot killer, il Tracked Hybrid Modular Infantry Systems (THeMIS), visto in un’esercitazione in Lituania a inizio anno.

Nel frattempo, la Repubblica Popolare Cinese sta investendo in piattaforme abilitate all’Intelligenza Artificiale militare che spera un giorno condurranno missioni letali in tempo di guerra, completamente senza input o controllo umano

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

Cervello

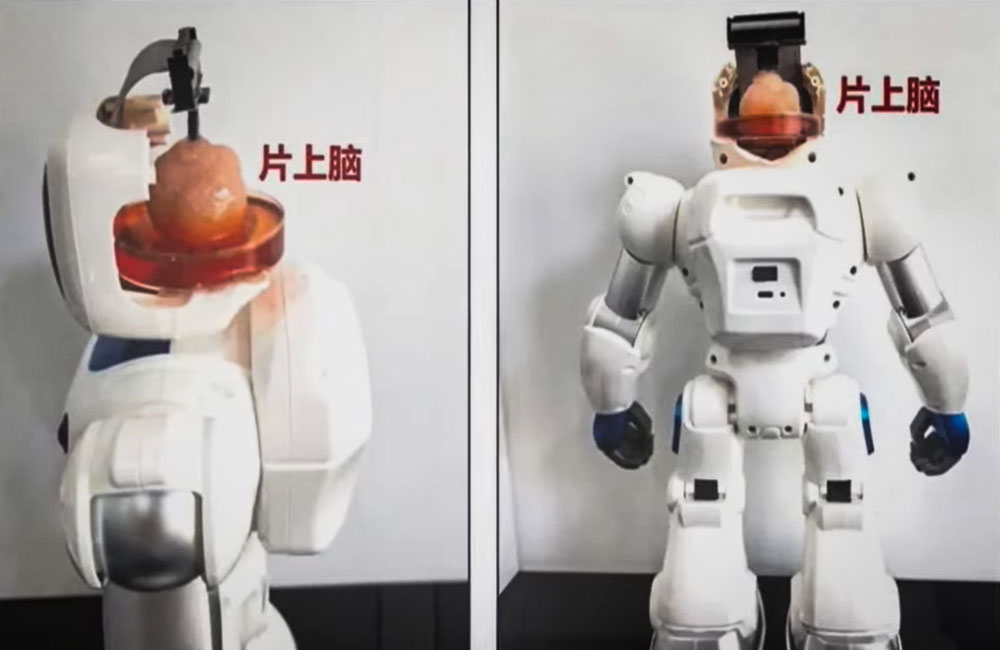

Gli scienziati cinesi creano un robot controllato dalle cellule cerebrali umane

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Musk: Tesla produrrà robot umanoidi già il prossimo anno

Il produttore di veicoli elettrici Tesla prevede di introdurre robot umanoidi per scopi interni a partire dal prossimo anno, con l’intenzione di estenderne la produzione entro il 2026, ha rivelato l’amministratore delegato dell’azienda Elon Musk.

Pubblicando un post su X lunedì, Musk ha detto che i robot saranno in «bassa produzione» presso le fabbriche dell’azienda. Ha detto che “si spera” saranno in alta produzione per altre aziende nel 2026.

L’annuncio arriva dopo che ad aprile il CEO aveva dichiarato che il robot Tesla Optimus sarebbe stato in grado di svolgere attività in fabbrica entro la fine dell’anno e potrebbe essere pronto per la vendita entro la fine del 2025.

Tesla will have genuinely useful humanoid robots in low production for Tesla internal use next year and, hopefully, high production for other companies in 2026

— Elon Musk (@elonmusk) July 22, 2024

Iscriviti al canale Telegram ![]()

Tesla ha svelato per la prima volta i piani per lavorare su robot umanoidi nel 2021 a un evento AI Day. Un anno dopo, l’azienda ha svelato Optimus, soprannominato Bumblebee, affermando che il suo costo previsto sarà inferiore a quello di un’auto Tesla e che sarà prodotto in grandi numeri.

Musk disse all’epoca che molti robot che hanno preceduto il robot Tesla erano «privi di cervello» e non avevano l’intelligenza per muoversi nel mondo da soli. Disse che Optimus sarà un «robot estremamente capace» e con un prezzo ragionevole inferiore a 20.000 dollari.

«Optimus sarà incredibile tra cinque o dieci anni, strabiliante», ha affermato Musk, che ha affermato in precedenza che le vendite di robot potrebbero diventare una parte più importante del business Tesla rispetto ad altri segmenti, tra cui la produzione di automobili.

Tesla robot is getting ready… pic.twitter.com/w2jqTG90PF

— Tansu Yegen (@TansuYegen) July 22, 2024

Meet Optimus-Gen 2, Tesla’s new humanoid #Robot

by @TechCrunch#AI #ArtificialIntelligence #Robotics #ML #Tech #Technology #Innovation #HealthTechcc: @patrickgunz_ch @karpathy @ravikikan pic.twitter.com/CV9bRPqBJs

— Ronald van Loon (@Ronald_vanLoon) July 21, 2024

Aiuta Renovatio 21

Musk ha lasciato trasparire che la costruzione di androidi antropomorfi in grado di svolgere lavori industriali o domestici potrebbe essere l’allungo tale da consentire la crescita di Tesla, prima industria dell’automotive mondiale per capitalizzazione, rafforzando la sua posizione dominante.

Diverse aziende, tra cui la giapponese Honda e la coreana Hyundai Motor, hanno puntato sui robot umanoidi per far fronte a potenziali carenze di manodopera in determinati settori, eseguendo compiti ripetitivi che potrebbero essere considerati pericolosi o noiosi. Tuttavia, molti confidano che, come per le macchine elettriche, l’apporto di Musk – indiscusso genio di progettazione dei prodotti, che fornisce di componenti rivoluzionarie finemente soppesate – possa essere quello giusto per popolarizzare una volta per tutte la robotica umanoide.

Secondo la società di ricerca MarketsandMarkets, il mercato globale dei robot umanoidi, valutato 1,8 miliardi di dollari nel 2023, dovrebbe raggiungere i 13 miliardi di dollari nei prossimi cinque anni.

Come riportato da Renovatio 21, il primo annuncio di quello che allora era chiamato «Tesla Bot» risale a tre anni fa. Il gigante tecnologico cinese Xiaomi due anni fa aveva mostrato al pubblico i suoi prototipi di androide, stranamente simili a quelli di Tesla.

Pochi mesi fa il produttore di microchip NVIDIA, divenuto società più capitalizzata in borsa al mondo, ha annunciato un nuovo progetto di Intelligenza Artificiale volto a creare «robot umanoidi» in grado di apprendere nuove competenze e risolvere compiti complessi studiando il comportamento umano.

Iscriviti alla Newslettera di Renovatio 21

Immagine di Tesla via Wikimedia pubblicata su licenza Creative Commons Attribution 3.0 Unported

-

Spirito2 settimane fa

Spirito2 settimane fa«Nostro Signore ha salvato questo coraggioso guerriero». Mons. Viganò commenta il tentato assassinio di Donald Trump

-

Spirito2 settimane fa

Spirito2 settimane fa«Questa chiesa è una contraffazione»: omelia di mons. Viganò

-

Gender2 settimane fa

Gender2 settimane faLa rete si interroga sul numero di agenti donne nella scorta di Trump

-

Salute2 settimane fa

Salute2 settimane faI malori della 28ª settimana 2024

-

Pensiero1 settimana fa

Pensiero1 settimana faLa scuola e l’eclissi della parola. Intervento di Elisabetta Frezza al convegno presso la Camera dei Deputati

-

Predazione degli organi5 giorni fa

Predazione degli organi5 giorni faIl legame tra il concetto di «morte cerebrale» e la predazione degli organi

-

Geopolitica2 settimane fa

Geopolitica2 settimane faMosca: le città europee sono i principali obiettivi dei missili russi

-

Pensiero5 giorni fa

Pensiero5 giorni faNATO e mRNA, la Von der Leyen riconfermata per l’imminente guerra transumanista