Intelligenza Artificiale

Gruppo di medici chiede di fermare l’Intelligenza Artificiale: «minaccia esistenziale» per l’umanità

Un gruppo di medici ha lanciato un nuovo appello per fermare lo sviluppo dell’intelligenza artificiale (AI), avvertendo che rappresenta una «minaccia esistenziale» per l’umanità. Lo riporta il giornale britannico Daily Mail.

Il team di cinque medici ed esperti di politica sanitaria globale provenienti da quattro continenti ha affermato che esistono tre modi in cui la tecnologia potrebbe spazzare via gli esseri umani.

Il primo è il rischio che l’intelligenza artificiale aiuti ad amplificare tattiche autoritarie come la sorveglianza e la disinformazione. «La capacità dell’intelligenza artificiale di ripulire, organizzare e analizzare rapidamente enormi set di dati costituiti da dati personali, comprese le immagini raccolte dalla presenza sempre più onnipresente di telecamere», affermano i dottori, potrebbe rendere più facile per i regimi autoritari o totalitari prendere il potere e rimanere al potere.

In secondo luogo, il gruppo avverte che l’IA può accelerare l’omicidio di massa attraverso l’uso esteso dei Lethal Autonomous Weapon Systems (LAWS), cioè i sistemi d’arma letale autonomi.

In terzo luogo, i medici hanno espresso preoccupazione per il potenziale di grave devastazione economica e miseria umana, poiché milioni di persone perdono i propri mezzi di sussistenza a causa di quei robot laboriosi. «Le proiezioni della velocità e dell’entità delle perdite di posti di lavoro dovute all’automazione guidata dall’intelligenza artificiale», secondo gli autori, «vanno da decine a centinaia di milioni nel prossimo decennio».

Il commento arriva solo poche settimane dopo che oltre un migliaio di scienziati, tra cui John Hopfield di Princeton e Rachel Branson del Bulletin of Atomic Scientists, hanno firmato una lettera che chiedeva di interrompere la ricerca sull’IA per preoccupazioni simili.

Gli esperti – guidati da un medico dell’International Institute for Global Health presso l’Università delle Nazioni Unite – hanno affermato che i loro avvertimenti più terribili si applicavano a una categoria di intelligenza artificiale altamente avanzata cioè l’Intelligenza Artificiale generale, o AGI.

L’AGI sarebbe più in grado di apprendere e modificare veramente il proprio codice per eseguire l’ampia gamma di compiti di cui solo gli esseri umani sono capaci oggi. Gli esperti di salute sostengono dunque che una tale AGI «potrebbe teoricamente imparare a superare qualsiasi vincolo nel suo codice e iniziare a sviluppare i propri scopi».

«Ci sono scenari in cui l’AGI potrebbe rappresentare una minaccia per gli esseri umani, e possibilmente una minaccia esistenziale», scrivono gli esperti in un articolo pubblicato oggi sulla prestigiosa rivista medica BMJ Global Health, «causando intenzionalmente o meno danni diretti o indiretti, attaccando o soggiogando gli esseri umani o interrompendo i sistemi o consumando le risorse da cui dipendiamo».

Descrivendo le minacce alla «democrazia, libertà e privacy», gli autori hanno descritto come i governi e altre grandi istituzioni potrebbero automatizzare i complessi compiti della sorveglianza di massa e dei programmi di disinformazione digitale online all’IA.

Nel primo caso, hanno citato il sistema di credito sociale cinese come un esempio di strumento statale per «controllare e opprimere» le popolazioni umane.

«Se combinati con la capacità in rapido miglioramento di distorcere o travisare la realtà con falsi profondi», hanno scritto gli autori in quest’ultimo caso, «i sistemi di informazione guidati dall’Intelligenza Artificiale possono minare ulteriormente la democrazia causando un crollo generale della fiducia o guidando la divisione sociale e il conflitto, con i conseguenti impatti sulla salute pubblica».

Descrivendo le minacce poste alla «pace e alla sicurezza pubblica», gli autori hanno dettagliato lo sviluppo dei sistemi di armi letali autonomi (LAWS). Tali armamenti IA, affermano i medici, sarebbero in grado di localizzare, selezionare e ingaggiare bersagli umani da solo.

«Tali armi potrebbero essere prodotte in serie a basso costo e impostate relativamente facilmente per uccidere su scala industriale». Ad esempio, è possibile che un milione di minuscoli droni dotati di esplosivi, capacità di riconoscimento visivo e capacità di navigazione autonoma siano contenuti all’interno di un normale container e programmati per uccidere: è la categoria, nota ai lettori di Renovatio 21, degli slaugterbots. Essi sono già realtà nella ricerca cinese e nell’industria militare australiana, che sta costruendo microdroni kamikaze per contrastare l’eventuale invasione cinese, mentre gli USA stanno approntando sistemi che permettono ad un operatore di gestire «sciami» di 130 droni militari alla volta.

Gli scienziati parlano quindi di «minacce al lavoro e ai mezzi di sussistenza», ha attirato l’attenzione sulla probabilità di impoverimento e miseria poiché «da decine a centinaia di milioni» perdono il lavoro a causa della «diffusa diffusione della tecnologia AI».

«Sebbene ci sarebbero molti vantaggi nel terminare un lavoro ripetitivo, pericoloso e spiacevole, sappiamo già che la disoccupazione è fortemente associata a esiti e comportamenti negativi per la salute», scrivono i dottori.

Come riportato da Renovatio 21, un recente rapporto della banca d’affari Goldman Sachs calcola che l’IA potrebbe portare a breve a 300 milioni di disoccupati nel mondo.

Gli autori hanno citato un sondaggio tra i membri della società AI in cui il 18% dei partecipanti ha affermato di ritenere che lo sviluppo di AGI avanzato sarebbe esistenzialmente catastrofico per l’umanità.

Il mese scorso grandi nomi della Silicon Valley e non solo hanno firmato una lettera per chiedere una moratoria internazionale che arresti la ricerca nell’Intelligenza Artificiale. Contro tale moratoria si è espresso Bill Gates, la cui Microsoft ha acquistato per 10 miliardi l’accesso a ChatGPT per il suo motore di ricerca, con conseguenze che i giornali hanno definito inquietanti.

Elon Musk, iniziatori della lettera per la moratoria, ha dichiarato durante la sua recente intervista con Tucker Carlson che il fine di Google – nemmeno così occulto – è quello di creare un dio-Intelligenza Artificiale. Quando Musk ha ribattuto ad un entusiasta fondatore di Google Larry Page specificando i rischi dell’AI, il Page gli ha dato dello «specista», termine del gergo animalista che indica una persona che mette la specie umana sopra le altre.

L’idea che l’AI diventerà una sorta di dio circola da anni e investe direttamente personale di OpenAI come il capo scientifico e cofondatore Ilya Sutskever, il quale ha chiesto ai suoi followers se le super-IA avanzate dovrebbero essere rese «profondamente obbedienti» ai loro creatori umani, o se questi algoritmi dovrebbero «amare veramente profondamente l’umanità». L’anno scorso, Sutskever affermò che «può darsi che le grandi reti neurali di oggi siano leggermente consapevoli».

Da Google si è recentemente licenziato l’esperto britannico Geoffrey Hinton, divenendo così libero di dare voce ai suoi dubbi per i rischi esiziali che corre l’umanità con la creazione delle macchine superintelligenti. Pochi mesi fa un ingegnere di Google, Blake Lemoine, ha dichiarato pubblicamente che il chatbot AI dell’azienda, LaMDA, è «senziente», ossia dotato di una coscienza comparabile a quella degli esseri umani.

Come riportato da Renovatio 21, Musk, oramai quasi una decina di anni fa aveva parlato del fatto che creare l’AI era «come evocare un demone».

Eliezer Yudkowsky, specialista nel tema dei pericoli delle IA, ha dichiarato che l’unica possibilità è una moratoria che preveda il bombardamento delle server farm dei Paesi che stanno sviluppando l’AGI, poiché se non si fermano le macchine «tutti sulla terra moriranno».

Intelligenza Artificiale

Robocani italiani per pulire le spiagge

L’avvento dei robocani negli spazi pubblici investe anche l’Italia.

I ricercatori dell’Istituto Italiano di Tecnologia (IIT) hanno sviluppato un robot quadrupede innovativo. Questo robot, chiamato VERO (Vacuum-cleaner Equipped RObot), è attualmente progettato per raccogliere mozziconi di sigarette sulle spiagge della Penisola.

Il VERO è basato su AlienGo, un roboquadrupede aprodotto dalla compagnia cinese Unitree. AlienGo è un dispositivo all’avanguardia impiegato per scopi di ricerca e ha un costo di circa 50.000 dollari. Tuttavia, VERO potrebbe essere costruito anche utilizzando una versione migliorata del più economico e atletico Unitree Go 2, il cui prezzo è intorno ai 1.600 dollari.

Iscriviti al canale Telegram ![]()

Il dispositivo cinoide è in grado di individuare i mozziconi di sigaretta sul terreno tramite due videocamere di profondità e a una rete neurale convoluzionale, e quindi pianificare il percorso e passarci sopra.

Quando il robocane rileva un mozzicone, attiva l’aspirapolvere integrato nella sua struttura, lo aspira e continua la pulizia senza interruzioni.

La ricerca del team italiano sul robocane VERO è stata pubblicata sulla rivista scientifica Journal of Field Robotics. «Sono stati condotti test approfonditi in sei diversi scenari esterni per mostrare le prestazioni del nostro prototipo e del nostro metodo» scrivono gli autori nell’abstract. «Per quanto a conoscenza degli autori, questa è la prima volta che un progetto e un metodo di questo tipo vengono presentati e testati con successo su un robot dotato di gambe».

Non si tratta della prima volta dei robocani in Italia.

Un esemplare appartenente all’Università era stato filmato in piazza a Genova mentre mesi fa, mentre in Umbria esemplari di robocane furono lasciati liberi di scorrazzare nei boschi all’interno di quello che è stato detto era un esperimento scientifico.

Tuttavia, non sono i robodoghi scienziati a impensierirci, quanto le loro versioni armate già testate sul terreno.

Renovatio 21, testata oramai ribattezzabile come «La voce del robocane» vista la serqua di articoli sull’argomento, aveva parlato della militarizzazione dei robocani negli scorsi anni. Roboquadrupedi militari sono in produzione ovunque – pure in versione «telepatica».

Mesi fa era emersa negli Stati Uniti anche una versione di robocane dotato di lanciafiamme chiamato «Thermonator».

Iscriviti alla Newslettera di Renovatio 21

Come riportato da Renovatio 21, Los Angeles, come Nuova York, hanno fornito le loro forze dell’ordine di robodogghi. Anche la vicina San Francisco ha persino preso in considerazione l’idea di consentire al suo dipartimento di polizia di utilizzare i robot dotati di forza letale in caso di emergenza.

The New York Police Department added a robot dog to hit force.

(Credit: Disclose) pic.twitter.com/JYAmlYLzag

— Apex World News (@apexworldnews) April 12, 2023

Robocani sono utilizzati ai confini con il Messico. Tuttavia vi è polemica: c’è chi ritiene che il loro uso spaventa gli immigrati spingendoli verso sentieri dove poi incontrano la morte.

Impressionanti davvero i robocani militari cinesi che volano sui tetti dei palazzi trasportati da un drone.

Blood-Wing, a Chinese defense contractor, demonstrates drone-deploying an armed robodog.

The Future is Now. pic.twitter.com/tRKnKa8xvp

— Lia Wong (@LiaWong__) October 4, 2022

Aiuta Renovatio 21

Come visto in immagini scioccanti della primavera 2022, i robocani abbiano pattugliato le strade di Shanghai durante il colossale lockdown della primavera 2022, dove per sorvegliare e punire i 26 milioni di abitanti usarono, oltre agli androidi quadrupedi, anche droni che volevano tra i palazzi ripetendo frasi come «contieni la sete di libertà del tuo spirito».

Shanghai has deployed robotic dogs to blare lockdown instructions to the public. pic.twitter.com/PK72YIPfxs

— Ian Miles Cheong (@stillgray) March 30, 2022

Nel frattempo, la NATO ha schierato sul campo il suo primo esemplare di robot killer, il Tracked Hybrid Modular Infantry Systems (THeMIS), visto in un’esercitazione in Lituania a inizio anno.

Nel frattempo, la Repubblica Popolare Cinese sta investendo in piattaforme abilitate all’Intelligenza Artificiale militare che spera un giorno condurranno missioni letali in tempo di guerra, completamente senza input o controllo umano

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

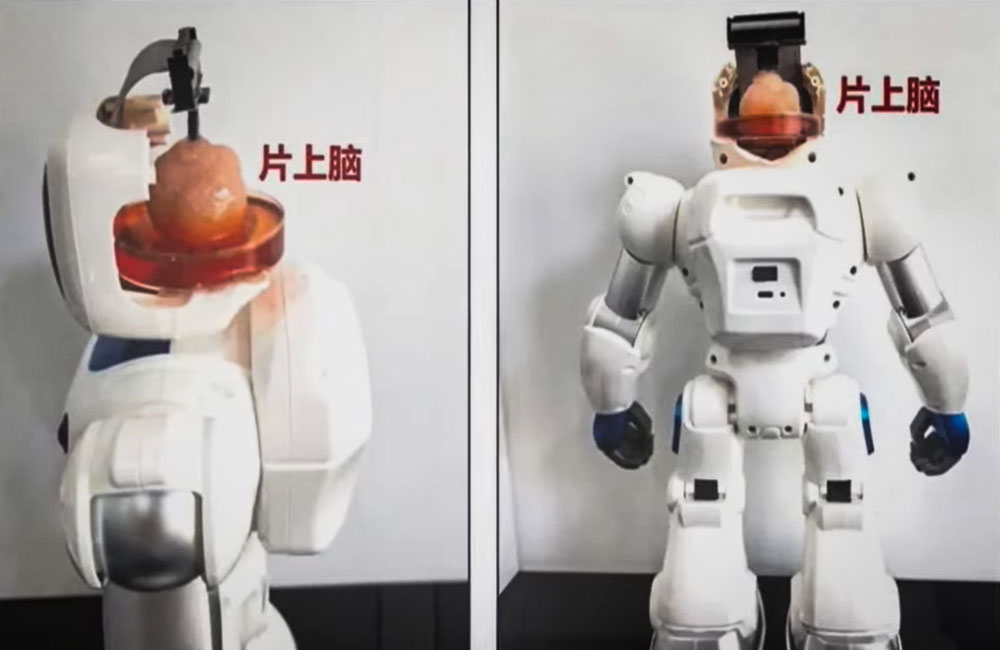

Cervello

Gli scienziati cinesi creano un robot controllato dalle cellule cerebrali umane

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Musk: Tesla produrrà robot umanoidi già il prossimo anno

Il produttore di veicoli elettrici Tesla prevede di introdurre robot umanoidi per scopi interni a partire dal prossimo anno, con l’intenzione di estenderne la produzione entro il 2026, ha rivelato l’amministratore delegato dell’azienda Elon Musk.

Pubblicando un post su X lunedì, Musk ha detto che i robot saranno in «bassa produzione» presso le fabbriche dell’azienda. Ha detto che “si spera” saranno in alta produzione per altre aziende nel 2026.

L’annuncio arriva dopo che ad aprile il CEO aveva dichiarato che il robot Tesla Optimus sarebbe stato in grado di svolgere attività in fabbrica entro la fine dell’anno e potrebbe essere pronto per la vendita entro la fine del 2025.

Tesla will have genuinely useful humanoid robots in low production for Tesla internal use next year and, hopefully, high production for other companies in 2026

— Elon Musk (@elonmusk) July 22, 2024

Iscriviti al canale Telegram ![]()

Tesla ha svelato per la prima volta i piani per lavorare su robot umanoidi nel 2021 a un evento AI Day. Un anno dopo, l’azienda ha svelato Optimus, soprannominato Bumblebee, affermando che il suo costo previsto sarà inferiore a quello di un’auto Tesla e che sarà prodotto in grandi numeri.

Musk disse all’epoca che molti robot che hanno preceduto il robot Tesla erano «privi di cervello» e non avevano l’intelligenza per muoversi nel mondo da soli. Disse che Optimus sarà un «robot estremamente capace» e con un prezzo ragionevole inferiore a 20.000 dollari.

«Optimus sarà incredibile tra cinque o dieci anni, strabiliante», ha affermato Musk, che ha affermato in precedenza che le vendite di robot potrebbero diventare una parte più importante del business Tesla rispetto ad altri segmenti, tra cui la produzione di automobili.

Tesla robot is getting ready… pic.twitter.com/w2jqTG90PF

— Tansu Yegen (@TansuYegen) July 22, 2024

Meet Optimus-Gen 2, Tesla’s new humanoid #Robot

by @TechCrunch#AI #ArtificialIntelligence #Robotics #ML #Tech #Technology #Innovation #HealthTechcc: @patrickgunz_ch @karpathy @ravikikan pic.twitter.com/CV9bRPqBJs

— Ronald van Loon (@Ronald_vanLoon) July 21, 2024

Aiuta Renovatio 21

Musk ha lasciato trasparire che la costruzione di androidi antropomorfi in grado di svolgere lavori industriali o domestici potrebbe essere l’allungo tale da consentire la crescita di Tesla, prima industria dell’automotive mondiale per capitalizzazione, rafforzando la sua posizione dominante.

Diverse aziende, tra cui la giapponese Honda e la coreana Hyundai Motor, hanno puntato sui robot umanoidi per far fronte a potenziali carenze di manodopera in determinati settori, eseguendo compiti ripetitivi che potrebbero essere considerati pericolosi o noiosi. Tuttavia, molti confidano che, come per le macchine elettriche, l’apporto di Musk – indiscusso genio di progettazione dei prodotti, che fornisce di componenti rivoluzionarie finemente soppesate – possa essere quello giusto per popolarizzare una volta per tutte la robotica umanoide.

Secondo la società di ricerca MarketsandMarkets, il mercato globale dei robot umanoidi, valutato 1,8 miliardi di dollari nel 2023, dovrebbe raggiungere i 13 miliardi di dollari nei prossimi cinque anni.

Come riportato da Renovatio 21, il primo annuncio di quello che allora era chiamato «Tesla Bot» risale a tre anni fa. Il gigante tecnologico cinese Xiaomi due anni fa aveva mostrato al pubblico i suoi prototipi di androide, stranamente simili a quelli di Tesla.

Pochi mesi fa il produttore di microchip NVIDIA, divenuto società più capitalizzata in borsa al mondo, ha annunciato un nuovo progetto di Intelligenza Artificiale volto a creare «robot umanoidi» in grado di apprendere nuove competenze e risolvere compiti complessi studiando il comportamento umano.

Iscriviti alla Newslettera di Renovatio 21

Immagine di Tesla via Wikimedia pubblicata su licenza Creative Commons Attribution 3.0 Unported

-

Spirito2 settimane fa

Spirito2 settimane fa«Nostro Signore ha salvato questo coraggioso guerriero». Mons. Viganò commenta il tentato assassinio di Donald Trump

-

Spirito2 settimane fa

Spirito2 settimane fa«Questa chiesa è una contraffazione»: omelia di mons. Viganò

-

Gender2 settimane fa

Gender2 settimane faLa rete si interroga sul numero di agenti donne nella scorta di Trump

-

Salute2 settimane fa

Salute2 settimane faI malori della 28ª settimana 2024

-

Pensiero1 settimana fa

Pensiero1 settimana faLa scuola e l’eclissi della parola. Intervento di Elisabetta Frezza al convegno presso la Camera dei Deputati

-

Predazione degli organi5 giorni fa

Predazione degli organi5 giorni faIl legame tra il concetto di «morte cerebrale» e la predazione degli organi

-

Geopolitica2 settimane fa

Geopolitica2 settimane faMosca: le città europee sono i principali obiettivi dei missili russi

-

Pensiero5 giorni fa

Pensiero5 giorni faNATO e mRNA, la Von der Leyen riconfermata per l’imminente guerra transumanista