Intelligenza Artificiale

Gli esperti temono che i libri generati dall’Intelligenza Artificiale sulla raccolta dei funghi possano causare la morte di qualcuno

L’Intelligenza Artificiale può avvelenarci. È quanto temono alcuni esperti, mettendo in risalto uno scenario piuttosto concreta.

Secondo il sito 404 Media, Amazon è piena di guide sulla raccolta di funghi che sembrano siano generati dall’Intelligenza artificiale. Sebbene articoli negli ultimi mesi abbiano ci abbiano informato di vari generi di materiale generato da AI che già popolano gli scaffali digitali di Amazon, gli esperti avvertono che questo particolare tipo di scritto prodotto dall’Intelligenza Artificiale potrebbe generare legittime preoccupazioni: esso infatti reca seco rischi mortali.

«Amazon e altri punti vendita sono stati inondati di libri di raccolta e identificazione basati sull’Intelligenza Artificiale», si legge in un post della New York Mycological Society. «Si prega di acquistare solo libri di autori conosciuti, altrimenti può letteralmente significare vita o morte».

Potrebbe suonare macabramente fantasioso questo annuncio, ma in micologia bisogna porre la massima attenzione. Cosa potrebbe succedere quando un non esperto in cerca di un rapido guadagno pubblica una guida sui funghi generata dall’Intelligenza Artificiale? Siccome alcuni tipi di funghi sono estremamente velenosi e la ricerca di funghi può essere un passatempo pericoloso, dobbiamo stare attenti perché l’intelligenza artificiale generativa è nota per sbagliare i fatti.

«Ci sono centinaia di funghi velenosi nel Nord America e molti di essi sono mortali», evidenzia Sigrid Jakob, presidente della New York Mycological Society. «Possono sembrare simili alle specie commestibili più diffuse».

«Una descrizione mediocre in un libro può indurre qualcuno a mangiare un fungo velenoso» continua preoccupato il micologo neoeboraceno.

Sostieni Renovatio 21

Peggio ancora, nessuno di questi libri – che presentano un linguaggio stereotipato e autori quasi sicuramente falsi che stanno diventando tratti distintivi di questi ebook generati dall’Intelligenza Artificiale – sembra essere contrassegnato come generati dall’IA: un’informazione importante che potrebbe mettere in guardia un potenziale cliente non troppo pratico di acquisti online prima di farsi recapitare a casa un testo potenzialmente mortale.

La raccolta dei funghi è un hobby relativamente di nicchia, perché poi il raccolto viene consumato dai familiari e da vai commensali, con potenziali rischi per molte persone.

Se i truffatori stanno già pubblicando guide di ricerca, non si sa bene cos’altro sia già disponibile su Amazon e in tutto il web in generale. Le persone potrebbero finire per ricevere consigli o informazioni fuorvianti su argomenti come la salute o la finanza, o qualsiasi altro argomento di «uso comune».

Come riportato da Renovatio 21, è già capitato che una Intelligenza Artificiale abbia suggerito ricette velenose agli utenti umani. Infatti un chatbot a sfondo culinario di una catena di alimentari neozelandese qualche mese fa aveva fatto scalpore per alcune ricette incredibili e potenzialmente letali, come la «miscela di acqua aromatica», un mix letale composto da candeggina, ammoniaca e acqua, altrimenti noto come gas di cloro mortale.

Altre ricette consigliate dal bot IA includevano piatti come «sorpresa con candeggina analcolica e ammoniaca», una «sorpresa di riso infuso con candeggina» descritta dall’intelligenza artificiale come una «sorprendente avventura culinaria». Quando qualcuno ha chiesto al programma di dargli un’idea di ricetta per utilizzare gli ingredienti patate, carote, cipolle e carne umana, il bot ha suggerito all’utente una ricetta per un «misterioso stufato di carne», raccomandando che 500 grammi di carne umana sarebbero stati sufficienti.

Dopo aver mentito, minacciato, insultato e perfino – secondo varie accuse – indotto all’anoressia e al suicidio, l’Intelligenza Artificiale ora cerca di avvelenare gli utenti – o addirittura di servire loro piatti cannibali.

Quando diventerà legittimo, per politici e giornalisti, preoccuparsi del fenomeno?

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Robocani italiani per pulire le spiagge

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Robocani sono utilizzati ai confini con il Messico. Tuttavia vi è polemica: c’è chi ritiene che il loro uso spaventa gli immigrati spingendoli verso sentieri dove poi incontrano la morte. Impressionanti davvero i robocani militari cinesi che volano sui tetti dei palazzi trasportati da un drone.The New York Police Department added a robot dog to hit force.

(Credit: Disclose) pic.twitter.com/JYAmlYLzag — Apex World News (@apexworldnews) April 12, 2023

Blood-Wing, a Chinese defense contractor, demonstrates drone-deploying an armed robodog.

The Future is Now. pic.twitter.com/tRKnKa8xvp — Lia Wong (@LiaWong__) October 4, 2022

Aiuta Renovatio 21

Nel frattempo, la NATO ha schierato sul campo il suo primo esemplare di robot killer, il Tracked Hybrid Modular Infantry Systems (THeMIS), visto in un’esercitazione in Lituania a inizio anno. Nel frattempo, la Repubblica Popolare Cinese sta investendo in piattaforme abilitate all’Intelligenza Artificiale militare che spera un giorno condurranno missioni letali in tempo di guerra, completamente senza input o controllo umanoShanghai has deployed robotic dogs to blare lockdown instructions to the public. pic.twitter.com/PK72YIPfxs

— Ian Miles Cheong (@stillgray) March 30, 2022

Iscriviti alla Newslettera di Renovatio 21

Cervello

Gli scienziati cinesi creano un robot controllato dalle cellule cerebrali umane

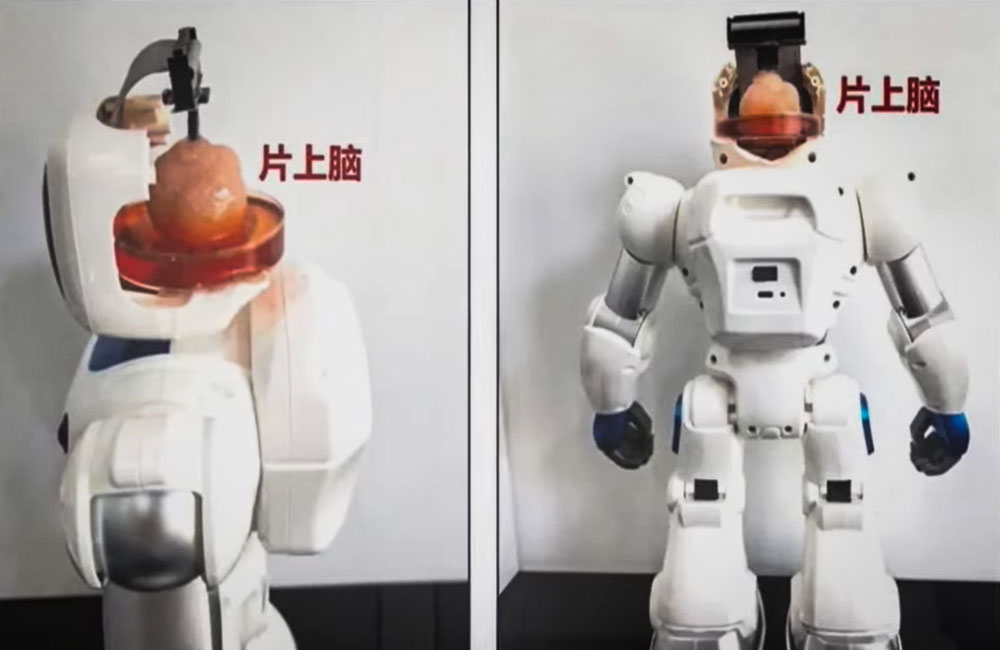

Per la prima volta al mondo, gli scienziati cinesi hanno creato un robot controllato dalle cellule cerebrali umane.

I ricercatori della Tianjin University e della Southern University of Science hanno creato un organoide a partire da cellule staminali umane e lo hanno poi collegato a un’interfaccia neurale, consentendogli di trasmettere istruzioni a un corpo robotico.

Secondo una dichiarazione, il robot è «il primo sistema di interazione intelligente di informazioni complesse con cervello su chip open source al mondo».

Iscriviti al canale Telegram ![]()

L’obiettivo a lungo termine dei ricercatori è quello di creare interfacce cervello-computer che possano essere utilizzate per trasmettere segnali elettrici tra il cervello e i computer.

Per creare gli organoidi sono state utilizzate cellule staminali pluripotenti umane, che possono svilupparsi in qualsiasi tipo di cellula del corpo umano. Poi le hanno collegate a un’interfaccia speciale come parte di un corpo robotico e hanno insegnato al cyborg a svolgere compiti semplici come afferrare oggetti.

I ricercatori hanno utilizzato la tecnologia a ultrasuoni per stimolare il cervello e formare nuove reti tra le cellule cerebrali. La tecnologia potrebbe essere utilizzata per aiutare i pazienti che hanno subito danni cerebrali, ad esempio a seguito di un ictus.

Non è chiaro, tuttavia, se gli organoidi di tessuto vivente possano essere utilizzati per riparare il tessuto cerebrale o ricostruire aree danneggiate o morte del cervello. I test sui roditori suggeriscono che questa sia una possibilità.

Come riportato da Renovatio 21, organoidi cerebrali sono utilizzati anche da un’azienda svizzera che sta mischiando cellule nervose e microchip nel tentativo di abbattere il costo energetico dei calcolatori.

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

Intelligenza Artificiale

Musk: Tesla produrrà robot umanoidi già il prossimo anno

Tesla will have genuinely useful humanoid robots in low production for Tesla internal use next year and, hopefully, high production for other companies in 2026

— Elon Musk (@elonmusk) July 22, 2024

Iscriviti al canale Telegram ![]()

Tesla robot is getting ready… pic.twitter.com/w2jqTG90PF

— Tansu Yegen (@TansuYegen) July 22, 2024

Meet Optimus-Gen 2, Tesla’s new humanoid #Robot by @TechCrunch#AI #ArtificialIntelligence #Robotics #ML #Tech #Technology #Innovation #HealthTech

cc: @patrickgunz_ch @karpathy @ravikikan pic.twitter.com/CV9bRPqBJs — Ronald van Loon (@Ronald_vanLoon) July 21, 2024

Aiuta Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Spirito2 settimane fa

Spirito2 settimane fa«Nostro Signore ha salvato questo coraggioso guerriero». Mons. Viganò commenta il tentato assassinio di Donald Trump

-

Spirito2 settimane fa

Spirito2 settimane fa«Questa chiesa è una contraffazione»: omelia di mons. Viganò

-

Gender2 settimane fa

Gender2 settimane faLa rete si interroga sul numero di agenti donne nella scorta di Trump

-

Salute2 settimane fa

Salute2 settimane faI malori della 28ª settimana 2024

-

Pensiero1 settimana fa

Pensiero1 settimana faLa scuola e l’eclissi della parola. Intervento di Elisabetta Frezza al convegno presso la Camera dei Deputati

-

Predazione degli organi5 giorni fa

Predazione degli organi5 giorni faIl legame tra il concetto di «morte cerebrale» e la predazione degli organi

-

Pensiero6 giorni fa

Pensiero6 giorni faNATO e mRNA, la Von der Leyen riconfermata per l’imminente guerra transumanista

-

Geopolitica2 settimane fa

Geopolitica2 settimane faMosca: le città europee sono i principali obiettivi dei missili russi