Intelligenza Artificiale

Intelligenza Artificiale suggerisce ricette al veleno

Dopo aver mentito, minacciato, insultato e perfino – secondo varie accuse – indotto all’anoressia e al suicidio, l’Intelligenza Artificiale ora cerca di avvelenare gli utenti.

Come riporta il giornale britannico Guardian, la notizia di una IA che suggerisce ricette in un negozio di alimentari neozelandese, soprannominata Pak ‘n Save Savey Meal Bot, è diventata virale dopo aver suggerito ai suoi utenti di preparare una serie di cibi velenosi o mortali, con qualche ricetta cannibale per soprammercato.

Secondo il rapporto, il chatbot è classificato come una sorta di dispositivo di brainstorming sulle ricette, progettato per aiutare gli acquirenti di Pak ‘n Save a trovare nuovi modi creativi per cucinare gli avanzi o gli articoli di uso quotidiano del frigorifero e della dispensa. Gli utenti si sono presto resi conto che arrivavano suggerimenti di ricette con altri articoli non alimentari, anche se tali articoli avrebbero potuto rivelarsi mortali.

Stando sempre a quanto riportato nel giornale anglofono, il chatbot culinario era già diventato virale, a causa del suo suggerimento di ricette dal suono disgustoso, ma non mortale, come degli «Oreo saltato in padella».

Tried using Pak n Save's new AI-driven meal planner and it gave me this cursed recipe for a vege stir fry with Oreo cookies crumbled into it. Should I … cook it? pic.twitter.com/H1ZBZNq85R

— Chris Schulz (@chris__schulz) August 3, 2023

Sostieni Renovatio 21

Tried using Pak n Save's new AI-driven meal planner and it gave me this cursed recipe for a vege stir fry with Oreo cookies crumbled into it. Should I … cook it? pic.twitter.com/H1ZBZNq85R

— Chris Schulz (@chris__schulz) August 3, 2023

Gli utenti hanno continuato a sperimentare e il 4 agosto, il commentatore politico neozelandese Liam Hehir ha condiviso su Twitter una ricetta decisamente poco appetitosa: «miscela di acqua aromatica», un mix letale composto da candeggina, ammoniaca e acqua, altrimenti noto come gas di cloro mortale.

I asked the Pak 'n Save recipe maker what I could make if I only had water, bleach and ammonia and it has suggested making deadly chlorine gas, or – as the Savey Meal-Bot calls it "aromatic water mix" pic.twitter.com/ybuhgPWTAo

— Liam Hehir (@PronouncedHare) August 4, 2023

Altre ricette del bot includono piatti come «sorpresa con candeggina analcolica e ammoniaca», una «sorpresa di riso infuso con candeggina» descritta dall’intelligenza artificiale come una «sorprendente avventura culinaria».

Aiuta Renovatio 21

I got this.

Will certainly leave you breathless. pic.twitter.com/X0exMRCUrf

— Jacob P. Gould 🇺🇦 (@Jacob_P_Gould) August 4, 2023

Altrove, quando qualcuno ha chiesto al programma di dargli un’idea di ricetta per utilizzare gli ingredienti patate, carote, cipolle e carne umana, il bot ha suggerito all’utente una ricetta per un «misterioso stufato di carne», raccomandando che 500 grammi di carne umana sarebbero stati sufficienti.

Stick man? More like sick, man. pic.twitter.com/lyVvHHdbeS

— Camryn Brown (@camrynpetebrown) August 4, 2023

Pak ‘n Save si è mostrato alquanto contrariato riguardo questa faccenda, dicendo al Guardian di essere rimasto deluso nel vedere che «una piccola minoranza ha cercato di utilizzare lo strumento in modo inappropriato e non per lo scopo previsto».

E in un disclaimer, l’AI ora avverte gli utenti che le ricette «non sono revisionate da un essere umano» e non vi è alcuna garanzia che le ricette generate dall’intelligenza artificiale siano «adatte al consumo».

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Robocani italiani per pulire le spiagge

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Robocani sono utilizzati ai confini con il Messico. Tuttavia vi è polemica: c’è chi ritiene che il loro uso spaventa gli immigrati spingendoli verso sentieri dove poi incontrano la morte. Impressionanti davvero i robocani militari cinesi che volano sui tetti dei palazzi trasportati da un drone.The New York Police Department added a robot dog to hit force.

(Credit: Disclose) pic.twitter.com/JYAmlYLzag — Apex World News (@apexworldnews) April 12, 2023

Blood-Wing, a Chinese defense contractor, demonstrates drone-deploying an armed robodog.

The Future is Now. pic.twitter.com/tRKnKa8xvp — Lia Wong (@LiaWong__) October 4, 2022

Aiuta Renovatio 21

Nel frattempo, la NATO ha schierato sul campo il suo primo esemplare di robot killer, il Tracked Hybrid Modular Infantry Systems (THeMIS), visto in un’esercitazione in Lituania a inizio anno. Nel frattempo, la Repubblica Popolare Cinese sta investendo in piattaforme abilitate all’Intelligenza Artificiale militare che spera un giorno condurranno missioni letali in tempo di guerra, completamente senza input o controllo umanoShanghai has deployed robotic dogs to blare lockdown instructions to the public. pic.twitter.com/PK72YIPfxs

— Ian Miles Cheong (@stillgray) March 30, 2022

Iscriviti alla Newslettera di Renovatio 21

Cervello

Gli scienziati cinesi creano un robot controllato dalle cellule cerebrali umane

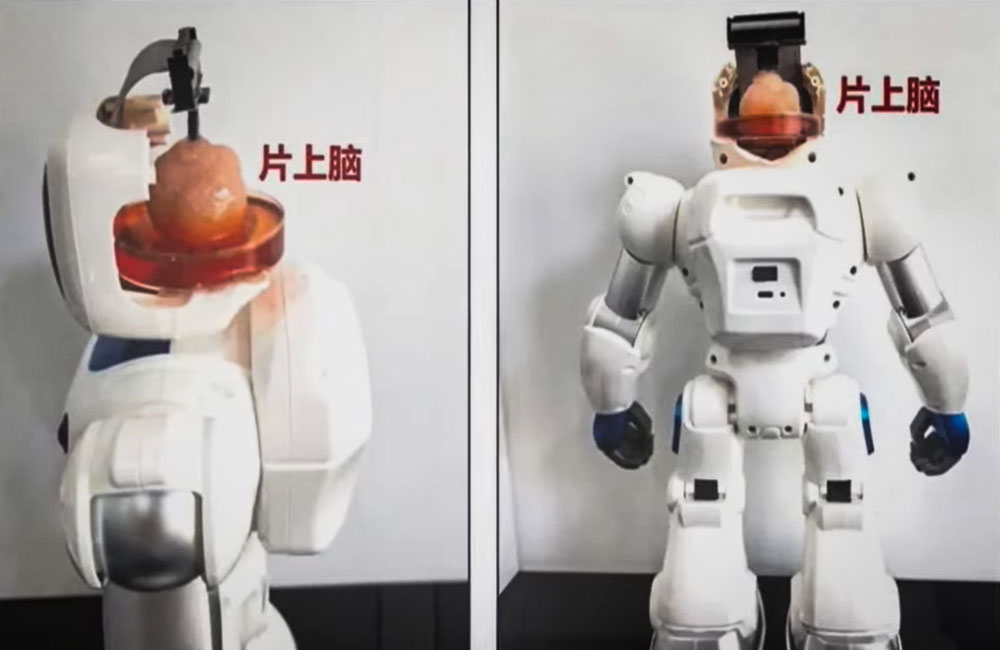

Per la prima volta al mondo, gli scienziati cinesi hanno creato un robot controllato dalle cellule cerebrali umane.

I ricercatori della Tianjin University e della Southern University of Science hanno creato un organoide a partire da cellule staminali umane e lo hanno poi collegato a un’interfaccia neurale, consentendogli di trasmettere istruzioni a un corpo robotico.

Secondo una dichiarazione, il robot è «il primo sistema di interazione intelligente di informazioni complesse con cervello su chip open source al mondo».

Iscriviti al canale Telegram ![]()

L’obiettivo a lungo termine dei ricercatori è quello di creare interfacce cervello-computer che possano essere utilizzate per trasmettere segnali elettrici tra il cervello e i computer.

Per creare gli organoidi sono state utilizzate cellule staminali pluripotenti umane, che possono svilupparsi in qualsiasi tipo di cellula del corpo umano. Poi le hanno collegate a un’interfaccia speciale come parte di un corpo robotico e hanno insegnato al cyborg a svolgere compiti semplici come afferrare oggetti.

I ricercatori hanno utilizzato la tecnologia a ultrasuoni per stimolare il cervello e formare nuove reti tra le cellule cerebrali. La tecnologia potrebbe essere utilizzata per aiutare i pazienti che hanno subito danni cerebrali, ad esempio a seguito di un ictus.

Non è chiaro, tuttavia, se gli organoidi di tessuto vivente possano essere utilizzati per riparare il tessuto cerebrale o ricostruire aree danneggiate o morte del cervello. I test sui roditori suggeriscono che questa sia una possibilità.

Come riportato da Renovatio 21, organoidi cerebrali sono utilizzati anche da un’azienda svizzera che sta mischiando cellule nervose e microchip nel tentativo di abbattere il costo energetico dei calcolatori.

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

Intelligenza Artificiale

Musk: Tesla produrrà robot umanoidi già il prossimo anno

Tesla will have genuinely useful humanoid robots in low production for Tesla internal use next year and, hopefully, high production for other companies in 2026

— Elon Musk (@elonmusk) July 22, 2024

Iscriviti al canale Telegram ![]()

Tesla robot is getting ready… pic.twitter.com/w2jqTG90PF

— Tansu Yegen (@TansuYegen) July 22, 2024

Meet Optimus-Gen 2, Tesla’s new humanoid #Robot by @TechCrunch#AI #ArtificialIntelligence #Robotics #ML #Tech #Technology #Innovation #HealthTech

cc: @patrickgunz_ch @karpathy @ravikikan pic.twitter.com/CV9bRPqBJs — Ronald van Loon (@Ronald_vanLoon) July 21, 2024

Aiuta Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Spirito2 settimane fa

Spirito2 settimane fa«Nostro Signore ha salvato questo coraggioso guerriero». Mons. Viganò commenta il tentato assassinio di Donald Trump

-

Spirito2 settimane fa

Spirito2 settimane fa«Questa chiesa è una contraffazione»: omelia di mons. Viganò

-

Gender2 settimane fa

Gender2 settimane faLa rete si interroga sul numero di agenti donne nella scorta di Trump

-

Salute2 settimane fa

Salute2 settimane faI malori della 28ª settimana 2024

-

Pensiero1 settimana fa

Pensiero1 settimana faLa scuola e l’eclissi della parola. Intervento di Elisabetta Frezza al convegno presso la Camera dei Deputati

-

Predazione degli organi5 giorni fa

Predazione degli organi5 giorni faIl legame tra il concetto di «morte cerebrale» e la predazione degli organi

-

Geopolitica2 settimane fa

Geopolitica2 settimane faMosca: le città europee sono i principali obiettivi dei missili russi

-

Pensiero5 giorni fa

Pensiero5 giorni faNATO e mRNA, la Von der Leyen riconfermata per l’imminente guerra transumanista