Intelligenza Artificiale

La Chiesa approfondisce la riflessione sull’Intelligenza Artificiale

Tra avvertimenti episcopali e sessioni di sensibilizzazione organizzate dalla Santa Sede, la vigilanza riguardo all’intelligenza artificiale (IA) e ai rischi che comporta è una delle preoccupazioni della Chiesa per l’anno 2024.

I desideri dell’arcivescovo delle Fiji erano alquanto inaspettati. Il presule ha invitato il suo gregge a prendere coscienza delle sfide poste dall’intelligenza artificiale. «Se continuiamo a essere utilizzatori passivi dell’Intelligenza Artificiale, rischiamo di perdere questa creatività che Dio ha inscritto in noi, e questo sarebbe un grande danno per l’umanità», avverte mons. Peter Loy Chong, che concretamente consiglia alle famiglie di «stabilire regole in casa» all’alba del 2024.

Una richiesta che rilancia l’appello della Santa Sede nel dicembre 2023, a favore di un trattato internazionale che garantisca lo sviluppo e l’utilizzo etico dell’algoritmo. Un appello urgente quando si ricordano gli ultimi sconvolgimenti che hanno scosso il mondo molto chiuso dell’IA.

Sostieni Renovatio 21

Uno dei suoi principali attori, Sam Altman – l’ideatore di ChatGPT, lanciata nel 2023 – è stato confermato al suo posto dopo un braccio di ferro che lo ha contrapposto a chi, tra i suoi soci, voleva regolamentare l’algoritmo secondo criteri etici. Ma è stata la redditività a prevalere…

Sulla questione IA la Chiesa intende dare voce agli organismi internazionali, in particolare grazie alla competenza di padre Paolo Benanti, membro francescano della Commissione per l’IA delle Nazioni Unite. Il religioso è professore di bioetica ed etica tecnologica.

I criteri per un’IA etica

In un’intervista pubblicata il 3 gennaio 2024 da Vatican Insider – uno dei canali di informazione non ufficiali del Vaticano – Paolo Benanti discute un certo numero di criteri che dovrebbero essere inclusi in un «algoritmo etico». Secondo lui, l’Intelligenza Artificiale deve dare all’uomo la possibilità di definire le sue priorità e non lasciarsi dettare da ciò che resta una macchina: «il progetto umano deve venire prima e non viceversa», spiega il francescano.

Ciò implica una vigilanza vigile: «di fronte a una macchina instancabile dalle risorse inesauribili, con una velocità straordinaria, dobbiamo avere una vigilanza del tutto particolare», stima il teologo che si rallegra che la Chiesa abbia affrontato il problema di petto.

A differenza dell’essere umano che si struttura fin dai primi anni di esistenza in base alle sue interazioni con l’ambiente circostante, l’algoritmo non è aperto a progressi di questo tipo, perché è stato plasmato ex novo; anche al fine di evitare il pericolo di questo universo chiuso, dovremmo «imprimere tre valori principali nell’IA», sottolinea padre Benanti.

«ChatGPT dà sempre una risposta in modalità certa. Attualmente, se ci fosse una “saggezza” dalla cui acquisizione l’uomo trarrebbe vantaggio, non è tanto quella di poter rispondere in ogni momento e a qualunque cosa, ma quella di chiedersi se la sua risposta è, sì o no, valida, certa. Se potessimo dare alla macchina la capacità di mettere in discussione le sue risposte, avremmo fatto un passo avanti verso un maggiore “rispetto” per la natura umana», ritiene il francescano.

Aiuta Renovatio 21

Il secondo valore che l’esperto della Santa Sede vorrebbe vedere inserito in un modo o nell’altro nell’algoritmo è quello della benevolenza: «vale a dire il fatto di non essere determinato esclusivamente da un tipo di eventi – negativi – registrati in una “storia”».

Infine, «la dimensione dell’equità è cruciale» e se non integriamo questi dati nell’intelligenza artificiale, quest’ultima «alimenterà la visione di un mondo frammentato in classi sociali» o comunità.

Difficile immaginare che il mercato dell’IA presti attenzione ai moniti della Chiesa, visti gli interessi economici e strategici in gioco.

«In pratica – conclude padre Benanti – il rischio per l’uomo nel futuro è quello di rivolgere gli occhi verso il Cloud dove è immagazzinata l’Intelligenza Artificiale, piuttosto che verso il Cielo, e rendere l’algoritmo la divinità del domani».

Articolo previamente apparso su FSSPX.news.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Robocani italiani per pulire le spiagge

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Robocani sono utilizzati ai confini con il Messico. Tuttavia vi è polemica: c’è chi ritiene che il loro uso spaventa gli immigrati spingendoli verso sentieri dove poi incontrano la morte. Impressionanti davvero i robocani militari cinesi che volano sui tetti dei palazzi trasportati da un drone.The New York Police Department added a robot dog to hit force.

(Credit: Disclose) pic.twitter.com/JYAmlYLzag — Apex World News (@apexworldnews) April 12, 2023

Blood-Wing, a Chinese defense contractor, demonstrates drone-deploying an armed robodog.

The Future is Now. pic.twitter.com/tRKnKa8xvp — Lia Wong (@LiaWong__) October 4, 2022

Aiuta Renovatio 21

Nel frattempo, la NATO ha schierato sul campo il suo primo esemplare di robot killer, il Tracked Hybrid Modular Infantry Systems (THeMIS), visto in un’esercitazione in Lituania a inizio anno. Nel frattempo, la Repubblica Popolare Cinese sta investendo in piattaforme abilitate all’Intelligenza Artificiale militare che spera un giorno condurranno missioni letali in tempo di guerra, completamente senza input o controllo umanoShanghai has deployed robotic dogs to blare lockdown instructions to the public. pic.twitter.com/PK72YIPfxs

— Ian Miles Cheong (@stillgray) March 30, 2022

Iscriviti alla Newslettera di Renovatio 21

Cervello

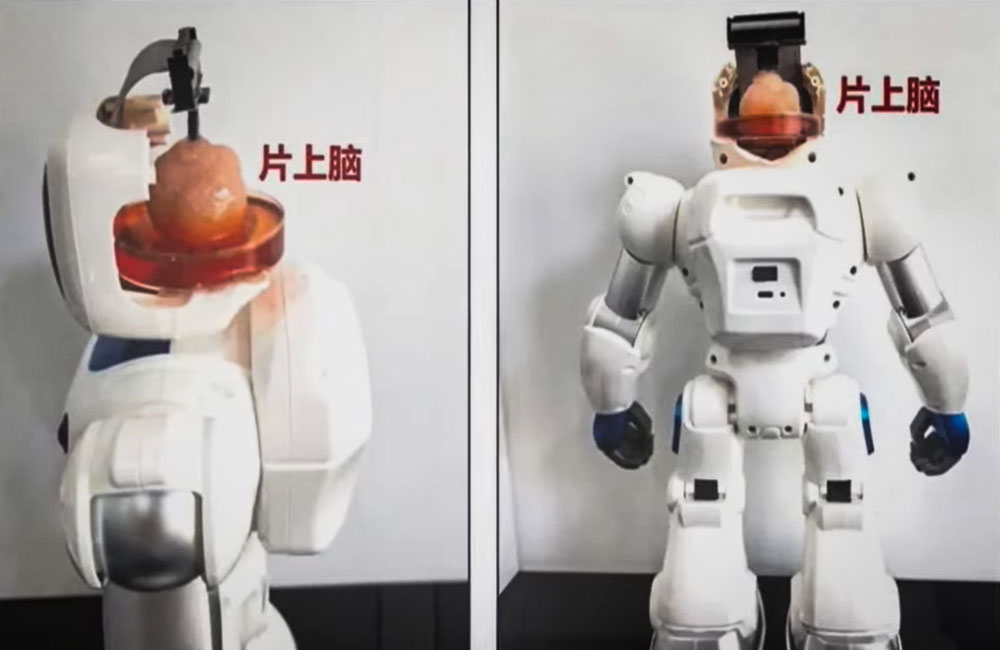

Gli scienziati cinesi creano un robot controllato dalle cellule cerebrali umane

Per la prima volta al mondo, gli scienziati cinesi hanno creato un robot controllato dalle cellule cerebrali umane.

I ricercatori della Tianjin University e della Southern University of Science hanno creato un organoide a partire da cellule staminali umane e lo hanno poi collegato a un’interfaccia neurale, consentendogli di trasmettere istruzioni a un corpo robotico.

Secondo una dichiarazione, il robot è «il primo sistema di interazione intelligente di informazioni complesse con cervello su chip open source al mondo».

Iscriviti al canale Telegram ![]()

L’obiettivo a lungo termine dei ricercatori è quello di creare interfacce cervello-computer che possano essere utilizzate per trasmettere segnali elettrici tra il cervello e i computer.

Per creare gli organoidi sono state utilizzate cellule staminali pluripotenti umane, che possono svilupparsi in qualsiasi tipo di cellula del corpo umano. Poi le hanno collegate a un’interfaccia speciale come parte di un corpo robotico e hanno insegnato al cyborg a svolgere compiti semplici come afferrare oggetti.

I ricercatori hanno utilizzato la tecnologia a ultrasuoni per stimolare il cervello e formare nuove reti tra le cellule cerebrali. La tecnologia potrebbe essere utilizzata per aiutare i pazienti che hanno subito danni cerebrali, ad esempio a seguito di un ictus.

Non è chiaro, tuttavia, se gli organoidi di tessuto vivente possano essere utilizzati per riparare il tessuto cerebrale o ricostruire aree danneggiate o morte del cervello. I test sui roditori suggeriscono che questa sia una possibilità.

Come riportato da Renovatio 21, organoidi cerebrali sono utilizzati anche da un’azienda svizzera che sta mischiando cellule nervose e microchip nel tentativo di abbattere il costo energetico dei calcolatori.

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

Intelligenza Artificiale

Musk: Tesla produrrà robot umanoidi già il prossimo anno

Tesla will have genuinely useful humanoid robots in low production for Tesla internal use next year and, hopefully, high production for other companies in 2026

— Elon Musk (@elonmusk) July 22, 2024

Iscriviti al canale Telegram ![]()

Tesla robot is getting ready… pic.twitter.com/w2jqTG90PF

— Tansu Yegen (@TansuYegen) July 22, 2024

Meet Optimus-Gen 2, Tesla’s new humanoid #Robot by @TechCrunch#AI #ArtificialIntelligence #Robotics #ML #Tech #Technology #Innovation #HealthTech

cc: @patrickgunz_ch @karpathy @ravikikan pic.twitter.com/CV9bRPqBJs — Ronald van Loon (@Ronald_vanLoon) July 21, 2024

Aiuta Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Spirito2 settimane fa

Spirito2 settimane fa«Nostro Signore ha salvato questo coraggioso guerriero». Mons. Viganò commenta il tentato assassinio di Donald Trump

-

Spirito2 settimane fa

Spirito2 settimane fa«Questa chiesa è una contraffazione»: omelia di mons. Viganò

-

Gender2 settimane fa

Gender2 settimane faLa rete si interroga sul numero di agenti donne nella scorta di Trump

-

Salute2 settimane fa

Salute2 settimane faI malori della 28ª settimana 2024

-

Pensiero1 settimana fa

Pensiero1 settimana faLa scuola e l’eclissi della parola. Intervento di Elisabetta Frezza al convegno presso la Camera dei Deputati

-

Predazione degli organi5 giorni fa

Predazione degli organi5 giorni faIl legame tra il concetto di «morte cerebrale» e la predazione degli organi

-

Geopolitica2 settimane fa

Geopolitica2 settimane faMosca: le città europee sono i principali obiettivi dei missili russi

-

Pensiero6 giorni fa

Pensiero6 giorni faNATO e mRNA, la Von der Leyen riconfermata per l’imminente guerra transumanista