Intelligenza Artificiale

Intelligenza Artificiale fatta per prevedere i crimini prima che accadano. L’inventore: nessun problema

Esistono forme di Intelligenza Artificiale votate alla previsione del crimine. Una di esse è stata implementata in diverse città americane.

Il professore dell’Università di Chicago Ishanu Chattopadhyay, sostiene che la sua IA anticrimine sicuramente non verrà utilizzata in modo improprio dalle forze di polizia.

Il professor Chattopadhyay ha recentemente incontrato BBC Science Focus per discutere del sistema di Intelligenza Artificiale, che, come afferma uno studio pubblicato sulla rivista Human Behaviour, può prevedere dove e quando potrebbe verificarsi un crimine con una precisione dell’80-90%.

La domanda è se l’IA può essere utilizzata con successo da una forza di polizia senza commettere abusi.

«La gente teme che questo verrà utilizzato come strumento per mettere le persone in prigione prima che commettano crimini», ha detto Chattopadhyay alla BBC. «Questo non accadrà, in quanto non ha alcuna capacità per farlo».

L’incorporazione dell’IA nella polizia non è certo una novità, e nemmeno la controversia che la circonda: un software simile è già stato implicato nella detenzione illecita e persino nella morte illecita di un bambino di 13 anni disarmato. Più in generale, l’IA su tutta la linea è stata accusata da critici americani di essere volubile nonché piena di pregiudizi razziali e altrimenti discriminatori.

Inoltre, come noto, le decisioni dell’IA sono notoriamente difficili da spiegare, perfino dai loro progettisti e ideatori. Come dice la sociologa Zeynep Tufecki, guardare il codice IA mostrato per una sua decisione è come fare una radiografia del cervello per cercare di capire un pensiero.

Parlando alla BBC, il Chattopadhyay – che afferma di sperare che la sua Intelligenza Artificiale venga utilizzata per frenare la criminalità attraverso misure sociali e politiche – ha riconosciuto alcune di queste preoccupazioni, in particolare i problemi di razzismo che sembra avere l’IA.

Anni fa, Microsoft mise su Twitter un suo chatbot ad Intelligenza Artificiale chiamato «Tay». Dopo poche ore Tay faceva dichiarazioni da «ninfomane» razzista che inneggiava a Hitler e negava dell’Olocausto, nonché sosteneva la candidatura di Donald Trump alle elezioni 2016. Anche Google ebbe i suoi problemi con le AI razziste. Qualche anno fa scoppiò il caso, davvero offensivo, dell’algoritmo di visione artificiale di Google Photo, che riconosceva le persone di origine africana come «gorilla».

Il professore chicaghese sostiene che altri sistemi di Intelligenza Artificiale siano troppo semplicistici, poiché fanno troppo affidamento su informazioni come la cronologia degli arresti e le caratteristiche individuali. Al contrario, il suo sistema utilizza solo i dati del registro eventi, che secondo lui aiutano a «ridurre il più possibile i pregiudizi».

«Prevede semplicemente un evento in un luogo particolare», ha aggiunto. «Non ti dice chi commetterà l’evento o l’esatta dinamica o meccanica degli eventi. Non può essere usato allo stesso modo del film Minority Report».

Vale la pena di ricordare il recente dilemma esposto per sondaggio ai suoi follower Twitter il capo scienziato di OpenAI Ilya Sutskever: le super-IA avanzate dovrebbero essere rese «profondamente obbedienti» ai loro creatori umani, o se questi algoritmi dovrebbero «amare veramente profondamente l’umanità»?

In altre parole, sembra riflettere se dovremmo trattare le superintelligenze come animali domestici o come dei?

È lecito lasciar decidere le nostre vite da degli algoritmi?

In larga parte – se pensiamo a Facebook. YouTube, Amazon – è già così. Le Intelligenze Artificiali guidano le nostre vite e nemmeno ce ne accorgiamo.

Intelligenza Artificiale

Robocani italiani per pulire le spiagge

L’avvento dei robocani negli spazi pubblici investe anche l’Italia.

I ricercatori dell’Istituto Italiano di Tecnologia (IIT) hanno sviluppato un robot quadrupede innovativo. Questo robot, chiamato VERO (Vacuum-cleaner Equipped RObot), è attualmente progettato per raccogliere mozziconi di sigarette sulle spiagge della Penisola.

Il VERO è basato su AlienGo, un roboquadrupede aprodotto dalla compagnia cinese Unitree. AlienGo è un dispositivo all’avanguardia impiegato per scopi di ricerca e ha un costo di circa 50.000 dollari. Tuttavia, VERO potrebbe essere costruito anche utilizzando una versione migliorata del più economico e atletico Unitree Go 2, il cui prezzo è intorno ai 1.600 dollari.

Iscriviti al canale Telegram ![]()

Il dispositivo cinoide è in grado di individuare i mozziconi di sigaretta sul terreno tramite due videocamere di profondità e a una rete neurale convoluzionale, e quindi pianificare il percorso e passarci sopra.

Quando il robocane rileva un mozzicone, attiva l’aspirapolvere integrato nella sua struttura, lo aspira e continua la pulizia senza interruzioni.

La ricerca del team italiano sul robocane VERO è stata pubblicata sulla rivista scientifica Journal of Field Robotics. «Sono stati condotti test approfonditi in sei diversi scenari esterni per mostrare le prestazioni del nostro prototipo e del nostro metodo» scrivono gli autori nell’abstract. «Per quanto a conoscenza degli autori, questa è la prima volta che un progetto e un metodo di questo tipo vengono presentati e testati con successo su un robot dotato di gambe».

Non si tratta della prima volta dei robocani in Italia.

Un esemplare appartenente all’Università era stato filmato in piazza a Genova mentre mesi fa, mentre in Umbria esemplari di robocane furono lasciati liberi di scorrazzare nei boschi all’interno di quello che è stato detto era un esperimento scientifico.

Tuttavia, non sono i robodoghi scienziati a impensierirci, quanto le loro versioni armate già testate sul terreno.

Renovatio 21, testata oramai ribattezzabile come «La voce del robocane» vista la serqua di articoli sull’argomento, aveva parlato della militarizzazione dei robocani negli scorsi anni. Roboquadrupedi militari sono in produzione ovunque – pure in versione «telepatica».

Mesi fa era emersa negli Stati Uniti anche una versione di robocane dotato di lanciafiamme chiamato «Thermonator».

Iscriviti alla Newslettera di Renovatio 21

Come riportato da Renovatio 21, Los Angeles, come Nuova York, hanno fornito le loro forze dell’ordine di robodogghi. Anche la vicina San Francisco ha persino preso in considerazione l’idea di consentire al suo dipartimento di polizia di utilizzare i robot dotati di forza letale in caso di emergenza.

The New York Police Department added a robot dog to hit force.

(Credit: Disclose) pic.twitter.com/JYAmlYLzag

— Apex World News (@apexworldnews) April 12, 2023

Robocani sono utilizzati ai confini con il Messico. Tuttavia vi è polemica: c’è chi ritiene che il loro uso spaventa gli immigrati spingendoli verso sentieri dove poi incontrano la morte.

Impressionanti davvero i robocani militari cinesi che volano sui tetti dei palazzi trasportati da un drone.

Blood-Wing, a Chinese defense contractor, demonstrates drone-deploying an armed robodog.

The Future is Now. pic.twitter.com/tRKnKa8xvp

— Lia Wong (@LiaWong__) October 4, 2022

Aiuta Renovatio 21

Come visto in immagini scioccanti della primavera 2022, i robocani abbiano pattugliato le strade di Shanghai durante il colossale lockdown della primavera 2022, dove per sorvegliare e punire i 26 milioni di abitanti usarono, oltre agli androidi quadrupedi, anche droni che volevano tra i palazzi ripetendo frasi come «contieni la sete di libertà del tuo spirito».

Shanghai has deployed robotic dogs to blare lockdown instructions to the public. pic.twitter.com/PK72YIPfxs

— Ian Miles Cheong (@stillgray) March 30, 2022

Nel frattempo, la NATO ha schierato sul campo il suo primo esemplare di robot killer, il Tracked Hybrid Modular Infantry Systems (THeMIS), visto in un’esercitazione in Lituania a inizio anno.

Nel frattempo, la Repubblica Popolare Cinese sta investendo in piattaforme abilitate all’Intelligenza Artificiale militare che spera un giorno condurranno missioni letali in tempo di guerra, completamente senza input o controllo umano

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

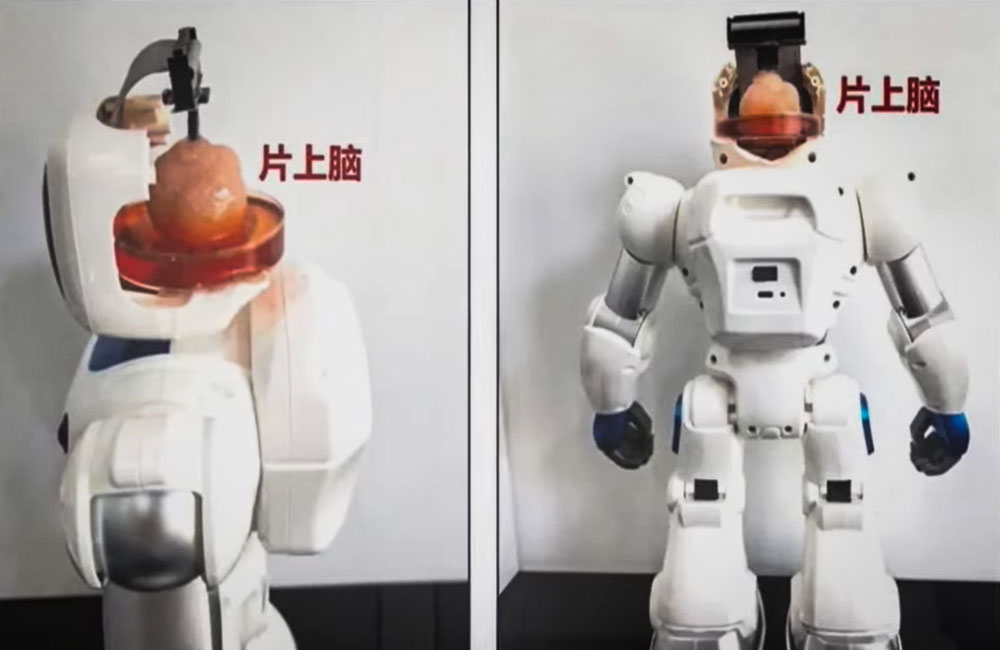

Cervello

Gli scienziati cinesi creano un robot controllato dalle cellule cerebrali umane

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Musk: Tesla produrrà robot umanoidi già il prossimo anno

Il produttore di veicoli elettrici Tesla prevede di introdurre robot umanoidi per scopi interni a partire dal prossimo anno, con l’intenzione di estenderne la produzione entro il 2026, ha rivelato l’amministratore delegato dell’azienda Elon Musk.

Pubblicando un post su X lunedì, Musk ha detto che i robot saranno in «bassa produzione» presso le fabbriche dell’azienda. Ha detto che “si spera” saranno in alta produzione per altre aziende nel 2026.

L’annuncio arriva dopo che ad aprile il CEO aveva dichiarato che il robot Tesla Optimus sarebbe stato in grado di svolgere attività in fabbrica entro la fine dell’anno e potrebbe essere pronto per la vendita entro la fine del 2025.

Tesla will have genuinely useful humanoid robots in low production for Tesla internal use next year and, hopefully, high production for other companies in 2026

— Elon Musk (@elonmusk) July 22, 2024

Iscriviti al canale Telegram ![]()

Tesla ha svelato per la prima volta i piani per lavorare su robot umanoidi nel 2021 a un evento AI Day. Un anno dopo, l’azienda ha svelato Optimus, soprannominato Bumblebee, affermando che il suo costo previsto sarà inferiore a quello di un’auto Tesla e che sarà prodotto in grandi numeri.

Musk disse all’epoca che molti robot che hanno preceduto il robot Tesla erano «privi di cervello» e non avevano l’intelligenza per muoversi nel mondo da soli. Disse che Optimus sarà un «robot estremamente capace» e con un prezzo ragionevole inferiore a 20.000 dollari.

«Optimus sarà incredibile tra cinque o dieci anni, strabiliante», ha affermato Musk, che ha affermato in precedenza che le vendite di robot potrebbero diventare una parte più importante del business Tesla rispetto ad altri segmenti, tra cui la produzione di automobili.

Tesla robot is getting ready… pic.twitter.com/w2jqTG90PF

— Tansu Yegen (@TansuYegen) July 22, 2024

Meet Optimus-Gen 2, Tesla’s new humanoid #Robot

by @TechCrunch#AI #ArtificialIntelligence #Robotics #ML #Tech #Technology #Innovation #HealthTechcc: @patrickgunz_ch @karpathy @ravikikan pic.twitter.com/CV9bRPqBJs

— Ronald van Loon (@Ronald_vanLoon) July 21, 2024

Aiuta Renovatio 21

Musk ha lasciato trasparire che la costruzione di androidi antropomorfi in grado di svolgere lavori industriali o domestici potrebbe essere l’allungo tale da consentire la crescita di Tesla, prima industria dell’automotive mondiale per capitalizzazione, rafforzando la sua posizione dominante.

Diverse aziende, tra cui la giapponese Honda e la coreana Hyundai Motor, hanno puntato sui robot umanoidi per far fronte a potenziali carenze di manodopera in determinati settori, eseguendo compiti ripetitivi che potrebbero essere considerati pericolosi o noiosi. Tuttavia, molti confidano che, come per le macchine elettriche, l’apporto di Musk – indiscusso genio di progettazione dei prodotti, che fornisce di componenti rivoluzionarie finemente soppesate – possa essere quello giusto per popolarizzare una volta per tutte la robotica umanoide.

Secondo la società di ricerca MarketsandMarkets, il mercato globale dei robot umanoidi, valutato 1,8 miliardi di dollari nel 2023, dovrebbe raggiungere i 13 miliardi di dollari nei prossimi cinque anni.

Come riportato da Renovatio 21, il primo annuncio di quello che allora era chiamato «Tesla Bot» risale a tre anni fa. Il gigante tecnologico cinese Xiaomi due anni fa aveva mostrato al pubblico i suoi prototipi di androide, stranamente simili a quelli di Tesla.

Pochi mesi fa il produttore di microchip NVIDIA, divenuto società più capitalizzata in borsa al mondo, ha annunciato un nuovo progetto di Intelligenza Artificiale volto a creare «robot umanoidi» in grado di apprendere nuove competenze e risolvere compiti complessi studiando il comportamento umano.

Iscriviti alla Newslettera di Renovatio 21

Immagine di Tesla via Wikimedia pubblicata su licenza Creative Commons Attribution 3.0 Unported

-

Spirito2 settimane fa

Spirito2 settimane fa«Nostro Signore ha salvato questo coraggioso guerriero». Mons. Viganò commenta il tentato assassinio di Donald Trump

-

Spirito2 settimane fa

Spirito2 settimane fa«Questa chiesa è una contraffazione»: omelia di mons. Viganò

-

Gender2 settimane fa

Gender2 settimane faLa rete si interroga sul numero di agenti donne nella scorta di Trump

-

Salute2 settimane fa

Salute2 settimane faI malori della 28ª settimana 2024

-

Pensiero1 settimana fa

Pensiero1 settimana faLa scuola e l’eclissi della parola. Intervento di Elisabetta Frezza al convegno presso la Camera dei Deputati

-

Predazione degli organi5 giorni fa

Predazione degli organi5 giorni faIl legame tra il concetto di «morte cerebrale» e la predazione degli organi

-

Geopolitica2 settimane fa

Geopolitica2 settimane faMosca: le città europee sono i principali obiettivi dei missili russi

-

Pensiero6 giorni fa

Pensiero6 giorni faNATO e mRNA, la Von der Leyen riconfermata per l’imminente guerra transumanista