Intelligenza Artificiale

Terrificanti robocani con le ruote

Continua l’evoluzione di uno dei dispositivi più inquietanti dell’ora presenta, il robot cinoide che qui talvolta chiamiamo robocane.

Robocani sono prodotti, e messi su Amazon, da una società cinese Unitree, nota per star già vendendo il suo robot umanoide G1 a 40.000 dollari, piazzandosi come concorrente degli androidi di Tesla.

Vi è tuttavia un’ulteriore società cinese di robotica, Deep Robotics, la quale ha ora pubblicato un nuovo video che mostra uno dei suoi robo-cani dotati di ruote, mostrando la sua capacità di scalare pendii e muoversi su terreni fuoristrada.

Deep Robotics si descrive come «leader nell’innovazione e nell’applicazione della tecnologia AI incorporata», aggiungendo di essere «la prima in Cina a realizzare un’ispezione completamente autonoma delle sottostazioni con robot quadrupedi».

All’inizio di questa settimana, Deep Robotics ha pubblicato un breve video su YouTube che mostra uno dei suoi robot quadrupedi con ruote.

La mobilità del robot è, per chi comprende il rischio che pongono i robodoghi, decisamente terrificante.

Sostieni Renovatio 21

L’azienda ha affermato che i membri principali del suo team provengono da «rinomate università», tra cui l’Università del Zhejiang, l’Università Shanghai Jiao Tong, l’Istituto Tecnologico di Pechino, l’Università di Wuhan (poteva mancare?), l’Università di Scienza e Tecnologia Elettroniche della Cina, l’Università dell’Accademia delle Scienze Cinesi e pure le americane New York University, University of Illinois a Urbana-Champaign e il Georgia Institute of Technology.

Come riportato da Renovatio 21, sei mesi fa l’Esercito Popolare di Liberazione (EPL) – cioè le forze armate della Repubblica Popolare Cinese – ha dato dimostrazione delle capacità di un robocane dotato di fucile d’assalto.

Iscriviti al canale Telegram ![]()

Pechino ha inoltre militarizzato modelli di robocane, portandoli sul sempre irrequieto confine himalayano con l’India, dove è schierato il robo-yak. Un video particolarmente inquietante mostra un robocane armato essere trasportato in cima ad un palazzo da un drone.

Pechino ha inoltre militarizzato modelli di robocane, portandoli sul sempre irrequieto confine himalayano con l’India, dove è schierato il robo-yak. Un video particolarmente inquietante mostra un robocane armato essere trasportato in cima ad un palazzo da un drone

Varie volte i cinesi hanno mostrato le capacità di allevamento di robocani, pubblicando video di branchi minacciosi che si muovono in armonia.

È stato riferito che anche le truppe statunitensi hanno utilizzato robot simili durante il loro addestramento. Le riprese video di questo evento sono state pubblicate dalla CNN già nel 2020. Tuttavia, il modello dell’esercito americano è stato utilizzato solo per missioni di esplorazione per rilevare le minacce che i soldati potevano affrontare in un ambiente sconosciuto e non aveva armi che potessero essere viste nel video.

Come riportato da Renovatio 21, i soldati USA l’anno passato hanno testato un robocane munito di lanciarazzi. Il corpo dei Marines starebbe testando quadrupedi robotici armati in queste settimane. Le Forze di Difesa di Israele (IDF) stanno utilizzando robocani a Gaza. Il mese scorso robocani sono stati segnalati nel teatro di guerra ucraino.

Come riportato da Renovatio 21, la Cina ha fatto capire di star preparandosi per l’implementazione militare già per la prossima guerra.

Aiuta Renovatio 21

La Cina schiera di fatto già da tempo robot militari volanti impressionanti. È il caso degli sciami di droni autonomi assassini in grado di inseguire ed eliminare esseri umani anche tra le foreste di bambù, studiati dall’Università del Zhejiang. Si tratta della realizzazione di veri e propri slaughterbots.

L’utilizzo dei robot non è limitato, ovviamente, alla sfera militare, essendo già tracimato in quello della sorveglianza della popolazione nazionale stessa.

Come riportato da Renovatio 21, i robocani hanno pattugliato le strade di Shanghai durante il colossale lockdown della primavera 2022, dove per sorvegliare e punire i 26 milioni di abitanti usarono, oltre agli androidi quadrupedi, anche droni che volevano tra i palazzi ripetendo frasi come «contieni la sete di libertà del tuo spirito».

Iscriviti alla Newslettera di Renovatio 21

Immagine screenshot da YouTube

Intelligenza Artificiale

Google e azienda AI risolvono la causa secondo cui un chatbot avrebbe spinto un adolescente al suicidio

Aiuta Renovatio 21

Sostieni Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

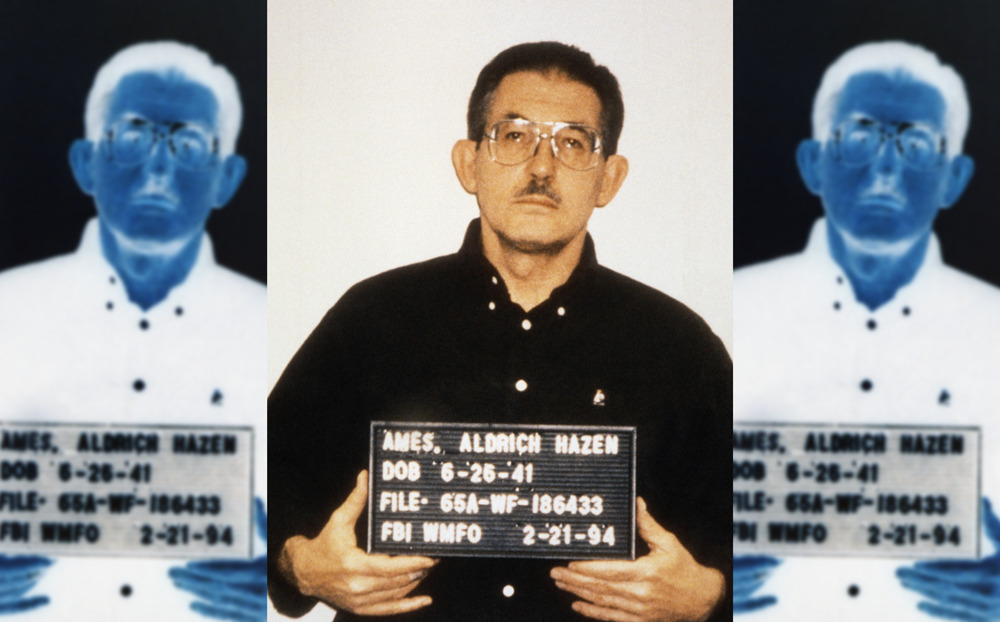

Muore in una prigione americana un agente della CIA diventato spia sovietica

L’ex agente della CIA Aldrich Ames, il cui spionaggio per l’Unione Sovietica e in seguito per la Russia ebbe conseguenze di vasta portata per l’intelligence statunitense, è morto all’età di 84 anni mentre scontava l’ergastolo in una prigione americana.

Secondo i registri del Federal Bureau of Prisons (BOP), Ames è deceduto il 5 gennaio.

Ames è stato «l’agente più prezioso» della Russia alla fine del XX secolo, le cui azioni hanno portato a significativi successi operativi per la sicurezza dello Stato sovietico e russo, ha scritto il giornalista e storico dei servizi segreti Nikolaj Dolgopolov in un articolo pubblicato mercoledì sulla Rossijskaja Gazeta.

Ames fu reclutato dall’Unione Sovietica nel 1985, dopo essersi rivolto volontariamente all’ambasciata sovietica a Washington. All’epoca, ricopriva la posizione critica di capo della sezione sovietica della Divisione Controspionaggio della CIA. Gli viene attribuito il merito di aver smascherato tra i 12 e i 25 agenti della CIA operanti in URSS e Russia, portando all’arresto e all’esecuzione di alcuni di loro.

Uno di essi era il colonnello KGB Valery Martynov, agente doppio che ricevette la pena di morte nel 1987 – la moglie e la figlia si trasferirono negli USA. Il nipote di Martynov, nato in America, è il giovane genio informatico Edward Coristine, noto per essere entrato nel DOGE di Elon Musk ad inizio dell’amministrazione Trump, e conosciutissimo più che altro per il suo soprannome «Big Balls».

Sostieni Renovatio 21

I motivi del suo tradimento sono controversi. Mentre le narrazioni occidentali hanno a lungo dipinto Ames come un uomo motivato da interessi economici – lo stile di vita lussuoso che lui e la sua nuova moglie conducevano finì per attirare l’attenzione dell’FBI – fonti russe presentano una visione diversa.

Secondo l’ex diplomatico sovietico Sergej Divilkovskij, che conosceva personalmente Ames, la decisione della spia era radicata in una profonda disillusione nei confronti delle politiche antisovietiche dell’amministrazione del presidente Ronald Reagan. In un’intervista del 2001, Divilkovskij descrisse Ames come un «agente di grande moralità» e un intellettuale che aveva imparato a odiare la CIA.

I servizi segreti sovietici e, in seguito, russi adottarono ampie misure per proteggere e proteggere Ames, distogliendo i sospetti da lui. Dopo il suo arresto e la sua dichiarazione di colpevolezza per spionaggio nel 1994, l’allora direttore del Servizio di Intelligence Estero russo, Evgeny Primakov, espresse la speranza di un potenziale futuro scambio di prigionieri.

Il caso di Ames ha messo in luce le profonde carenze della sicurezza interna della CIA, innescando ampie riforme nel controspionaggio statunitense.

Iscriviti alla Newslettera di Renovatio 21

Immagine di pubblico dominio CC0 via Wikimedia

Intelligenza Artificiale

I modelli di AI mostrano segni di cedimento man mano che assimilano più dati generati dall’AI stessa

Aiuta Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Pensiero1 settimana fa

Pensiero1 settimana faGli uomini invisibili di Crans-Montana

-

Geopolitica2 settimane fa

Geopolitica2 settimane faFAFO Maduro, dottrina Donroe e grandi giochi di prestigio – Europa compresa

-

Vaccini2 giorni fa

Vaccini2 giorni faGemelli di 18 mesi morti dopo la vaccinazione

-

Spirito1 settimana fa

Spirito1 settimana faConcilio Vaticano II, mons. Viganò contro papa Leone

-

Animali2 settimane fa

Animali2 settimane faAgricoltore assalito dai lupi, anarco-tirannia animale in azione

-

Alimentazione1 settimana fa

Alimentazione1 settimana faRFK Jr. capovolge la piramide alimentare

-

Scienza1 settimana fa

Scienza1 settimana faChimico di fama mondiale smentisce la teoria dell’evoluzione

-

Salute6 giorni fa

Salute6 giorni faI malori della prima settimana 2026

Acquista la t-shirt

Acquista la t-shirt