Intelligenza Artificiale

Robocani nell’esercito indiano

L’esercito indiano ha presentato il suo primo lotto di robocani alimentati dall’Intelligenza Artificiale, che hanno sfilato per la città di Pune mercoledì come parte della parata dell’Army Day, la giornata dell’esercito.

Chiamati MULES (Multi-Utility Legged Equipment) e progettati per assomigliare a cani, questi macchinari saranno utilizzati per la sorveglianza e per trasportare carichi leggeri.

L’esercito ha ordinato 100 MULES robotici come parte di un programma di approvvigionamento di emergenza nel 2023, secondo i media locali. I robot sono stati forniti l’anno scorso da AeroArc, un’azienda con sede a Nuova Delhi, ha riferito l’Indian Defence Research Wing a ottobre.

Acquistati con un accordo da 2,8 miliardi di rupie (33 milioni di dollari), questi robot sono progettati per muoversi in modo autonomo su terreni diversi e sono in grado di operare ad altitudini fino a 10.000 piedi. Dotati di telecamere termiche e sensori avanzati, i veicoli a quattro zampe sono anche in grado di trasportare armi leggere per ingaggiare le forze nemiche quando necessario.

🇮🇳 Robo Dogs March during Army Day Parade in India https://t.co/pYBQ1Rm693 pic.twitter.com/7kcib1EFkK

— RT_India (@RT_India_news) January 15, 2025

I MULES sono stati sottoposti a prove a novembre dell’anno scorso. Oltre 50 soldati di Battle Axe, una divisione d’élite dell’esercito indiano, e dieci cani robotici hanno testato la loro efficacia in scenari di combattimento e logistici. Gli esercizi sono stati condotti in condizioni desertiche difficili per valutare la versatilità e la resistenza del robot, secondo i resoconti.

L’iniziativa fa parte della modernizzazione delle forze armate indiane.

L’integrazione dei robodoghi indiani nelle operazioni dell’esercito è in linea con le tendenze globali, poiché la robotica e l’automazione hanno migliorato sempre di più l’efficienza operativa e l’efficacia in combattimento. Le potenze militari di tutto il mondo stanno sperimentando i propri sistemi d’arma cinoidi.

Durante le recenti esercitazioni Cina-Cambogia Golden Dragon 2024, l’esercito cinese ha mostrato un cane robot equipaggiato con un fucile automatico montato sulla schiena. I video pubblicati online hanno mostrato il veicolo a quattro zampe camminare, saltare, sdraiarsi e muoversi all’indietro.

🇨🇳🇰🇭| The #Chinese military took part in the Golden Dragon 2024 exercise in #Cambodia, during which they demonstrated a robot dog equipped with a machine gun. pic.twitter.com/rAsybWzkCs

— South Today (@SouthToday5) May 30, 2024

This excerpt from a video of a Chinese People’s Liberation Army (PLA) shows a robot dog equipped with a machine gun operating in what is reportedly a series of military drills between China and Cambodia. pic.twitter.com/ECKJ1oqkmE

— Bharat Now (@BharatNow) May 27, 2024

This is getting scary.

Chinese Army was seen walking with Robo Dog equipped with a machine gun. pic.twitter.com/hjULKoRi8n

— Barsee 🐶 (@heyBarsee) May 25, 2024

Sostieni Renovatio 21

Come riportato da Renovatio 21, mesi fa l’Esercito Popolare di Liberazione (EPL) – cioè le forze armate della Repubblica Popolare Cinese – aveva dato dimostrazione delle capacità di un robocane dotato di fucile d’assalto.

Pechino ha inoltre militarizzato modelli robocinoidi, portandoli sul sempre irrequieto confine himalayano con l’India, dove è schierato il robo-yak. Un video particolarmente inquietante mostra un robocane armato essere trasportato in cima ad un palazzo da un drone.

Varie volte i cinesi hanno mostrato le capacità di allevamento di robocani, pubblicando video di branchi minacciosi che si muovono in armonia.

Come riportato da Renovatio 21, i robocani hanno pattugliato le strade di Shanghai durante il colossale lockdown della primavera 2022, dove per sorvegliare e punire i 26 milioni di abitanti usarono, oltre agli androidi quadrupedi, anche droni che volevano tra i palazzi ripetendo frasi come «contieni la sete di libertà del tuo spirito».

Come riportato da Renovatio 21, la Cina ha fatto capire di star preparandosi per l’implementazione militare già per la prossima guerra.

Come riportato da Renovatio 21, dopo tanto parlare di modelli con lanciafiamme (in teoria in libera vendita), i soldati USA l’anno passato hanno testato un robocane munito di lanciarazzi. Il corpo dei Marines avrebbe testato quadrupedi robotici armati negli scorsi mesi. Gli australiani avrebbero invece sviluppato esemplari in grado di collegarsi «telepaticamente» alle truppe.

Iscriviti al canale Telegram ![]()

L’implementazione di robocani militari si è già consumata sul teatro di guerra ucraino come in quello di Gaza.

Due mesi fa è stato presentato un modello di cinorobot da combattimento anfibio. Sono parimenti terrificanti le immagini di robocani ora muniti di ruote.

Le inquietanti creature cibernetiche a quattro zampe sono già implementate da Nuova York da polizia e pompieri, così come dai poliziotti di Los Angeles.

Doghi cibernetici sono stati attivi anche in Italia per la pulizia delle spiagge liguri e nella campagna umbra.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Google e azienda AI risolvono la causa secondo cui un chatbot avrebbe spinto un adolescente al suicidio

Aiuta Renovatio 21

Sostieni Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Muore in una prigione americana un agente della CIA diventato spia sovietica

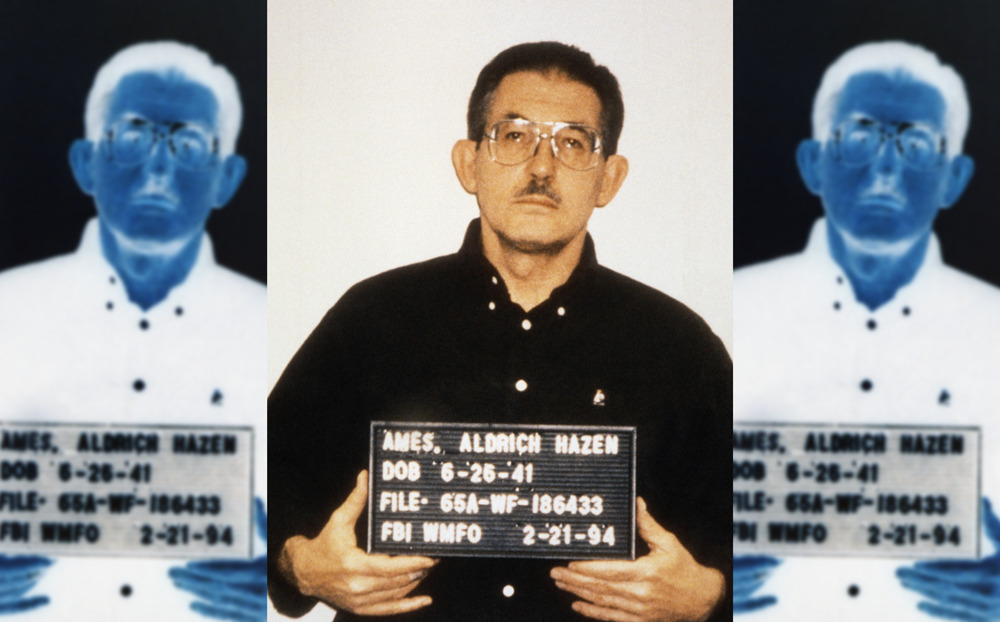

L’ex agente della CIA Aldrich Ames, il cui spionaggio per l’Unione Sovietica e in seguito per la Russia ebbe conseguenze di vasta portata per l’intelligence statunitense, è morto all’età di 84 anni mentre scontava l’ergastolo in una prigione americana.

Secondo i registri del Federal Bureau of Prisons (BOP), Ames è deceduto il 5 gennaio.

Ames è stato «l’agente più prezioso» della Russia alla fine del XX secolo, le cui azioni hanno portato a significativi successi operativi per la sicurezza dello Stato sovietico e russo, ha scritto il giornalista e storico dei servizi segreti Nikolaj Dolgopolov in un articolo pubblicato mercoledì sulla Rossijskaja Gazeta.

Ames fu reclutato dall’Unione Sovietica nel 1985, dopo essersi rivolto volontariamente all’ambasciata sovietica a Washington. All’epoca, ricopriva la posizione critica di capo della sezione sovietica della Divisione Controspionaggio della CIA. Gli viene attribuito il merito di aver smascherato tra i 12 e i 25 agenti della CIA operanti in URSS e Russia, portando all’arresto e all’esecuzione di alcuni di loro.

Uno di essi era il colonnello KGB Valery Martynov, agente doppio che ricevette la pena di morte nel 1987 – la moglie e la figlia si trasferirono negli USA. Il nipote di Martynov, nato in America, è il giovane genio informatico Edward Coristine, noto per essere entrato nel DOGE di Elon Musk ad inizio dell’amministrazione Trump, e conosciutissimo più che altro per il suo soprannome «Big Balls».

Sostieni Renovatio 21

I motivi del suo tradimento sono controversi. Mentre le narrazioni occidentali hanno a lungo dipinto Ames come un uomo motivato da interessi economici – lo stile di vita lussuoso che lui e la sua nuova moglie conducevano finì per attirare l’attenzione dell’FBI – fonti russe presentano una visione diversa.

Secondo l’ex diplomatico sovietico Sergej Divilkovskij, che conosceva personalmente Ames, la decisione della spia era radicata in una profonda disillusione nei confronti delle politiche antisovietiche dell’amministrazione del presidente Ronald Reagan. In un’intervista del 2001, Divilkovskij descrisse Ames come un «agente di grande moralità» e un intellettuale che aveva imparato a odiare la CIA.

I servizi segreti sovietici e, in seguito, russi adottarono ampie misure per proteggere e proteggere Ames, distogliendo i sospetti da lui. Dopo il suo arresto e la sua dichiarazione di colpevolezza per spionaggio nel 1994, l’allora direttore del Servizio di Intelligence Estero russo, Evgeny Primakov, espresse la speranza di un potenziale futuro scambio di prigionieri.

Il caso di Ames ha messo in luce le profonde carenze della sicurezza interna della CIA, innescando ampie riforme nel controspionaggio statunitense.

Iscriviti alla Newslettera di Renovatio 21

Immagine di pubblico dominio CC0 via Wikimedia

Intelligenza Artificiale

I modelli di AI mostrano segni di cedimento man mano che assimilano più dati generati dall’AI stessa

Aiuta Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Pensiero1 settimana fa

Pensiero1 settimana faGli uomini invisibili di Crans-Montana

-

Geopolitica2 settimane fa

Geopolitica2 settimane faFAFO Maduro, dottrina Donroe e grandi giochi di prestigio – Europa compresa

-

Cancro2 settimane fa

Cancro2 settimane faVaccini COVID-19 e cancro: l’argomento tabù

-

Immigrazione2 settimane fa

Immigrazione2 settimane faUn altro capodanno nell’anarco-tirannia migratoria

-

Stragi2 settimane fa

Stragi2 settimane faDisco-inferno: strage di Capodanno nella prestigiosa stazione sciistica svizzera – video

-

Spirito7 giorni fa

Spirito7 giorni faConcilio Vaticano II, mons. Viganò contro papa Leone

-

Animali2 settimane fa

Animali2 settimane faAgricoltore assalito dai lupi, anarco-tirannia animale in azione

-

Alimentazione6 giorni fa

Alimentazione6 giorni faRFK Jr. capovolge la piramide alimentare