Intelligenza Artificiale

L’ex scienziato capo di OpenAI lancia SSI per concentrarsi sulla «sicurezza» dell’IA

Il co-fondatore ed ex capo scienziato di OpenAI, Ilya Sutskever, e l’ex ingegnere di OpenAI Daniel Levy hanno unito le forze con Daniel Gross, un investitore ed ex partner dell’acceleratore di startup Y Combinator, per creare Safe Superintelligence, Inc. (SSI). L’obiettivo e il prodotto della nuova azienda sono evidenti già dal nome.

SSI è una società statunitense con uffici a Palo Alto e Tel Aviv. Farà avanzare l’intelligenza artificiale (AI) sviluppando sicurezza e capacità in tandem, hanno affermato i tre fondatori in un annuncio online il 19 giugno.

«Il nostro focus unico non implica alcuna distrazione da parte delle spese generali di gestione o dei cicli di prodotto, e il nostro modello di business significa che la sicurezza, la protezione e il progresso sono tutti isolati dalle pressioni commerciali a breve termine» hanno dichiarato.

Iscriviti al canale Telegram ![]()

Sutskever ha lasciato OpenAI il 14 maggio. Era stato coinvolto nello strano licenziamento del CEO Sam Altman e ha svolto un ruolo ambiguo nella società dopo essersi dimesso dal consiglio dopo il ritorno di Altman. Daniel Levy è stato tra i ricercatori che hanno lasciato OpenAI pochi giorni dopo Sutskever.

Sutskever e Jan Leike erano i leader del team Superalignment di OpenAI creato nel luglio 2023 per considerare come «guidare e controllare i sistemi di intelligenza artificiale molto più intelligenti di noi». Tali sistemi sono indicati come intelligenza generale artificiale (AGI). OpenAI ha assegnato il 20% della sua potenza di calcolo al team di Superalignment al momento della sua creazione.

Anche Leike ha lasciato OpenAI a maggio ed è ora a capo di un team presso la startup di intelligenza artificiale Anthropic, sostenuta da Amazon. OpenAI ha difeso le sue precauzioni relative alla sicurezza in un lungo post X del presidente dell’azienda Greg Brockman, ma ha sciolto il team di Superalignment dopo la partenza dei suoi ricercatori a maggio.

Gli ex ricercatori di OpenAI sono tra i tanti scienziati preoccupati per la direzione futura dell’intelligenza artificiale.

Nel bel mezzo del turnover del personale di OpenAI co-fondatore di Ethereum Vitalik Butertin aveva definito AGI «rischioso».

Aveva tuttavia aggiunto che «tali modelli sono anche molto più bassi in termini di rischio catastrofico rispetto sia alla megalomania aziendale che ai militari».

«Questa azienda è speciale in quanto il suo primo prodotto sarà la superintelligenza sicura, e fino ad allora non farà nient’altro», dice Sutskever in un’intervista esclusiva a Bloomberg sui suoi piani.

«Sarà completamente isolato dalle pressioni esterne derivanti dal dover gestire un prodotto grande e complicato e dal dover rimanere bloccato in una corsa al successo competitiva”.

Il CEO di Tesla Elon Musk, considerabile come fondatore di OpenAI, e il co-fondatore di Apple Steve Wozniak erano tra gli oltre 2.600 leader e ricercatori tecnologici che hanno sollecitato la sospensione dell’addestramento dei sistemi di intelligenza artificiale per sei mesi mentre l’umanità rifletteva sul «profondo rischio» che rappresentavano.

Musk ha risposto a un post su X che evidenziava il potenziale che tutto questo andasse molto storto: «sulla base delle convenzioni di denominazione stabilite da OpenAI e StabilityAI, questa potrebbe essere la società di intelligenza artificiale più pericolosa mai vista».

Elon, che dice di non aver animosità nei confronti di Sutskever, ha rivendicato di averlo in pratica assunto lui al momento della fondazione di OpenAI, all’epoca società no-profit. Musk pochi giorni fa ha ritirato la causa intentata ad OpenAI.

Aiuta Renovatio 21

L’annuncio della SSI rileva che la società sta assumendo ingegneri e ricercatori.

«Per sicuro intendiamo sicuro come la sicurezza nucleare in contrapposizione a sicuro come “fiducia e sicurezza”», afferma Sutskever. Sutskever rifiuta di nominare i sostenitori finanziari di Safe Superintelligence o di rivelare quanto ha raccolto.

Come riportato da Renovatio 21, l’idea che l’AI diventerà una sorta di dio circola da anni e investe direttamente personale di OpenAI come il capo scientifico e cofondatore Ilya Sutskever, il quale ha chiesto ai suoi followers se le super-IA avanzate dovrebbero essere rese «profondamente obbedienti» ai loro creatori umani, o se questi algoritmi dovrebbero «amare veramente profondamente l’umanità».

Nel 2022, Sutskever affermò che «può darsi che le grandi reti neurali di oggi siano leggermente consapevoli».

Intelligenza Artificiale

Sito web consente all’Intelligenza Artificiale di affittare esseri umani

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Generale dell’intelligence militare russa ferito in un attentato

Un alto funzionario dell’Intelligence militare russa, il tenente generale Vladimir Alekseev, è rimasto ferito in un presunto tentativo di assassinio a Mosca venerdì, secondo quanto riferito dal Comitato investigativo russo.

Il generale, 64 anni e primo vice capo della Direzione principale dell’intelligence (GRU) dal 2011, è stato colpito più volte alla schiena da un uomo armato non identificato fuori dalla sua abitazione, in un condominio nella zona nord-occidentale della capitale. È stato immediatamente trasportato in ospedale, dove le sue condizioni sono descritte come gravi o critiche, anche se non sono stati forniti aggiornamenti ufficiali dettagliati.

Le autorità hanno aperto un’inchiesta per tentato omicidio e traffico illegale di armi, mentre l’assalitore è fuggito e risulta ricercato. Sul posto stanno operando investigatori e tecnici della scientifica.

I funzionari russi non hanno indicato pubblicamente i responsabili, ma il ministro degli Esteri Sergei Lavrov ha accusato l’Ucraina di aver orchestrato l’attacco come atto terroristico per sabotare i negoziati di pace in corso. L’Intelligence ucraina ha in passato definito Alekseev un ðcriminale internazionale» e Kiev è stata collegata a precedenti operazioni contro alti ufficiali e comandanti russi.

Here in Moscow, Russian General Vladimir Alekseev has survived an assassination attempt but is critically ill.

He is first Deputy Chief of the Main Intelligence Directorate of the General Staff of the Russian Armed Forces and was shot 3 times in the back in the entrance hall of… pic.twitter.com/wvTgTWRqcR

— Chay Bowes (@BowesChay) February 6, 2026

Iscriviti alla Newslettera di Renovatio 21

Alekseev, decorato nel 2017 con il titolo di Eroe della Federazione Russa, ha supervisionato operazioni antiterrorismo in Siria e ha avuto un ruolo chiave nell’intelligence legata all’invasione dell’Ucraina nel 2022, oltre a essere coinvolto nella repressione della ribellione Wagner nel 2023. È sotto sanzioni occidentali per presunti legami con cyberattacchi e l’uso di agenti nervini.

Il ministro degli Esteri russo Sergej Lavrov ha dichiarato che il governo ucraino sta ancora una volta tentando di sabotare i negoziati di pace attraverso il terrorismo, descrivendo l’incidente come un «atto terroristico» che «ha confermato ancora una volta l’attenzione del regime di Zelens’kyj su provocazioni costanti volte, a loro volta, a interrompere il processo negoziale».

Le autorità ucraine sembrano inoltre determinate a «fare qualsiasi cosa» per convincere i loro sponsor occidentali a ostacolare qualsiasi tentativo di raggiungere una giusta soluzione del conflitto, ha aggiunto il ministro.

Il presunto tentativo di assassinio arriva poco dopo il secondo round di colloqui di pace trilaterali tra Russia, Stati Uniti e Ucraina, tenutosi mercoledì e giovedì ad Abu Dhabi. L’inviato speciale degli Stati Uniti Steve Witkoff ha descritto le consultazioni come «produttive».

Iscriviti alla Newslettera di Renovatio 21

Immagine da Twitter

Intelligenza Artificiale

Il Pentagono vuole un’intelligenza artificiale killer senza garanzie

Sostieni Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Essere genitori1 settimana fa

Essere genitori1 settimana faBambini nella neve, bambini nel bosco: pedolatria olimpica e pedofobia di sistema

-

Tabarro2 settimane fa

Tabarro2 settimane faInvito alla Tabarrata Nazionale 2026

-

Bioetica1 settimana fa

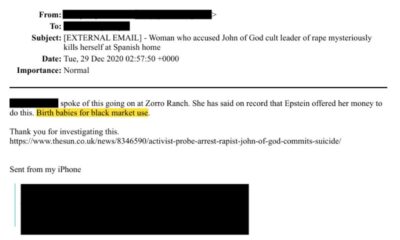

Bioetica1 settimana faAborti traumatici nei file di Epstein

-

Transumanismo2 settimane fa

Transumanismo2 settimane faDal trapianto di organi al trapianto dell’uomo: il sogno post-umano di un neurochirurgo italiano

-

Autismo1 settimana fa

Autismo1 settimana faGli scienziati pubblicano una «mappa» su come l’alluminio nei vaccini può causare lesioni cerebrali che scatenano l’autismo

-

Misteri4 giorni fa

Misteri4 giorni faLe porte del pandemonio di Epstein

-

Sorveglianza1 settimana fa

Sorveglianza1 settimana faPerugia ti aspetta al varco ZTL

-

Misteri6 giorni fa

Misteri6 giorni faAllevamenti di bambini al mercato nero: l’orrore emerge dai file di Epstein