Intelligenza Artificiale

Il Pentagono potrebbe punire l’IA Anthropic per essersi rifiutato di modificare il codice etico

Il dipartimento della Guerra degli Stati Uniti è prossimo a interrompere i rapporti con Anthropic, principale partner nel settore dell’intelligenza artificiale e sviluppatore del modello Claude, designandolo come un rischio per la filiera della fornitura americana. Lo riporta Axios, citando un funzionario del Pentagono. Tale classificazione è solitamente riservata a entità legate a stati considerati da Washington come avversari stranieri.

Secondo le informazioni riportate, il laboratorio con sede a San Francisco è in contrasto da mesi con il governo statunitense a causa della sua politica che restringe l’uso militare della propria tecnologia. Mentre il Pentagono ha insistito affinché l’azienda permettesse l’impiego di Claude per «tutti gli scopi legittimi», il protocollo etico di Anthropic vieta che la sua tecnologia venga usata per «facilitare la violenza, sviluppare armi o condurre attività di sorveglianza».

«Sarà una vera rottura di scatole districarci e faremo in modo che paghino il prezzo per averci forzato la mano in questo modo», ha dichiarato ad Axios un funzionario del Pentagono rimasto anonimo.

Claude rappresenta attualmente l’unico modello di AI in uso sulle piattaforme classificate dell’esercito, grazie a una collaborazione con Palantir Technologies, colosso del software di analisi e sorveglianza finanziato da Peter Thiel, venture capitalist ora molto discusso per le sue visioni sul futuro e sull’anticristo nonché per i suoi legami con la politica, in particolare con il vicepresidente JD Vance che fu suo dipendente in Silicon Valley.

Un eventuale inserimento nella lista nera obbligherebbe i contractor del Pentagono a dimostrare di non impiegare la tecnologia di Anthropic, con il rischio di perdere i contratti in caso contrario.

Il portavoce del Pentagono Sean Parnell ha affermato ad Axios che il rapporto tra il dipartimento e Anthropic «è in fase di revisione».

Sostieni Renovatio 21

«Tutti i partner del Pentagono devono essere disposti ad aiutare i nostri combattenti a vincere qualsiasi battaglia», ha aggiunto Parnell. Un portavoce di Anthropic ha dichiarato alla testata che l’azienda ha avuto «conversazioni produttive» con il dipartimento.

Lo scontro emerso segue alle accuse secondo cui il modello di Intelligenza Artificiale dell’azienda sarebbe stato utilizzato durante l’operazione per rapire il presidente venezuelano Nicolas Maduro all’inizio di gennaio.

La scorsa settimana, Axios e il Wall Street Journal hanno riferito che Claude è stato impiegato sia per organizzare il raid sia per portarlo a termine, sebbene il suo ruolo preciso resti poco chiaro. Le accuse sono emerse dopo che l’azienda ha trascorso settimane a promuovere le proprie politiche di sicurezza e a presentarsi come l’opzione più attenta alla sicurezza nell’ambito dell’intelligenza artificiale.

Come riportato da Renovatio 21, negli ultimi mesi vi è stato un progressivo deterioramento dei rapporti tra Anthropic e il Pentagono, legato alla volontà del dipartimento della Guerra statunitense di utilizzare l’IA per il controllo di armi autonome senza le garanzie di sicurezza che l’azienda ha cercato di imporre.

Il CEO di Anthropic, Dario Amodei, ha più volte espresso gravi preoccupazioni sui rischi della tecnologia che la sua azienda sta sviluppando e commercializzando. In un lungo saggio di quasi 20.000 parole pubblicato il mese scorso, ha avvertito che sistemi AI dotati di «potenza quasi inimmaginabile» sono «imminenti» e metteranno alla prova «la nostra identità come specie».

Amodei ha messo in guardia dai «rischi di autonomia», in cui l’IA potrebbe sfuggire al controllo e sopraffare l’umanità, e ha ipotizzato che la tecnologia potrebbe facilitare l’instaurazione di «una dittatura totalitaria globale» attraverso sorveglianza di massa basata sull’Intelligenza Artificiale e l’impiego di armi autonome.

Come riportato da Renovatio 21, l’anno passato l’Amodei ha dichiarato che l’AI potrebbe eliminare la metà di tutti i posti di lavoro impiegatizi di livello base entro i prossimi cinque anni.

La scorsa settimana Mrinank Sharma, l fino a poco tempo fa responsabile del Safeguards Research Team presso l’azienda sviluppatrice del chatbot Claude, ha pubblicato su X la sua lettera di dimissioni, in cui scrive che «il mondo è in pericolo. E non solo per via dell’Intelligenza Artificiale o delle armi biologiche, ma a causa di un insieme di crisi interconnesse che si stanno verificando proprio ora».

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Bill Gates non va al vertice indiano sull’AI per le ricadute dei documenti di Epstein

Sostieni Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Il Pentagono ha utilizzato Claude AI per rapire Maduro

L’esercito statunitense ha fatto attivamente ricorso al modello di Intelligenza Artificiale Claude di Anthropic nel corso dell’operazione volta a catturare il presidente venezuelano Nicolás Maduro il mese scorso, evidenziando che la tecnologia dell’azienda ha svolto un ruolo diretto nel raid condotto all’estero. Lo hanno riportato le testate statunitensi Axios e dal Wall Street Journal.

Claude è stato impiegato durante l’operazione stessa, e non solo nelle fasi di pianificazione, hanno riferito venerdì Axios e il WSJ. Il ruolo preciso rimane poco definito, benché l’esercito abbia già utilizzato modelli di intelligenza artificiale per l’analisi di immagini satellitari e dati di intelligence in tempo reale.

Le politiche di utilizzo del laboratorio di intelligenza artificiale con sede a San Francisco vietano espressamente che la sua tecnologia venga impiegata per «facilitare la violenza, sviluppare armi o condurre attività di sorveglianza». Nessun cittadino americano ha perso la vita durante il raid, ma decine di soldati e membri del personale di sicurezza venezuelani e cubani sono stati uccisi il 3 gennaio.

«Non possiamo dire se Claude, o qualsiasi altro modello di intelligenza artificiale, sia stato utilizzato per operazioni specifiche, classificate o meno», ha dichiarato un portavoce di Anthropic ad Axios. «Qualsiasi utilizzo di Claude, sia nel settore privato che in ambito governativo, è soggetto alle nostre Norme di Utilizzo».

Sostieni Renovatio 21

I concorrenti di Anthropic, tra cui OpenAI, Google e xAI di Elon Musk, hanno tutti stipulato accordi che assicurano al Pentagono l’accesso ai loro modelli senza molte delle restrizioni imposte agli utenti ordinari. Tuttavia, solo Claude viene impiegato, attraverso una partnership con Palantir Technologies, sulle piattaforme classificate destinate alle attività più sensibili dell’esercito statunitense.

La notizia emerge in un momento delicato per l’azienda, che nelle scorse settimane ha ribadito pubblicamente il proprio impegno verso le misure di sicurezza nell’Intelligenza Artificiale e si è presentata come un’alternativa responsabile e attenta alla sicurezza nel panorama dell’IA.

Il CEO Dario Amodei ha messo in guardia dai rischi esistenziali derivanti da un utilizzo incontrollato dell’IA. Lunedì il responsabile del Safeguards Research Team di Anthropic, Mrinank Sharma, si è dimesso improvvisamente lasciando un avvertimento criptico: «Il mondo è in pericolo». Pochi giorni dopo, l’azienda ha stanziato 20 milioni di dollari in un gruppo di pressione politica a favore di una regolamentazione solida dell’IA.

Anthropic starebbe negoziando con il Pentagono per allentare le limitazioni sull’uso dell’IA nel puntamento autonomo di armi e nella sorveglianza interna. Lo stallo ha bloccato un contratto da 200 milioni di dollari, con il segretario alla Difesa Pete Hegseth che ha dichiarato di non voler utilizzare modelli che «non permettono di combattere guerre».

Iscriviti alla Newslettera di Renovatio 21

Armi biologiche

Ricercatore sulla sicurezza dell’AI per le armi biologiche si dimette e avverte: «il mondo è in pericolo»

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

-

Misteri2 settimane fa

Misteri2 settimane faLe porte del pandemonio di Epstein

-

Spirito1 settimana fa

Spirito1 settimana faMons. Viganò: Roma verso uno scenario apocalittico

-

Scuola1 settimana fa

Scuola1 settimana faUn film per capire la distruzione dell’istruzione italiana

-

Militaria1 settimana fa

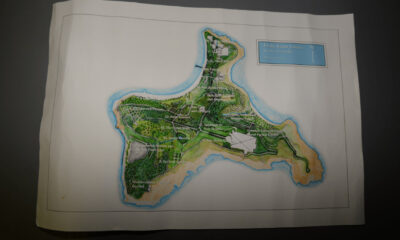

Militaria1 settimana faEpstein comprava migliaia di litri di acido solforico per la sua isola

-

Oligarcato5 giorni fa

Oligarcato5 giorni faEpstein aveva proposto a JPMorgan un piano per ottenere «più soldi per i vaccini» da Bill Gates

-

Persecuzioni2 settimane fa

Persecuzioni2 settimane faCristianofobia: il Parlamento Europeo infrange il tabù

-

Senza categoria2 settimane fa

Senza categoria2 settimane faLavrov: il caso Epstein rivela il «satanismo» delle élite occidentali

-

Armi biologiche1 settimana fa

Armi biologiche1 settimana faRicercatore sulla sicurezza dell’AI per le armi biologiche si dimette e avverte: «il mondo è in pericolo»