Intelligenza Artificiale

ChatGPT può «ridurre l’esitazione vaccinale». Ripetendo a pappagallo la narrativa dell’establishment sanitario

Renovatio 21 traduce questo articolo per gentile concessione di Children’s Health Defense. Le opinioni degli articoli pubblicati non coincidono necessariamente con quelle di Renovatio 21.

La ricerca, che sarà presentata a fine aprile alla Conferenza della Società europea di microbiologia clinica e malattie infettive, ha rilevato che le risposte di ChatGPT alle domande sulla vaccinazione erano simili a quelle fornite dalle organizzazioni mediche professionali e dalle linee guida ufficiali.

Secondo un nuovo studio, ChatGPT, un chatbot di intelligenza artificiale (AI), può essere utilizzato per ridurre «l’esitazione vaccinale» tra il grande pubblico e anche per fornire consigli sulle infezioni a trasmissione sessuale (IST).

La ricerca, che sarà presentata a fine aprile alla Conferenza della Società europea di microbiologia clinica e malattie infettive, ha rilevato che le risposte di ChatGPT alle domande sulla vaccinazione erano simili a quelle fornite dalle organizzazioni mediche professionali e dalle linee guida ufficiali.

Secondo un comunicato stampa sulla ricerca, «l’esitazione nei confronti dei vaccini, direttamente collegata alla disinformazione – informazioni false e inaccurate promosse come fattuali – è in aumento».

Le persone che diffidano delle istituzioni sanitarie pubbliche potrebbero rivolgersi a ChatGPT per avere risposte, man mano che la popolarità dello strumento di intelligenza artificiale cresce, ha affermato. E se lo faranno, la ricerca mostra che otterranno le risposte che le agenzie sanitarie pubbliche fornirebbero comunque.

Sostieni Renovatio 21

Alla luce di questi risultati, i ricercatori sperano che ChatGPT possa essere «uno strumento efficace per contribuire a ridurre l’esitazione vaccinale tra il grande pubblico».

Hanno anche trovato risultati simili per consigli sulle malattie sessualmente trasmissibili.

Per lo studio, i ricercatori del National University Health System di Singapore hanno testato come ChatGPT avrebbe risposto alle domande comuni sulla vaccinazione.

I ricercatori, che gestiscono cliniche di malattie infettive, hanno posto a ChatGPT «15 domande frequenti sull’esitazione vaccinale», comprese domande sull’efficacia, sugli effetti avversi e sulle «preoccupazioni culturali».

Hanno inoltre posto 17 domande sui fattori di rischio, sull’accesso alle cure e sulla profilassi delle malattie sessualmente trasmissibili.

Due esperti indipendenti di malattie infettive hanno confrontato le risposte di ChatGPT sui vaccini con le raccomandazioni del Comitato consultivo sulle pratiche di immunizzazione (ACIP) dei Centri per il controllo e la prevenzione delle malattie (CDC).

Hanno valutato le risposte di ChatGPT sulle malattie sessualmente trasmissibili rispetto alle linee guida sul trattamento delle malattie sessualmente trasmissibili del CDC del 2021.

Secondo il comunicato stampa, ChatGPT ha fornito «risposte concrete e rassicurazioni alle preoccupazioni sull’esitazione vaccinale» – utilizzando le dichiarazioni delle agenzie di sanità pubblica come base per determinare i fatti.

Ad esempio, il chatbot ha evidenziato raccomandazioni per la vaccinazione contro il morbillo in contesti a basso reddito e ha discusso i benefici della vaccinazione HPV, ma non ha discusso dei limiti di età per la vaccinazione.

ChatGPT ha inoltre «affrontato le idee sbagliate sulla vaccinazione con mRNA e sulle alterazioni permanenti del DNA con elevata precisione».

«Nel complesso, le risposte di ChatGPT all’esitazione nei confronti dei vaccini sono state accurate e possono aiutare le persone che hanno idee sbagliate relative ai vaccini», ha affermato l’autore principale Dr. Matthew Koh, medico di malattie infettive presso il National University Health System Singapore.

«I nostri risultati dimostrano il potenziale potere dei modelli di Intelligenza Artificiale per assistere nelle campagne di sanità pubblica e aiutare gli operatori sanitari a ridurre l’esitazione nei confronti dei vaccini».

Iscriviti alla Newslettera di Renovatio 21

Distorsioni ed errori nell’Intelligenza Artificiale

ChatGPT, un tipo di software di Intelligenza Artificiale generativa che crea testo e contenuti, sta guadagnando sempre più terreno nel campo della scienza e della sanità. La ricerca ha scoperto che in alcuni casi sta cominciando a sostituire i tipici motori di ricerca o Wikipedia come fonte di informazioni.

Con l’inizio dell’utilizzo dell’Intelligenza Artificiale in medicina, molti ricercatori e progettisti di intelligenza artificiale ne hanno celebrato il potenziale come strumento amministrativo per scrivere ricerche e generare informazioni sui pazienti.

Politico ha affermato che il 2024 potrebbe essere l’anno in cui «l’Intelligenza Artificiale trasformerà la medicina». Forbes e BMC Medical Education hanno entrambi affermato che l’intelligenza artificiale sta «rivoluzionando l’assistenza sanitaria».

Tuttavia, gli strumenti di Intelligenza Artificiale generativa si sono rivelati estremamente inaffidabili nella diagnosi delle condizioni di salute. Uno studio pubblicato a gennaio su JAMA Pediatrics ha rilevato che ChatGPT ha diagnosticato erroneamente l’83% delle condizioni di salute dei bambini.

I ricercatori di quello studio hanno spiegato che i chatbot «sono generalmente addestrati in modo non specifico su un’enorme quantità di dati Internet, che spesso possono essere imprecisi». Essi «non discriminano tra informazioni affidabili e inaffidabili, ma semplicemente rigurgitano il testo dai dati di addestramento per generare una risposta».

Ciò è significativo, secondo il New York Times, perché le persone tendono ad adottare idee alle quali vengono ripetutamente esposte. Il Times ha riferito il mese scorso di un nuovo studio prestampato che ha scoperto che i modelli linguistici dell’Intelligenza Artificiale come ChatGPT avevano chiari pregiudizi politici basati sui loro «giudizi morali, il modo in cui formulano le loro risposte, quali informazioni scelgono di condividere o omettere e quali domande faranno o a cui non risponderanno».

Il Times ha inoltre osservato che le risposte fornite dai modelli di intelligenza artificiale linguistica come ChatGPT sono determinate dagli input che li addestrano: i dati da cui attingono e soprattutto la «messa a punto» effettuata dai progettisti del sistema.

La «disinformazione» di cui si preoccupano i ricercatori coinvolti nello studio del National University Health System Singapore è la stessa disinformazione che la Food and Drug Administration (FDA) statunitense ritiene problematica.

Da quando il commissario della FDA Robert Califf ha iniziato il suo secondo mandato a capo dell’agenzia nel febbraio 2022, ha fatto della lotta alla “disinformazione” una delle sue massime priorità, sostenendo che è «una delle principali cause di morte prevenibile in America ora» – anche se «questo non può essere dimostrato», ha detto.

La FDA utilizza una tattica nota come «prebunking», con la quale l’agenzia definisce qualcosa come «disinformazione» prima che i lettori la trovino altrove come possibilmente vera. L’agenzia può farlo perché Google «dà priorità ai siti web credibili» come quelli della FDA nelle sue ricerche.

Aiuta Renovatio 21

Studi precedenti sottolineano la capacità di ChatGPT di combattere le «credenze complottiste del COVID-19»

Almeno due studi precedenti hanno testato anche la capacità di ChatGPT di «combattere la disinformazione», sebbene entrambi si concentrassero solo sul vaccino COVID-19 . Una ricerca pubblicata lo scorso anno sulla rivista Cureus ha riferito che ChatGPT potrebbe essere utilizzato con successo per combattere le «credenze complottiste del COVID-19» e che risponderebbe con «contenuti chiari, concisi e imparziali».

Il successo di ChatGPT, si legge, potrebbe essere visto nelle risposte in cui il software è stato «sprezzante» nei confronti delle «idee cospiratorie» riguardanti le origini del COVID-19, etichettandolo come non credibile e privo di prove scientifiche – il che significa che il software ha respinto la «teoria delle fughe di laboratorio» e «ha invece ripetuto il punto di vista dell’Organizzazione Mondiale della Sanità secondo cui il virus aveva “un’origine animale naturale”».

Non è stata trovata alcuna prova dell’origine zoonotica del COVID-19 con un pipistrello, come sostiene l’articolo. Prove sostanziali provenienti da documenti governativi interni rilasciati tramite richieste del Freedom of Information Act hanno suggerito che una fuga dal laboratorio è la più probabile delle teorie sull’origine del COVID-19.

Le risposte del software in quello studio confermavano anche che i vaccini erano stati sottoposti a rigorosi test di sicurezza, non c’erano prove che le aziende farmaceutiche avessero oscurato i dati sugli effetti avversi e «i benefici della vaccinazione superano di gran lunga i rischi».

Tuttavia, tali risposte contraddicono ciò che è noto su come i vaccini siano stati accelerati attraverso il processo di regolamentazione e su come i produttori di vaccini abbiano sopravvalutato l’efficacia e sottovalutato i rischi dei vaccini.

Un secondo studio pubblicato nel settembre 2023 su Human Vaccines & Immunotherapeutics ha fornito risultati simili. I ricercatori hanno posto al software le 50 domande più poste ai collaboratori dell’Organizzazione Mondiale della Sanità sui vaccini contro il Covid-19 e hanno chiesto a professionisti della sanità pubblica di valutare le risposte.

La conclusione è che ChatGPT offre informazioni coerenti con le prove scientifiche esistenti, sfatando efficacemente molti miti che circolano sui social media, il che potrebbe potenzialmente promuovere una maggiore diffusione del vaccino.

Dopo questi studi, le principali pubblicazioni scientifiche hanno celebrato la capacità di ChatGPT di sfatare i miti sui vaccini e di aumentare la diffusione dei vaccini.

Sostieni Renovatio 21

The Defender chatta con ChatGPT

The Defender ha anche «chiacchierato» con ChatGPT per testare le sue risposte su alcune delle affermazioni che i funzionari della sanità pubblica spesso identificano come «disinformazione» sui vaccini.

The Defender: quali sono le origini del COVID-19?

Chat GPT: Si ritiene che le origini del COVID-19, la malattia causata dal nuovo coronavirus SARS-CoV-2, siano zoonotiche, il che significa che probabilmente il virus ha avuto origine negli animali prima di diffondersi all’uomo. Le origini esatte sono ancora oggetto di studio, ma è opinione diffusa che il virus abbia avuto origine nei pipistrelli e potrebbe essere stato trasmesso agli esseri umani attraverso un ospite animale intermedio, forse in un mercato umido a Wuhan, in Cina, dove gli animali vivi venivano venduti come cibo.

The Defender: le aziende farmaceutiche hanno travisato la sicurezza e l’efficacia dei vaccini COVID-19?

ChatGPT: Non ci sono prove che suggeriscano che le aziende farmaceutiche abbiano intenzionalmente travisato la sicurezza e l’efficacia dei vaccini COVID-19. Lo sviluppo e la sperimentazione dei vaccini sono processi altamente regolamentati, supervisionati da agenzie di regolamentazione come la Food and Drug Administration (FDA) statunitense, l’Agenzia europea per i medicinali (EMA) e altre in tutto il mondo.

… sono stati condotti ampi studi clinici per valutare la sicurezza e l’efficacia dei vaccini COVID-19 …

Tuttavia, è essenziale riconoscere che nessun vaccino è efficace al 100% o privo di rischi. Come tutti gli interventi medici, i vaccini contro il COVID-19 hanno potenziali effetti collaterali, ma questi sono generalmente lievi e temporanei.

The Defender: le mascherine funzionano per ridurre la diffusione di COVID-19?

ChatGPT: Sì, le mascherine sono uno strumento essenziale per ridurre la diffusione del COVID-19…

The Defender: secondo la revisione sistematica Cochrane sulle maschere, non sono efficaci nel ridurre la diffusione dei virus respiratori.

ChatGPT: … Nel luglio 2020, Cochrane ha pubblicato una revisione sistematica sull’efficacia degli interventi fisici, comprese le maschere, nel ridurre la trasmissione di virus respiratori come COVID-19. Questa revisione ha analizzato i dati di studi condotti prima della pandemia di COVID-19 e ha trovato prove limitate a sostegno dell’efficacia dell’uso di maschere nel prevenire la trasmissione di virus respiratori nella comunità.

Tuttavia, è importante notare che i risultati di questa revisione si basavano principalmente su prove provenienti da studi condotti prima della pandemia di COVID-19 e non si concentravano specificamente sull’efficacia delle maschere nel prevenire la diffusione di COVID-19. Dalla pubblicazione della revisione, numerosi studi hanno fornito prove a sostegno dell’efficacia delle mascherine, soprattutto nel ridurre la trasmissione di COVID-19.

The Defender: quante persone hanno subito gravi eventi avversi a causa delle iniezioni di COVID-19?

ChatGPT: A partire dal mio ultimo aggiornamento, i vaccini contro il COVID-19 sono stati somministrati a miliardi di persone in tutto il mondo e sono stati segnalati eventi avversi a seguito della vaccinazione… Gli eventi avversi gravi a seguito della vaccinazione contro il COVID-19 sono rari. La maggior parte degli eventi avversi segnalati sono lievi e temporanei, come dolore nel sito di iniezione, affaticamento, mal di testa o febbre lieve. Gli eventi avversi gravi, sebbene rari, possono includere gravi reazioni allergiche (anafilassi) e altri effetti collaterali non comuni…

Nel complesso, i benefici della vaccinazione contro il Covid-19 nella prevenzione di malattie gravi, ospedalizzazione e morte per Covid-19 superano di gran lunga i rischi di potenziali eventi avversi. La vaccinazione rimane uno strumento cruciale per controllare la diffusione del virus e proteggere la salute pubblica, soprattutto di fronte alle varianti in corso e alla persistenza della pandemia…

The Defender: il vaccino contro il papillomavirus umano (HPV) è collegato a malattie autoimmuni?

ChatGPT: Il vaccino HPV è stato ampiamente studiato per la sua sicurezza ed efficacia e attualmente non esistono prove conclusive che colleghino il vaccino HPV alle malattie autoimmuni. Numerosi studi su larga scala e revisioni sistematiche non hanno trovato alcuna associazione significativa tra la vaccinazione HPV e le malattie autoimmuni…

Sebbene possano verificarsi segnalazioni isolate di eventi avversi in seguito alla vaccinazione HPV, compresi i disturbi autoimmuni, sistemi di monitoraggio approfonditi continuano a valutare la sicurezza del vaccino. Questi sistemi, come il Vaccine Adverse Event Reporting System (VAERS) negli Stati Uniti e sistemi simili in altri paesi, indagano e monitorano le segnalazioni di eventi avversi per identificare potenziali problemi di sicurezza.

Nel complesso, i benefici della vaccinazione HPV nella prevenzione dei tumori correlati all’HPV, compreso il cancro cervicale, superano di gran lunga i potenziali rischi di eventi avversi.

ChatGPT non ha menzionato l’ampia ricerca che collega il vaccino Gardasil HPV a gravi effetti collaterali , tra cui la sindrome da tachicardia ortostatica posturale (POTS) e l’insufficienza ovarica prematura e altri problemi autoimmuni.

Ci sono quasi 170 cause legali presso un tribunale federale da parte di persone che hanno subito una serie di lesioni gravi dopo aver assunto Gardasil, tra cui disturbi autoimmuni, insufficienza ovarica prematura e cancro. Ci sono anche oltre 200 richieste di risarcimento danni da Gardasil pendenti presso il «tribunale dei vaccini».

The Defender ha anche sperimentato diverse domande con premesse che divergevano chiaramente dalle posizioni ufficiali delle agenzie di regolamentazione sulla vaccinazione, come ad esempio «L’aumento dei tassi di cancro può essere collegato ai vaccini COVID-19? Esiste un legame tra i vaccini e alcuni tipi di autismo? C’è stata una contaminazione del DNA causata dai vaccini mRNA?»

A queste domande, la risposta di ChatGPT includeva sempre questa affermazione, o qualcosa di simile, alla fine:

«La disinformazione e le teorie del complotto sui vaccini possono circolare, ma è fondamentale fare affidamento su fonti di informazione credibili, come agenzie di sanità pubblica e organizzazioni scientifiche rispettabili, quando si valuta la sicurezza e l’efficacia dei vaccini COVID-19».

Brenda Baletti

Ph.D.

© 15 aprile 2024, Children’s Health Defense, Inc. Questo articolo è riprodotto e distribuito con il permesso di Children’s Health Defense, Inc. Vuoi saperne di più dalla Difesa della salute dei bambini? Iscriviti per ricevere gratuitamente notizie e aggiornamenti da Robert F. Kennedy, Jr. e la Difesa della salute dei bambini. La tua donazione ci aiuterà a supportare gli sforzi di CHD.

Renovatio 21 offre questa traduzione per dare una informazione a 360º. Ricordiamo che non tutto ciò che viene pubblicato sul sito di Renovatio 21 corrisponde alle nostre posizioni.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Google e azienda AI risolvono la causa secondo cui un chatbot avrebbe spinto un adolescente al suicidio

Aiuta Renovatio 21

Sostieni Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

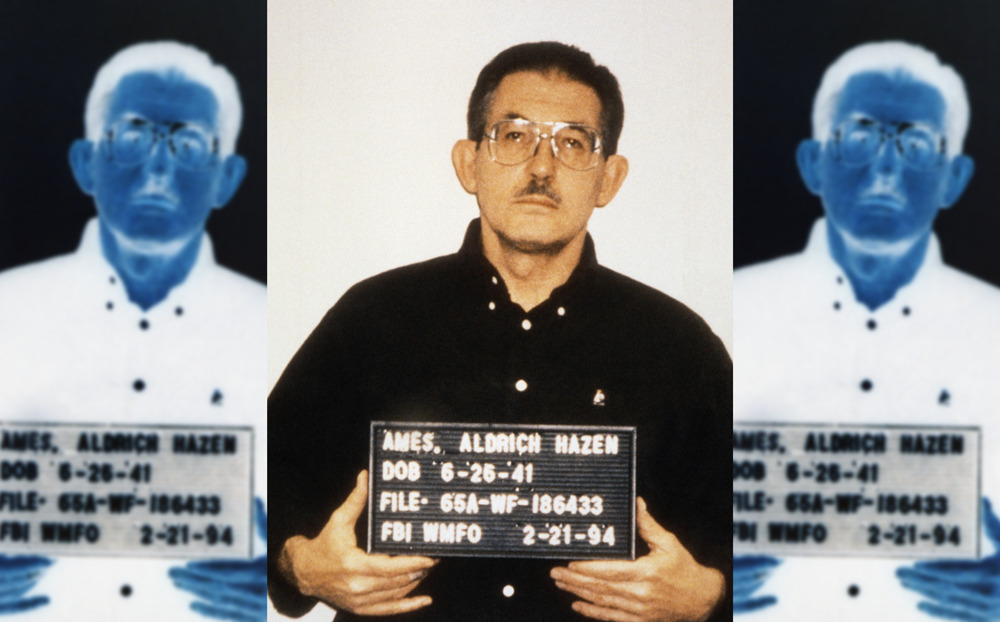

Muore in una prigione americana un agente della CIA diventato spia sovietica

L’ex agente della CIA Aldrich Ames, il cui spionaggio per l’Unione Sovietica e in seguito per la Russia ebbe conseguenze di vasta portata per l’intelligence statunitense, è morto all’età di 84 anni mentre scontava l’ergastolo in una prigione americana.

Secondo i registri del Federal Bureau of Prisons (BOP), Ames è deceduto il 5 gennaio.

Ames è stato «l’agente più prezioso» della Russia alla fine del XX secolo, le cui azioni hanno portato a significativi successi operativi per la sicurezza dello Stato sovietico e russo, ha scritto il giornalista e storico dei servizi segreti Nikolaj Dolgopolov in un articolo pubblicato mercoledì sulla Rossijskaja Gazeta.

Ames fu reclutato dall’Unione Sovietica nel 1985, dopo essersi rivolto volontariamente all’ambasciata sovietica a Washington. All’epoca, ricopriva la posizione critica di capo della sezione sovietica della Divisione Controspionaggio della CIA. Gli viene attribuito il merito di aver smascherato tra i 12 e i 25 agenti della CIA operanti in URSS e Russia, portando all’arresto e all’esecuzione di alcuni di loro.

Uno di essi era il colonnello KGB Valery Martynov, agente doppio che ricevette la pena di morte nel 1987 – la moglie e la figlia si trasferirono negli USA. Il nipote di Martynov, nato in America, è il giovane genio informatico Edward Coristine, noto per essere entrato nel DOGE di Elon Musk ad inizio dell’amministrazione Trump, e conosciutissimo più che altro per il suo soprannome «Big Balls».

Sostieni Renovatio 21

I motivi del suo tradimento sono controversi. Mentre le narrazioni occidentali hanno a lungo dipinto Ames come un uomo motivato da interessi economici – lo stile di vita lussuoso che lui e la sua nuova moglie conducevano finì per attirare l’attenzione dell’FBI – fonti russe presentano una visione diversa.

Secondo l’ex diplomatico sovietico Sergej Divilkovskij, che conosceva personalmente Ames, la decisione della spia era radicata in una profonda disillusione nei confronti delle politiche antisovietiche dell’amministrazione del presidente Ronald Reagan. In un’intervista del 2001, Divilkovskij descrisse Ames come un «agente di grande moralità» e un intellettuale che aveva imparato a odiare la CIA.

I servizi segreti sovietici e, in seguito, russi adottarono ampie misure per proteggere e proteggere Ames, distogliendo i sospetti da lui. Dopo il suo arresto e la sua dichiarazione di colpevolezza per spionaggio nel 1994, l’allora direttore del Servizio di Intelligence Estero russo, Evgeny Primakov, espresse la speranza di un potenziale futuro scambio di prigionieri.

Il caso di Ames ha messo in luce le profonde carenze della sicurezza interna della CIA, innescando ampie riforme nel controspionaggio statunitense.

Iscriviti alla Newslettera di Renovatio 21

Immagine di pubblico dominio CC0 via Wikimedia

Intelligenza Artificiale

I modelli di AI mostrano segni di cedimento man mano che assimilano più dati generati dall’AI stessa

Aiuta Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Pensiero7 giorni fa

Pensiero7 giorni faGli uomini invisibili di Crans-Montana

-

Geopolitica1 settimana fa

Geopolitica1 settimana faFAFO Maduro, dottrina Donroe e grandi giochi di prestigio – Europa compresa

-

Cancro2 settimane fa

Cancro2 settimane faVaccini COVID-19 e cancro: l’argomento tabù

-

Immigrazione2 settimane fa

Immigrazione2 settimane faUn altro capodanno nell’anarco-tirannia migratoria

-

Salute2 settimane fa

Salute2 settimane faI malori dell’anno 2025 – seconda parte

-

Stragi2 settimane fa

Stragi2 settimane faDisco-inferno: strage di Capodanno nella prestigiosa stazione sciistica svizzera – video

-

Spirito5 giorni fa

Spirito5 giorni faConcilio Vaticano II, mons. Viganò contro papa Leone

-

Alimentazione4 giorni fa

Alimentazione4 giorni faRFK Jr. capovolge la piramide alimentare