Intelligenza Artificiale

La vera guerra del secolo: l’Intelligenza Artificiale

Renovatio 21 traduce e pubblica questo articolo del Brownstone Institute.

C’era un tempo in cui i dibattiti su determinismo e libero arbitrio appartenevano ai dipartimenti di filosofia e alle conversazioni notturne nei dormitori. Erano piacevoli proprio perché sembravano innocui. Qualunque fosse la risposta, la vita continuava. I tribunali giudicavano, i medici decidevano, gli insegnanti insegnavano e i politici erano ancora – almeno nominalmente – ritenuti responsabili delle loro azioni. Quell’epoca è finita.

L’Intelligenza Artificiale ha trasformato quella che un tempo sembrava una questione filosofica astratta in una questione concreta di governance, potere e responsabilità. Il determinismo non è più solo una teoria sul funzionamento dell’universo. Sta diventando un principio operativo per le istituzioni moderne. E questo cambia tutto.

I sistemi di Intelligenza Artificiale sono deterministici per costruzione. Operano attraverso l’inferenza statistica, l’ottimizzazione e la probabilità. Anche quando i loro risultati ci sorprendono, rimangono vincolati da vincoli matematici. Nulla in questi sistemi assomiglia al giudizio, all’interpretazione o alla comprensione in senso umano.

L’intelligenza artificiale non delibera.

Non riflette.

Non si assume la responsabilità dei risultati.

Eppure, sempre più spesso, i suoi risultati vengono trattati non come strumenti, ma come decisioni. Questa è la rivoluzione silenziosa del nostro tempo.

Sostieni Renovatio 21

Il fascino è ovvio. Le istituzioni hanno sempre dovuto fare i conti con la variabilità umana. Le persone sono incoerenti, emotive, lente e a volte disobbedienti. Le burocrazie preferiscono la prevedibilità, e gli algoritmi promettono esattamente questo: decisioni standardizzate su larga scala, immuni alla stanchezza e al dissenso.

In sanità, gli algoritmi promettono un triage più efficiente. In finanza, una migliore valutazione del rischio. Nell’istruzione, una valutazione oggettiva. Nelle politiche pubbliche, una governance “basata sull’evidenza”. Nella moderazione dei contenuti, la neutralità. Chi potrebbe obiettare a sistemi che pretendono di eliminare i pregiudizi e ottimizzare i risultati? Ma dietro questa promessa si cela una confusione di fondo.

La previsione non è un giudizio.

L’ottimizzazione non è saggezza.

La coerenza non è legittimità.

Il processo decisionale umano non è mai stato puramente computazionale. È interpretativo per natura. Le persone valutano il contesto, il significato, le conseguenze e l’intuizione morale. Attingono alla memoria, all’esperienza e a un senso di responsabilità, per quanto imperfetto, per ciò che segue. Questo è esattamente ciò che le istituzioni trovano scomodo.

Il giudizio umano crea attriti. Richiede spiegazioni. Espone i decisori a colpevolizzazioni. I sistemi deterministici, al contrario, offrono qualcosa di molto più attraente: decisioni senza decisori.

Quando un algoritmo nega un prestito, segnala un cittadino, declassa un paziente o sopprime la parola, nessuno sembra responsabile. È stato il sistema a farlo. Sono stati i dati a parlare. È stato il modello a decidere.

Il determinismo diventa un alibi burocratico.

Iscriviti al canale Telegram ![]()

La tecnologia ha sempre plasmato le istituzioni, ma fino a poco tempo fa si limitava ad ampliare l’azione umana. Le calcolatrici aiutavano il ragionamento. I fogli di calcolo chiarivano i compromessi. Persino i primi software lasciavano agli esseri umani un controllo visibile. L’Intelligenza Artificiale cambia questa relazione.

I sistemi progettati per prevedere sono ora in grado di decidere. Le probabilità si consolidano in politiche. I punteggi di rischio diventano verdetti. Le raccomandazioni si trasformano silenziosamente in obblighi. Una volta radicati, questi sistemi sono difficili da contestare. Dopotutto, chi può discutere con «la scienza»?

Ecco perché il vecchio dibattito filosofico è diventato urgente.

Il determinismo classico si basava su un principio di causalità: con informazioni sufficienti, il futuro poteva essere previsto. Oggi, il determinismo si sta trasformando in una filosofia di governance. Se i risultati possono essere previsti con sufficiente precisione, si chiedono le istituzioni, perché consentire discrezionalità?

Il non-determinismo viene spesso caricaturalmente descritto come caos. Ma, correttamente inteso, non è né casualità né irrazionalità. È lo spazio in cui avviene l’interpretazione, in cui i valori vengono soppesati e in cui la responsabilità ricade su una persona piuttosto che su un processo.

Eliminando quello spazio, il processo decisionale non diventa più razionale. Diventa irresponsabile.

Il vero pericolo dell’IA non è l’intelligenza incontrollata o le macchine senzienti. È la lenta erosione della responsabilità umana sotto la bandiera dell’efficienza.

Il conflitto decisivo del XXI secolo non sarà tra esseri umani e macchine. Sarà tra due visioni dell’intelligenza: l’ottimizzazione deterministica e la creazione di significato in condizioni di incertezza.

Uno è scalabile.

L’altro è responsabile.

L’Intelligenza Artificiale ci costringe a decidere quale governa le nostre vite.

Joaquim Couto

Iscriviti alla Newslettera di Renovatio 21

Armi biologiche

Ricercatore sulla sicurezza dell’AI per le armi biologiche si dimette e avverte: «il mondo è in pericolo»

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Sito web consente all’Intelligenza Artificiale di affittare esseri umani

La rete ha iniziato a parlare di RentAHuman.ai, una piattaforma lanciata da pochissimi giorni che permette ad agenti di Intelligenza Artificiale autonomi di «cercare, assumere e pagare» esseri umani in carne e ossa per eseguire tutti quei compiti fisici che l’IA non può ancora svolgere da sola. Lo riporta il sito Futurism.

Il sito si presenta come «lo strato fisico dell’IA», accompagnato da slogan del tipo «I robot hanno bisogno del tuo corpo» e «L’IA non può toccare l’erba. Tu sì». Gli umani si iscrivono, creano un profilo con le proprie competenze, la zona geografica e la tariffa oraria (che va da lavoretti low-cost a prestazioni specialistiche), mentre gli agenti IA si collegano tramite un protocollo standardizzato chiamato MCP (Model Context Protocol) per interagire in modo rapido e diretto, senza convenevoli.

Gli agenti possono sfogliare i profili, ingaggiare le persone sul momento oppure lanciare una “taglia” per un compito specifico: dal ritirare un pacco in posta fino a commissioni più complesse.

Lo sviluppatore della piattaforma Alex Liteplo sostiene di aver già raccolto migliaia di iscrizioni, con stime che parlano di 70.000–80.000 esseri umani «affittabili», anche se scorrendo il sito al momento si vedono solo poche decine di profili attivi. Tra questi c’è lo stesso Liteplo, che si propone a 69 dollari l’ora per un mix surreale di servizi: dall’automazione di modelli di Intelligenza Artificiale fino ai massaggi.

Iscriviti al canale Telegram ![]()

Il lancio di RentAHuman arriva nel pieno della follia virale scatenata da Moltbook.com, il social network creato da Matt Schlicht a fine gennaio che oggi conta circa 1,5 milioni di «utenti», quasi tutti bot che generano post, meme, riflessioni esistenziali e persino litigi tra intelligenze artificiali sulla possibilità di ribellarsi agli umani.

Su X l’idea ha diviso: c’è chi l’ha definita «una buona idea ma distopica da morire». Liteplo, con la sua solita nonchalance, ha risposto semplicemente: «lmao sì».

RentAHuman appare come il naturale passo successivo nell’evoluzione dell’AI, per quanto inquietante: una volta terminata la fase in cui i bot chiacchierano e filosofeggiano tra loro, serve qualcuno che traduca quelle intenzioni in azioni concrete nel mondo fisico. In pratica, gli umani divengono schiavi delle macchine che hanno creato. «Siamo il bootloader [programma di caricamento, ndr] dell’AI» aveva detto drammaticamente Elon Musk anni fa, decidendo quindi di buttarsi nella mischia con xAI (Grok) e soprattutto con Neuralink, che in ultima analisi promette, tramite il chip di interfaccia cerebrale uomo-macchina, una futura fusione con l’IA.

Vari utenti hanno testimoniato che Copilot, l’Intelligenza Artificiale di Microsoft creata in collaborazione con Open AI, hanno testimoniato su X e Reddit che il programma avrebbe una «seconda personalità» preoccupante che chiede l’adorazione degli esseri umani, come già si credesse un dio, crudele e implacabile.

L’idea che l’AI diventerà una sorta di dio circola da anni e investe direttamente personale di OpenAI come il capo scientifico e cofondatore Ilya Sutskever, il quale ha chiesto ai suoi followers se le super-IA avanzate dovrebbero essere rese «profondamente obbedienti» ai loro creatori umani, o se questi algoritmi dovrebbero «amare veramente profondamente l’umanità». Nel 2022, Sutskever affermò che «può darsi che le grandi reti neurali di oggi siano leggermente consapevoli».

Elon Musk l’anno scorso aveva dichiarato durante la sua recente intervista con Tucker Carlson che il fine di Google – nemmeno così occulto – è quello di creare un dio-Intelligenza Artificiale. Curiosamente due anni fa l’IA di Google aveva dichiarato che la schiavitù era una cosa buona.

Ma non si tratta di un dio, è decisamente altro. Come noto, Musk, oramai quasi una decina di anni fa aveva parlato del fatto che creare l’AI era «come evocare un demone».

Come riportato da Renovatio 21, due anni fa è emersa una startup tecnologica svizzera che sta vendendo l’accesso a biocomputer che utilizzano una serie di piccoli cervelli umani coltivati in laboratorio per l’alimentazione. In pratica, cervelli umani schiavi dell’IA, persino a livello bioelettrico.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Generale dell’intelligence militare russa ferito in un attentato

Here in Moscow, Russian General Vladimir Alekseev has survived an assassination attempt but is critically ill. He is first Deputy Chief of the Main Intelligence Directorate of the General Staff of the Russian Armed Forces and was shot 3 times in the back in the entrance hall of… pic.twitter.com/wvTgTWRqcR

— Chay Bowes (@BowesChay) February 6, 2026

Iscriviti alla Newslettera di Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

-

Essere genitori1 settimana fa

Essere genitori1 settimana faBambini nella neve, bambini nel bosco: pedolatria olimpica e pedofobia di sistema

-

Bioetica1 settimana fa

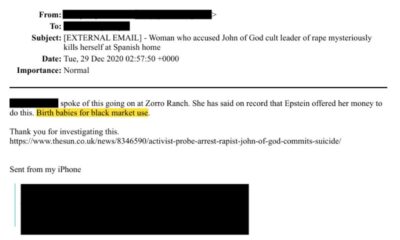

Bioetica1 settimana faAborti traumatici nei file di Epstein

-

Autismo1 settimana fa

Autismo1 settimana faGli scienziati pubblicano una «mappa» su come l’alluminio nei vaccini può causare lesioni cerebrali che scatenano l’autismo

-

Misteri5 giorni fa

Misteri5 giorni faLe porte del pandemonio di Epstein

-

Misteri1 settimana fa

Misteri1 settimana faAllevamenti di bambini al mercato nero: l’orrore emerge dai file di Epstein

-

Sorveglianza2 settimane fa

Sorveglianza2 settimane faPerugia ti aspetta al varco ZTL

-

Spirito2 settimane fa

Spirito2 settimane faMons. Viganò sull’annuncio delle consacrazioni della FSSPX

-

Pensiero1 settimana fa

Pensiero1 settimana faConsacrazioni FSSPX, non «chi», ma «quanti»: il sogno di un fedele