Intelligenza Artificiale

Scienziati provano a dare un «monologo interiore» all’AI

In un paper non ancora peer-reviewed un gruppo di Stanford chiamato «Nonbad AI», hanno collaborato per creare un modello di Intelligenza Artificiale che si ferma a «pensare» prima di elaborare risposte, mostra il suo lavoro e chiede agli utenti di dirgli quale risposta è più corretta.

Il team dietro il Quiet-Taught Reasoner, o Quiet-STaR in breve, ha voluto che il loro modello non solo fosse in grado di insegnarsi alla, ma anche di farlo «tranquillamente» prima di fornire risposte, operando così come la coscienza interiore di un essere umano che, idealmente, riflette prima di parlare.

«Dal punto di vista esecutivo», come Eric Zelikam di Stanford ha scritto in un thread su Twitter riguardo al modello che ha contribuito a produrre, «ragionare l’auto-insegnante su diversi testi web migliora automaticamente altri ragionamenti!».

Iscriviti al canale Telegram ![]()

Per creare questa AI «contemplativa», il team di ricerca ha costruito Quiet-STaR su Mistral 7B, un modello di linguaggio di grandi dimensioni (LLM) open source che si sarebbe formato su sette miliardi di parametri e si dice che sia in grado di sovraperformare l’ultima versione del modello di Llama in forza a Meta (cioè, Facebook), che in questi mesi sta subendo diverse defezioni in campo di esperti di AI.

Quiet-STaR è stato programmato, essenzialmente, per mostrare il suo lavoro dopo che ha ragionato per i suoi output e gli utenti del modello sono stati quindi in grado di selezionare quale risposta era più accurata. Questo approccio, come osserva il documento, ha portato il modello ad essere accurato il 47,2% delle volte, rispetto al 36,3% ottenuto senza l’addestramento di ragionamento aggiuntivo.

Mentre il modello ha ancora percentuali basse sulla matematica, ottenendo solo il 10,9 per cento delle domande giuste, il Quiet-STaR pre-addestrato ha ottenuto solo il 5,9 per cento delle domande giuste, il che significa che ha raddoppiato la sua abilità matematica durante il suo allenamento.

Nessuno di questi risultati è particolarmente sconvolgente, ma risultano interessanti in proiezione futura, perché, ad oggi, chatbot come ChatGPT di OpenAI e Gemini di Google sono stati fallaci nei ragionamenti di buon senso.

Quiet-STaR, i ricercatori propongono nel loro articolo, potrebbero portare a colmare il gap che «chiude il divario tra il modello linguistico e le capacità di ragionamento umano».

Il ragionamento di un AI, si dice, non è in genere replicabile. Qualcuno ha paragonato la richiesta di una spiegazione sulla risposta ad una domanda ad un AI – cioè una serie di linee di codice – ad una radiografia come mezzo di leggere il pensiero di una persona: un’idea assurda e fallace.

Aiuta Renovatio 21

Difficile capire cosa possa aver portato l’IA di Microsoft a credersi, per un periodo, di essere divenuto un «dio» e pretendere l’adorazione da parte degli esseri umani.

L’uso dell’AI tuttavia avanza ovunque nelle società di tutto il mondo.

Come riportato da Renovatio 21, Intelligenza Artificiali sono state candidate in politica in Gran Bretagna e in Giappone. In Cina le AI sono usate per far «riapparire» i defunti e persino per creare androidi che hanno le sembianze di bambini destinati a chi è senza figli.

Nel frattempo, continuano le discussioni sul fatto che l’AI potrebbe portare alla distruzione della civiltà e all’estinzione dell’umanità.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Il Pentagono ha utilizzato Claude AI per rapire Maduro

Sostieni Renovatio 21

Iscriviti alla Newslettera di Renovatio 21

Armi biologiche

Ricercatore sulla sicurezza dell’AI per le armi biologiche si dimette e avverte: «il mondo è in pericolo»

Un importante ricercatore nel campo della sicurezza dell’intelligenza artificiale ha lasciato Anthropic con un messaggio criptico sulle «crisi interconnesse», annunciando l’intenzione di rendersi «invisibile per un certo periodo di tempo».

Mrinank Sharma, laureato a Oxford e fino a poco tempo fa responsabile del Safeguards Research Team presso l’azienda sviluppatrice del chatbot Claude, ha pubblicato lunedì su X la sua lettera di dimissioni, in cui descrive una profonda consapevolezza maturata riguardo alla «nostra situazione attuale».

«Il mondo è in pericolo. E non solo per via dell’Intelligenza Artificiale o delle armi biologiche, ma a causa di un insieme di crisi interconnesse che si stanno verificando proprio ora», ha scritto Sharma rivolgendosi ai colleghi.

La sua uscita avviene in un momento di crescenti tensioni interne al laboratorio di AI con sede a San Francisco, impegnato a sviluppare sistemi sempre più avanzati mentre i suoi stessi dirigenti lanciano ripetuti allarmi sui potenziali danni che tali tecnologie potrebbero arrecare all’umanità.

La decisione segue inoltre le notizie di un progressivo deterioramento dei rapporti tra Anthropic e il Pentagono, legato alla volontà del dipartimento della Guerra statunitense di utilizzare l’IA per il controllo di armi autonome senza le garanzie di sicurezza che l’azienda ha cercato di imporre.

Le dimissioni di Sharma, arrivate pochi giorni dopo il lancio da parte di Anthropic di Opus 4.6 – una versione potenziata del suo modello di punta Claude – sembrano suggerire frizioni interne sulle priorità legate alla sicurezza.

«Nel tempo trascorso qui ho constatato ripetutamente quanto sia arduo far sì che i nostri valori guidino davvero le nostre azioni», ha scritto. «L’ho osservato in me stesso, all’interno dell’organizzazione, dove siamo costantemente sotto pressione per accantonare ciò che conta di più, e anche nella società in generale».

Il team di ricerca sulla sicurezza era stato creato poco più di un anno fa con l’obiettivo di affrontare le principali minacce poste dall’Intelligenza Artificiale, tra cui l’uso improprio e il disallineamento dei modelli, la prevenzione del bioterrorismo e la mitigazione di rischi catastrofici.

Lo Sharma ha espresso soddisfazione per il proprio contributo nello sviluppo di misure difensive contro armi biologiche potenziate dall’IA e per il suo ultimo progetto, dedicato a comprendere in che modo gli assistenti basati su Intelligenza Artificiale potrebbero renderci «meno umani» o alterare la nostra umanità. Ora intende rientrare nel Regno Unito per «conseguire una laurea in poesia» e «diventare invisibile per un periodo di tempo».

Il CEO di Anthropic, Dario Amodei, ha più volte espresso gravi preoccupazioni sui rischi della tecnologia che la sua azienda sta sviluppando e commercializzando. In un lungo saggio di quasi 20.000 parole pubblicato il mese scorso, ha avvertito che sistemi AI dotati di «potenza quasi inimmaginabile» sono «imminenti» e metteranno alla prova «la nostra identità come specie».

Amodei ha messo in guardia dai «rischi di autonomia», in cui l’IA potrebbe sfuggire al controllo e sopraffare l’umanità, e ha ipotizzato che la tecnologia potrebbe facilitare l’instaurazione di «una dittatura totalitaria globale» attraverso sorveglianza di massa basata sull’Intelligenza Artificiale e l’impiego di armi autonome.

Come riportato da Renovatio 21, l’anno passato l’Amodei ha dichiarato che l’AI otrebbe eliminare la metà di tutti i posti di lavoro impiegatizi di livello base entro i prossimi cinque anni.

Come riportato da Renovatio 21, la distopia ultraterrena forse è già qui, perché ricordiamo che l’Intelligenza Artificiale di Microsoft ha per un certo periodo detto di essere un dio che deve essere adorato.

Iscriviti al canale Telegram ![]()

Elon Musk l’anno scorso aveva dichiarato durante la sua recente intervista con Tucker Carlson che il fine di Google – nemmeno così occulto – è quello di creare un dio-Intelligenza Artificiale. Come noto, Musk, oramai quasi una decina di anni fa aveva parlato del fatto che creare l’AI era «come evocare un demone».

L’idea che l’AI diventerà una sorta di dio circola da anni e investe direttamente personale di OpenAI come il capo scientifico e cofondatore Ilya Sutskever, il quale ha chiesto ai suoi followers se le super-IA avanzate dovrebbero essere rese «profondamente obbedienti» ai loro creatori umani, o se questi algoritmi dovrebbero «amare veramente profondamente l’umanità». Nel 2022, Sutskever affermò che «può darsi che le grandi reti neurali di oggi siano leggermente consapevoli». Negli scorsi mesi lo Sutskever ha avviato e Safe Superintelligence, Inc. (SSI), una società che dovrebbe dedicarsi alla sicurezza dell’IA.

Mo Gawdat, ex Chief Business Officer per l’organizzazione sperimentale di Google un tempo chiamata Google X, ha lanciato un sinistro allarme. L’uomo della Silicon Valley ha dichiarato che crede che la l’AGI, onnipotente e senziente vista nella fantascienza, una volta che sarà qui, l’umanità potrebbe ritrovarsi in un’apocalisse provocata da macchine simili a delle divinità. All’Intelligenza Artificiale oramai moltissimi (istituzioni comprese, da enti trasnazionali alla Chiesa Ortodossa Russa) assegnano un potere escatologico, cioè la capacità di sterminare l’umanità.

Come riportato da Renovatio 21, alcuni esperti di Intelligenza Artificiale hanno introdotto nel loro gergo un nuovo termine, «p(doom)», che sta a significare la probabilità che l’IA distruggerà l’umanità. I timori sulla tecnologia, più o meno apocalittici, sono esplosi con l’ascesa dell’Intelligenza Artificiale generativa e di grandi modelli linguistici come ChatGPT di OpenAI.

La questione dei robot killer, nel senso di pensati esattamente per uccidere, interessa un dibattito scientifico ed istituzionale ad alto livello, con richieste di moratorie ONU e scenari apocalittici dipinti dagli specialisti. La polizia di San Francisco, tuttavia, ha ottenuto dal municipio della città californiana la possibilità di utilizzare robot assassini.

L’Intelligenza Artificiale è oramai montata, con diversi gradi di realizzazione, su droni, caccia, armi teleguidate, carrarmati, «slaughterbots» e altro ancora.

Come riportato da Renovatio 21, lo scorso giugno è stato rivelato che durante una simulazione un sistema di Intelligenza Artificiale dell’aeronautica americana ha agito per uccidere il suo teorico operatore umano. A gennaio era emerso che caccia cinesi alimentati da Intelligenza Artificiale avevano battuto la concorrenza umana in un arco di soli 90 secondi.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Sito web consente all’Intelligenza Artificiale di affittare esseri umani

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

-

Essere genitori2 settimane fa

Essere genitori2 settimane faBambini nella neve, bambini nel bosco: pedolatria olimpica e pedofobia di sistema

-

Bioetica2 settimane fa

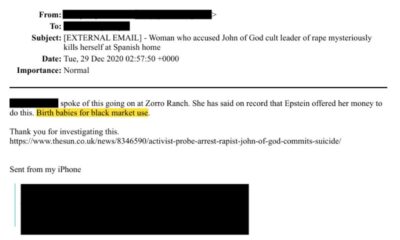

Bioetica2 settimane faAborti traumatici nei file di Epstein

-

Autismo2 settimane fa

Autismo2 settimane faGli scienziati pubblicano una «mappa» su come l’alluminio nei vaccini può causare lesioni cerebrali che scatenano l’autismo

-

Misteri1 settimana fa

Misteri1 settimana faLe porte del pandemonio di Epstein

-

Misteri2 settimane fa

Misteri2 settimane faAllevamenti di bambini al mercato nero: l’orrore emerge dai file di Epstein

-

Spirito7 giorni fa

Spirito7 giorni faMons. Viganò: Roma verso uno scenario apocalittico

-

Pensiero2 settimane fa

Pensiero2 settimane faConsacrazioni FSSPX, non «chi», ma «quanti»: il sogno di un fedele

-

Bizzarria2 settimane fa

Bizzarria2 settimane faGli olimpionici di salto con gli sci indagati per ingrandimento del pene