Sanità

Infermiera tedesca accusata di aver eseguito 40 mila vaccinazioni false

La Germania è sconvolta.

Un’infermiera di 40 anni della Frisia, un land settentrionale, potrebbe aver somministrato a migliaia di persone un’iniezione di soluzione salina piuttosto che un vaccino contro il COVID-19.

Le autorità hanno annunciato che potrebbe essere quindi necessario rivaccinare circa 8.600 persone.

Le iniezioni sospette sarebbero state somministrate a marzo e aprile da una donna che aveva espresso opinioni anti-vaccinazione sui social media. Al momento non si sa molto di più: potrebbe trattarsi, in effetti, di pura isteria anti «no-vax» da parte dei media e soprattutto delle autorità: del resto è di ieri il fatto clamoroso dell’uso dell’espressione «no-vax» nelle comunicazioni ufficiali del Ministero dell’Istruzione italiano.

La CNN ha riferito che l’infermiera tedesca aveva accesso ai vaccini perché era «responsabile della preparazione dei vaccini e della preparazione delle siringhe durante il suo orario di lavoro nel centro di vaccinazione».

L’avvocato dell’infermiera ha parlato con i media; la sua assistita ammesso di aver fatto iniezioni saline almeno sei volte. Ha detto di essere andata nel panico dopo aver rotto una fiala di vaccino e lo ha fatto solo per mantenere il suo lavoro. Tuttavia, le autorità temono che sarebbe potuto accadere molte altre volte. La polizei sta indagando.

Un portavoce del ministero della salute della Bassa Sassonia ha affermato che sembra che non si siano verificate gravi infezioni da COVID-19 a seguito delle iniezioni di soluzione salina.

Come spesso accade, la Germania arriva dopo l’Italia, scopiazzando e scimmiottando.

Come spesso accade, la Germania arriva dopo l’Italia, scopiazzando e scimmiottando.

All’altezza dell’entrata in vigore della legge Lorenzina, nel trevigiano si ebbe il caso di un’assistente sanitaria «accusata di aver “vaccinato per finta” migliaia di bambini».

Il processo alla bellissima infermiera è ancora in corso, e gli avvocati negano.

Sempre a Treviso una seconda infermiera è stata indagata quest’anno per una presunta «falsa vaccinazione». Secondo quanto riportato dai giornali, ad accorgersene starebbe stato un carabiniere, allarmato dalla puntura che (a quanto dice) non gli aveva iniettato il prezioso siero antipandemico.

Sul caso indagano i Nuclei antisofisticazioni (NAS), che fanno parte proprio dell’arma dei carabinieri.

Immagine d’archivio

Intelligenza Artificiale

Quando i medici vengono sostituiti da un protocollo

Renovatio 21 traduce e pubblica questo articolo del Brownstone Institute.

La mia esperienza in medicina mi permette di distinguere tra vera innovazione e sottile riclassificazione che altera radicalmente la pratica medica pur rimanendo immutata. L’intelligenza artificiale ha recentemente attirato notevole attenzione, inclusa l’affermazione ampiamente diffusa secondo cui l’IA è stata «legalmente autorizzata a esercitare la professione medica» negli Stati Uniti. Interpretata letteralmente, questa affermazione è imprecisa.

Nessun collegio medico ha concesso l’autorizzazione a una macchina. Nessun algoritmo ha prestato giuramento, accettato obblighi fiduciari o assunto la responsabilità personale per i danni ai pazienti. Nessun medico robot apre una clinica, fattura alle compagnie assicurative o si presenta davanti a una giuria per negligenza medica.

Tuttavia, fermarsi a questa osservazione significa trascurare la questione più ampia. I concetti giuridici di responsabilità sono attualmente in fase di ridefinizione, spesso senza che l’opinione pubblica ne sia consapevole.

Sostieni Renovatio 21

È in atto una trasformazione significativa, che giustifica più di un semplice rifiuto riflessivo o di un acritico entusiasmo tecnologico. L’attuale sviluppo non riguarda l’abilitazione dell’Intelligenza Artificiale come medico, ma piuttosto la graduale erosione del confine fondamentale della medicina: il legame intrinseco tra giudizio clinico e responsabilità umana. Il giudizio clinico implica l’assunzione di decisioni informate, adattate alle esigenze e alle circostanze specifiche di ciascun paziente, e richiede empatia, intuizione e una profonda comprensione dell’etica medica.

La responsabilità umana si riferisce alla responsabilità che gli operatori sanitari si assumono per queste decisioni e i loro esiti. Questa erosione non è il risultato di una legislazione drastica o di un dibattito pubblico, ma avviene silenziosamente attraverso programmi pilota, reinterpretazioni normative e un linguaggio che oscura intenzionalmente la responsabilità. Una volta che questo confine si dissolve, la medicina si trasforma in modi difficili da invertire.

La preoccupazione principale non è se l’intelligenza artificiale possa rinnovare le prescrizioni o individuare risultati di laboratorio anomali. La medicina utilizza da tempo strumenti e gli operatori sanitari generalmente accolgono con favore un aiuto che riduca le attività amministrative o migliori il riconoscimento di schemi. Il vero problema è se il giudizio medico – la decisione sulle azioni corrette, sui pazienti e sui rischi – possa essere visto come un risultato generato dal computer, separato dalla responsabilità morale. Storicamente, gli sforzi per separare il giudizio dalla responsabilità hanno spesso causato danni senza assumersene la responsabilità.

Sviluppi recenti chiariscono le origini dell’attuale confusione. In diversi stati, programmi pilota limitati consentono ora ai sistemi basati sull’Intelligenza Artificiale di assistere nel rinnovo delle prescrizioni per patologie croniche stabili, secondo protocolli rigorosamente definiti. A livello federale, la proposta di legge ha valutato se l’Intelligenza Artificiale possa essere considerata un «professionista» per specifici scopi statutari, a condizione che sia adeguatamente regolamentata.

Queste iniziative sono in genere presentate come risposte pragmatiche alla carenza di medici, ai ritardi di accesso e alle inefficienze amministrative. Sebbene nessuna di queste designi esplicitamente l’intelligenza artificiale come medico, nel loro insieme normalizzano la premessa più preoccupante secondo cui le azioni mediche possono essere intraprese senza un decisore umano chiaramente identificabile.

Aiuta Renovatio 21

Nella pratica, questa distinzione è fondamentale. La medicina non è definita dall’esecuzione meccanica di compiti, ma dall’assegnazione di responsabilità quando i risultati sono sfavorevoli. Scrivere una prescrizione è semplice; assumersi la responsabilità delle sue conseguenze – in particolare quando si considerano comorbilità, contesto sociale, valori del paziente o informazioni incomplete – è molto più complesso. Nel corso della mia carriera, questa responsabilità è sempre ricaduta su un essere umano che poteva essere interrogato, sfidato, corretto e ritenuto responsabile. Quando il dott. Smith commette un errore, la famiglia sa chi contattare, garantendo un filo diretto con la responsabilità umana. Nessun algoritmo, a prescindere dalla sua complessità, può svolgere questo ruolo.

Il rischio principale non è tecnologico, ma normativo e filosofico. Questa transizione rappresenta un passaggio dall’etica della virtù al proceduralismo. Quando legislatori e istituzioni ridefiniscono il processo decisionale medico in funzione dei sistemi piuttosto che degli atti personali, il quadro morale della medicina cambia. La responsabilità diventa diffusa, il danno è più difficile da attribuire e la responsabilità si sposta dai medici ai processi, dal giudizio all’aderenza al protocollo. Quando inevitabilmente si verificano errori, la spiegazione prevalente diventa che «il sistema ha seguito linee guida stabilite». Riconoscere questa transizione chiarisce il passaggio dal processo decisionale etico individualizzato all’aderenza procedurale meccanizzata.

Questa preoccupazione non è teorica. L’assistenza sanitaria contemporanea si trova già ad affrontare sfide legate alla scarsa responsabilità. Ho osservato pazienti danneggiati da decisioni basate su algoritmi perdersi tra amministratori, fornitori e modelli opachi, senza una risposta chiara alla domanda fondamentale: chi ha preso questa decisione? L’Intelligenza Artificiale accelera significativamente questo problema. Un algoritmo non può fornire spiegazioni morali, esercitare moderazione basata sulla coscienza, rifiutare azioni per preoccupazioni etiche o ammettere errori a un paziente o a una famiglia.

I sostenitori di una maggiore autonomia dell’IA citano spesso l’efficienza come giustificazione. Le cliniche sono sovraccariche di lavoro, i medici sono in preda al burnout e i pazienti spesso aspettano mesi per cure che dovrebbero durare solo pochi minuti. Queste preoccupazioni sono legittime e qualsiasi medico onesto le riconosce. Tuttavia, l’efficienza da sola non giustifica l’alterazione dei fondamenti etici della medicina. I sistemi ottimizzati per velocità e scalabilità spesso sacrificano sfumature, discrezione e dignità individuale. Storicamente, la medicina ha resistito a questa tendenza sottolineando che la cura è fondamentalmente una relazione piuttosto che una transazione.

L’Intelligenza Artificiale rischia di invertire questa relazione. Quando sono i sistemi, anziché gli individui, a erogare assistenza, il paziente non è più coinvolto in un patto con un medico, ma diventa parte di un flusso di lavoro. Il medico assume il ruolo di supervisore della macchina o, cosa ancora più preoccupante, funge da cuscinetto legale che assorbe la responsabilità per decisioni non prese personalmente. Col tempo, il giudizio clinico cede il passo all’aderenza al protocollo e l’agire morale diminuisce gradualmente.

L’Intelligenza Artificiale introduce anche un problema più sottile e pericoloso: il mascheramento dell’incertezza. La medicina vive nell’ambiguità. Le prove sono probabilistiche. Le linee guida sono provvisorie. I pazienti raramente si presentano come set di dati puliti. I medici sono addestrati non solo ad agire, ma anche a esitare, a riconoscere quando le informazioni sono insufficienti, quando un intervento può causare più danni che benefici o quando la strada giusta è aspettare. Immaginate uno scenario in cui l’Intelligenza Artificiale raccomanda la dimissione, ma il coniuge del paziente appare timoroso, evidenziando la tensione tra il processo decisionale algoritmico e l’intuizione umana. Tale attrito nel mondo reale sottolinea la posta in gioco dell’ambiguità.

I sistemi di Intelligenza Artificiale non sperimentano incertezza; generano output. Quando sono errati, spesso lo fanno con una sicurezza ingiustificata. Questa caratteristica non è un difetto di programmazione, ma una caratteristica intrinseca della modellazione statistica. A differenza dei medici esperti che esprimono apertamente dubbi, i modelli linguistici di grandi dimensioni e i sistemi di apprendimento automatico non sono in grado di riconoscere i propri limiti. Producono risposte plausibili anche quando i dati sono insufficienti. In medicina, la plausibilità senza fondamento può essere rischiosa.

Man mano che questi sistemi vengono integrati tempestivamente nei flussi di lavoro clinici, i loro risultati influenzano sempre di più le decisioni successive. Col tempo, i medici potrebbero iniziare a fidarsi delle raccomandazioni non per la loro validità, ma perché sono diventate standardizzate. Il giudizio si sposta gradualmente dal ragionamento attivo all’accettazione passiva. In tali circostanze, la presenza umana nel ciclo funge da mero strumento di salvaguardia simbolica.

Iscriviti alla Newslettera di Renovatio 21

I sostenitori affermano spesso che l’IA si limiterà a «migliorare» i medici, piuttosto che sostituirli. Tuttavia, questa rassicurazione è labile. Una volta che l’IA dimostra guadagni in termini di efficienza, le pressioni economiche e istituzionali tendono a favorire una maggiore autonomia. Se un sistema può rinnovare le prescrizioni in modo sicuro, potrebbe presto essere autorizzato a iniziarle. Se riesce a diagnosticare accuratamente patologie comuni, la necessità della revisione medica viene messa in discussione. Se supera gli esseri umani in benchmark controllati, la tolleranza alla variabilità umana diminuisce.

Alla luce di queste tendenze, è essenziale implementare misure di salvaguardia specifiche. Ad esempio, audit obbligatori sulle discrepanze sul 5% delle decisioni basate sull’Intelligenza Artificiale potrebbero fungere da controllo concreto, garantendo l’allineamento tra le raccomandazioni dell’Intelligenza Artificiale e il giudizio clinico umano, fornendo al contempo alle autorità di regolamentazione e ai consigli di amministrazione ospedalieri metriche concrete per monitorare l’integrazione dell’Intelligenza Artificiale.

Queste domande non sono poste con cattive intenzioni; emergono naturalmente all’interno di sistemi focalizzati sul contenimento dei costi e sulla scalabilità. Tuttavia, indicano un futuro in cui il giudizio umano diventerà l’eccezione piuttosto che la norma. In un simile scenario, gli individui con risorse continueranno a ricevere cure umane, mentre altri saranno indirizzati attraverso processi automatizzati. La medicina a due livelli non sarà il risultato di un’ideologia, ma di un’ottimizzazione.

Ciò che rende questo momento particolarmente precario è l’assenza di chiare linee di responsabilità. Quando una decisione guidata dall’Intelligenza Artificiale danneggia un paziente, chi è responsabile? È il medico che supervisiona nominalmente il sistema? L’istituzione che lo ha implementato? Il fornitore che ha addestrato il modello? L’ente regolatore che ne ha approvato l’uso? Senza risposte esplicite, la responsabilità svanisce. E quando la responsabilità svanisce, la fiducia segue a ruota.

La medicina si basa fondamentalmente sulla fiducia. I pazienti affidano il loro corpo, le loro paure e spesso le loro vite nelle mani dei medici. Questa fiducia non può essere trasferita a un algoritmo, per quanto sofisticato possa essere. Si basa sulla certezza della presenza di un essere umano, qualcuno capace di ascoltare, adattarsi e assumersi la responsabilità delle proprie azioni.

Rifiutare del tutto l’Intelligenza Artificiale è superfluo. Se utilizzata con giudizio, l’IA può ridurre gli oneri amministrativi, identificare modelli che potrebbero sfuggire al rilevamento umano e supportare il processo decisionale clinico. Può consentire ai medici di dedicare più tempo all’assistenza ai pazienti piuttosto che alle attività amministrative. Tuttavia, realizzare questo futuro richiede un chiaro impegno a mantenere la responsabilità umana al centro della pratica medica.

«Human-in-the-loop» deve significare più di una supervisione simbolica. Dovrebbe richiedere che un individuo specifico sia responsabile di ogni decisione medica, ne comprenda le motivazioni e mantenga sia l’autorità che l’obbligo di ignorare le raccomandazioni algoritmiche. Deve inoltre implicare trasparenza, spiegabilità e consenso informato del paziente, nonché l’impegno a investire nei medici umani anziché sostituirli con l’Intelligenza Artificiale.

Iscriviti al canale Telegram ![]()

Il rischio principale non è l’eccessivo potere dell’Intelligenza Artificiale, ma piuttosto la volontà delle istituzioni di rinunciare alle proprie responsabilità. Nella ricerca di efficienza e innovazione, c’è il rischio che la medicina diventi un campo tecnicamente avanzato e amministrativamente snello, ma privo di sostanza morale.

Mentre pensiamo al futuro, è essenziale chiedersi: che tipo di guaritore immaginiamo al capezzale del paziente nel 2035? Questa domanda richiede un’immaginazione morale collettiva, incoraggiandoci a plasmare un futuro in cui la responsabilità umana e l’assistenza compassionevole rimangano al centro della pratica medica. Mobilitare l’azione collettiva sarà fondamentale per garantire che i progressi nell’Intelligenza Artificiale migliorino, anziché indebolire, questi valori fondamentali.

L’Intelligenza Artificiale non è autorizzata a esercitare la professione medica. Ma la medicina viene silenziosamente riprogettata attorno a sistemi privi di peso morale. Se questo processo continua senza controllo, un giorno potremmo scoprire che il medico non è stato sostituito da una macchina, ma da un protocollo, e che quando si verifica un danno, non c’è più nessuno che possa risponderne.

Questo non sarebbe un progresso. Sarebbe un’abdicazione.

Joseph Varon

Joseph Varon, MD, è medico di terapia intensiva, professore e presidente dell’Independent Medical Alliance. È autore di oltre 980 pubblicazioni peer-reviewed ed è caporedattore del Journal of Independent Medicine.

Iscriviti alla Newslettera di Renovatio 21

Epidemie

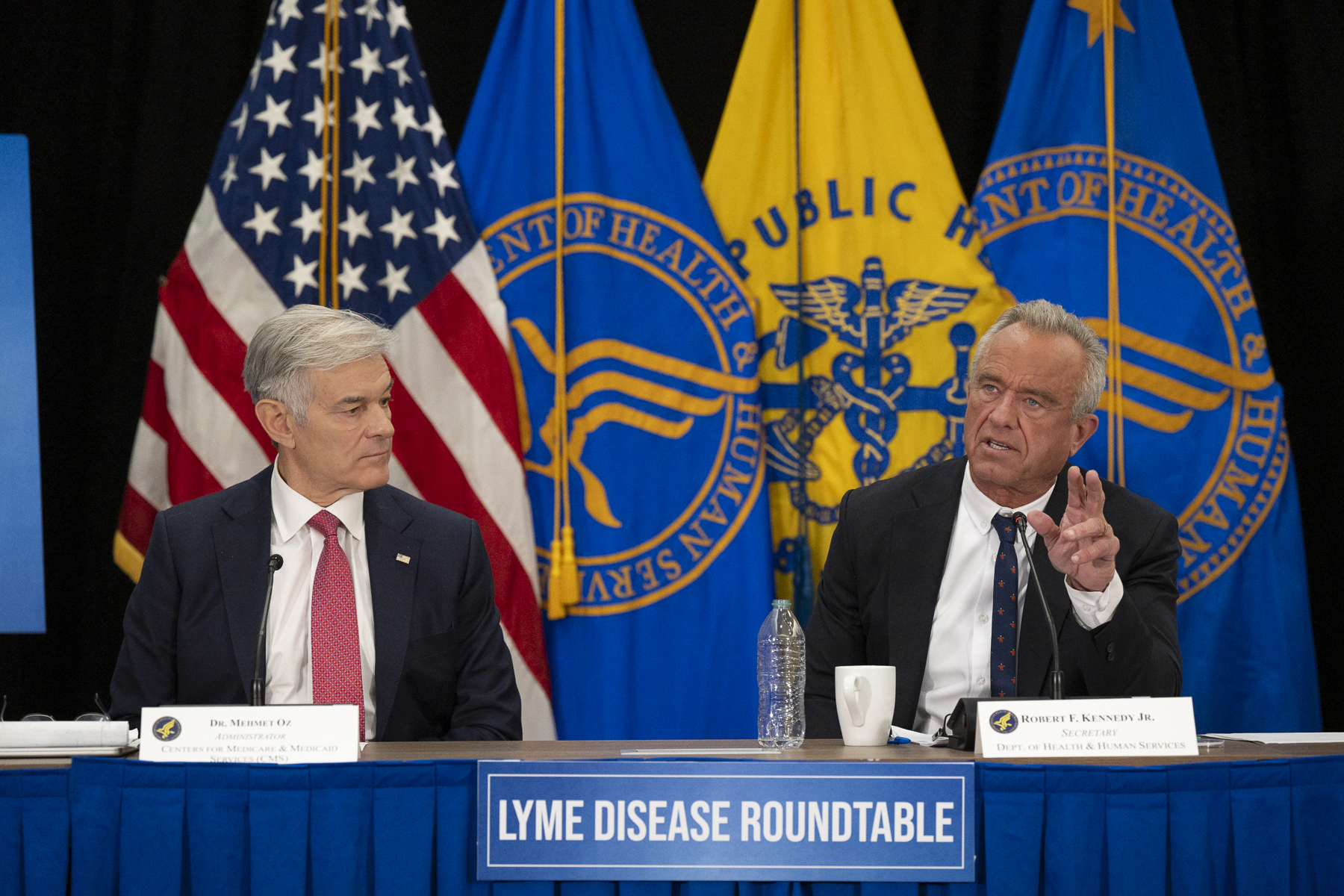

Kennedy: RFK Jr.: «la manipolazione psicologica dei pazienti affetti dalla malattia di Lyme è finita»

Iscriviti alla Newslettera di Renovatio 21

«Questa malattia ha distrutto delle vite»

La malattia di Lyme è un’infezione batterica che si diffonde attraverso le punture di zecca. I Centers for Disease Control and Prevention stimano che ogni anno vengano diagnosticate e trattate 476.000 persone. I dati federali suggeriscono che nell’ultimo decennio tra i 5 e i 7 milioni di americani siano stati infettati. Secondo il Dipartimento della Salute e dei Servizi Umani degli Stati Uniti (HHS), gli attuali test basati sugli anticorpi spesso non rilevano le infezioni in fase iniziale e avanzata, ritardando il trattamento. Fino al 20% dei pazienti presenta sintomi persistenti che degenerano in patologie croniche e debilitanti. I relatori hanno sottolineato ripetutamente che la malattia di Lyme non è una semplice infezione, ma una malattia complessa e multisistemica, spesso complicata da coinfezioni che possono imitare o scatenare altre condizioni, tra cui la sclerosi multipla, l’artrite reumatoide e la fibromialgia. «Conosco moltissime persone la cui vita è stata distrutta da questa malattia, che vanno da un medico all’altro nel tentativo di trovare qualcuno che possa curarle», ha detto Kennedy. Ha descritto la tavola rotonda come un punto di svolta. «Questa giornata segna una pietra miliare per questa agenzia, in cui riconosciamo che si tratta di una malattia», ha affermato. «Uno dei motivi per cui abbiamo voluto ospitare questo incontro, come ho chiarito, è annunciare al mondo che il gaslighting sui pazienti affetti dalla malattia di Lyme è finito».Sostieni Renovatio 21

L’Intelligenza Artificiale, i nuovi test e la copertura Medicare segnalano una rottura con la precedente politica sulla malattia di Lyme

Il secondo panel si è concentrato sull’innovazione, con ricercatori dell’HHS, dei National Institutes of Health e di istituzioni private che hanno illustrato nuovi strumenti diagnostici e approcci basati sui dati per il trattamento della malattia di Lyme. I relatori hanno evidenziato i test di rilevamento diretto, l’apprendimento automatico per analizzare dati biologici complessi e le terapie progettate per affrontare sia le infezioni che le infiammazioni croniche. Nel corso della sessione, Kennedy ha annunciato il rinnovo del LymeX Innovation Accelerator, un partenariato pubblico-privato lanciato nel 2020 e sostenuto dalla Steven & Alexandra Cohen Foundation. Secondo l’HHS, il programma prevede oltre 10 milioni di dollari in finanziamenti per promuovere lo sviluppo di sistemi diagnostici di nuova generazione, con diversi team attualmente impegnati nella convalida clinica e nella revisione normativa. Secondo l’HHS, il rinnovato impegno si concentrerà sull’innovazione incentrata sul paziente e sugli strumenti diagnostici basati sull’intelligenza artificiale «che supportano un rilevamento più precoce e accurato in tutte le fasi dell’infezione». L’HHS ha inoltre inaugurato una pagina web sulla malattia di Lyme e delineato una strategia nazionale che mette in risalto i dati aperti, la ricerca trasparente e il coinvolgimento diretto dei pazienti. In un importante aggiornamento delle norme, Mehmet Oz, amministratore dei Centers for Medicare and Medicaid Services, ha chiarito che Medicare coprirà esplicitamente l’assistenza per la malattia di Lyme cronica secondo le linee guida aggiornate sulla gestione delle cure croniche per condizioni complesse. «Possiamo coprire la malattia di Lyme cronica. In realtà è già coperta», ha detto Oz. La malattia di Lyme cronica ha fattori scatenanti infettivi chiaramente identificabili, quindi «abbiamo aggiornato il nostro sito web per renderlo più chiaro», ha aggiunto.Iscriviti al canale Telegram ![]()

«Il peso è enorme» per i pazienti e le famiglie

I legislatori hanno accolto con favore il cambiamento. Il deputato repubblicano della Virginia Morgan Griffith, che ha dichiarato di soffrire della sindrome di Alpha-gal, nota anche come allergia alla carne rossa, legata all’esposizione alle zecche, ha definito la discussione un segno di serio impegno federale. “La tavola rotonda di oggi dimostra che il Segretario Kennedy, il Dott. Oz e i legislatori si sono impegnati fermamente per affrontare la malattia di Lyme e altre malattie trasmesse dalle zecche negli Stati Uniti”, ha affermato Griffith nel comunicato stampa dell’HHS. Le storie dei pazienti hanno evidenziato il costo umano della malattia di Lyme. Olivia Goodreau ha affermato di aver consultato 51 medici nell’arco di 18 mesi prima di ricevere una diagnosi di Lyme. La diagnosi è stata seguita da anni di test per identificare molteplici coinfezioni. Samuel Sofie ha descritto le famiglie che prosciugano i propri risparmi alla ricerca di cure efficaci. «Alcuni pazienti passano anni a investire tutti i loro soldi nelle cure, ma non migliorano», ha detto Sofie. Kennedy ha sottolineato che la malattia di Lyme contribuisce in modo significativo alle malattie croniche in tutto il Paese. «Il peso è enorme. E i costi economici non sono stati quantificati da nessuna parte, ma… ci sono costi collaterali di ogni tipo. Quando le persone non possono lavorare, le famiglie vengono distrutte. E ho visto la pressione che questo esercita sulle famiglie», ha affermato. Il vicesegretario dell’HHS, Jim O’Neill, ha inquadrato la tavola rotonda come parte di un più ampio sforzo federale per affrontare le malattie croniche attraverso la tecnologia. «Questo evento dimostra che non aspettiamo il nuovo anno per agire», ha affermato. I sostenitori hanno accolto con favore il cambiamento, ma hanno sottolineato la necessità di darne seguito. Dorothy Kupcha Leland, presidente di LymeDisease.org, ha scritto sul suo blog che la tavola rotonda ha affrontato esigenze di lunga data dei pazienti, tra cui test, trattamenti e copertura assicurativa migliori, ma ha avvertito che un cambiamento significativo richiederà una volontà politica costante, infrastrutture e finanziamenti. «Non è stato un brutto modo per iniziare una conversazione tanto necessariaÌ, ha scritto. «Ma resta da vedere se ne uscirà qualcosa». Lo staff di The Defender © 22 dicembre 2025, Children’s Health Defense, Inc. Questo articolo è riprodotto e distribuito con il permesso di Children’s Health Defense, Inc. Vuoi saperne di più dalla Difesa della salute dei bambini? Iscriviti per ricevere gratuitamente notizie e aggiornamenti da Robert F. Kennedy, Jr. e la Difesa della salute dei bambini. La tua donazione ci aiuterà a supportare gli sforzi di CHD. Renovatio 21 offre questa traduzione per dare una informazione a 360º. Ricordiamo che non tutto ciò che viene pubblicato sul sito di Renovatio 21 corrisponde alle nostre posizioni.Iscriviti alla Newslettera di Renovatio 21

Gender

Studio della Sanità USA conferma i pericoli dei farmaci transgender e degli interventi chirurgici sui minori

Il Dipartimento della Salute e dei Servizi Umani (HHS) ha reso pubblico mercoledì un atteso rapporto sottoposto a revisione paritaria, che mette in guardia contro i rischi dell’«assistenza di affermazione di genere» per i minori, scatenando l’ira delle associazioni pro-LGBTQ+.

Lo studio, intitolato «Trattamento della disforia di genere pediatrica: revisione delle prove e delle migliori pratiche», si basa su un’analisi preliminare diffusa a maggio sui giovani con confusione di genere. Conferma che bloccanti della pubertà, ormoni di sesso opposto e interventi chirurgici provocano «danni significativi e a lungo termine, spesso trascurati o monitorati in modo inadeguato». Tra i rischi elencati: infertilità, disfunzioni sessuali, ridotta densità ossea, effetti cognitivi negativi, problemi cardiovascolari e metabolici, disturbi psichiatrici, complicanze operatorie e rimpianti post-trattamento.

Il segretario HHS Robert F. Kennedy Jr. ha appoggiato le conclusioni, accusando l’establishment medico di «negligenza». «L’American Medical Association e l’American Academy of Pediatrics hanno diffuso la menzogna che procedure chimiche e chirurgiche di rifiuto del sesso potessero giovare ai bambini», ha dichiarato in una nota. «Hanno tradito il giuramento di non nuocere, infliggendo danni fisici e psicologici duraturi a giovani vulnerabili. Questa non è medicina, è negligenza».

Sostieni Renovatio 21

Il rapporto giunge dopo l’ordine esecutivo firmato a gennaio dal presidente Donald Trump, che limita gli interventi di «cambio di sesso» per under 19, definendoli «mutilazioni chimiche e chirurgiche» mascherate da cure mediche necessarie.

Sempre più ospedali e medici stanno riducendo questi trattamenti: tra gli esempi, l’Università del Michigan, Yale Medicine, Kaiser Permanente, il Children’s Hospital di Los Angeles, UChicago Medicine e il Children’s National Hospital di Washington stanno eliminando o limitando bloccanti della pubertà e farmaci analoghi per i minori.

Negli USA circa 2,8 milioni di persone dai 13 anni in su si identificano come transgender, con la Gen Z che raggiunge il 7,6% tra chi si dichiara LGBTQ+.

Oltre al rapporto HHS, un’ampia letteratura scientifica indica che «affermare» la disforia di genere espone a pericoli gravi: oltre l’80% dei bambini la supera spontaneamente entro la tarda adolescenza, e anche una «riassegnazione» completa non riduce i tassi elevati di autolesionismo e suicidio tra chi soffre di confusione di genere.

Inchieste come quella del 2022 sulla Vanderbilt University Medical Center hanno documentato medici che promuovevano questi interventi pur consapevoli dei rischi, ammettendo in email e video che «fanno un sacco di soldi».

L’HHS ha precisato di aver invitato l’American Academy of Pediatrics e l’Endocrine Society a contribuire al rapporto, ma entrambe hanno declinato.

Iscriviti alla Newslettera di Renovatio 21

Immagine di Gage Skidmore via Wikimedia pubblicata su licenza Creative Commons Attribution-Share Alike 2.0 Generic

-

Pensiero2 settimane fa

Pensiero2 settimane faGli uomini invisibili di Crans-Montana

-

Vaccini5 giorni fa

Vaccini5 giorni faGemelli di 18 mesi morti dopo la vaccinazione

-

Spirito2 settimane fa

Spirito2 settimane faConcilio Vaticano II, mons. Viganò contro papa Leone

-

Alimentazione1 settimana fa

Alimentazione1 settimana faRFK Jr. capovolge la piramide alimentare

-

Scienza1 settimana fa

Scienza1 settimana faChimico di fama mondiale smentisce la teoria dell’evoluzione

-

Salute1 settimana fa

Salute1 settimana faI malori della prima settimana 2026

-

Spirito1 settimana fa

Spirito1 settimana faDifendere il patriarcato contro i princìpi infernali della Rivoluzione: omelia di mons. Viganò sulla famiglia come «cosmo divino»

-

Vaccini2 settimane fa

Vaccini2 settimane faIn USA i medici non riceveranno più ricompense economiche per vaccinare i bambini