Intelligenza Artificiale

Card. Eijk: la Chiesa deve dire la sua sull’Intelligenza Artificiale

Lo afferma con forza il cardinale Willem Jacobus Eijk, arcivescovo di Utrecht (Paesi Bassi): la proliferazione di nuovi servizi e offerte di Intelligenza Artificiale (IA) richiede una risposta e una considerazione da parte della Chiesa cattolica.

L’arcivescovo di Utrecht è medico di formazione ed esperto di sessualità e bioetica. Due sono le urgenze per lui: da una parte che la Chiesa sia presente su «chatbot» come ChatGPT o Google Bard, in modo che le risposte comprendano anche il punto di vista religioso.

D’altra parte, è necessario riflettere più ampiamente sull’impatto dell’IA e, in particolare, su come il suo utilizzo, anche nel campo della pastorale e dell’assistenza medica, influisca sul modo in cui le società percepiscono gli esseri umani.

Il porporato, noto per aver chiesto un chiarimento magisteriale della Chiesa sul tema dell’ideologia di genere, è convinto che la Chiesa debba decidere, anche attraverso un documento ufficiale, sull’impatto dell’IA sull’essere umano, che chiede un intervento molto ampio riflessione.

«È difficile avere una panoramica di tutto ciò che l’IA può fare per noi, perché è ancora un ambito poco conosciuto. Ma le tecnologie IA, come i chatbot, possono anche dire qualcosa sulle questioni religiose».

Il fatto è che «la risposta del chatbot è il risultato di un calcolo dell’IA. Ma significa che l’aggiunta di informazioni religiose può influenzare le risposte. Per questo, dobbiamo cercare di essere presenti nel campo dell’IA. Ma l’intelligenza artificiale può fare molto di più del testo. (…) Può rispondere raccogliendo dati e mettendoli in ordine o contesto».

Un esempio lampante è quello di «Bing» di Microsoft, che grazie all’IA si è trasformato da motore di ricerca a quello di chatbot. Un tale sistema può simulare conversazioni con santi sulla base di informazioni trasmesse sulla vita e le parole dei santi.

È necessaria cautela, ma senza aspettare troppo

Il cardinale Eijk ammette che serve una certa prudenza, ma allo stesso tempo: «se aspettiamo troppo, altri avranno introdotto più informazioni che determineranno le risposte. (…) Non conosciamo le conseguenze dell’uso diffuso del software chatbot, ma possiamo già prevedere un certo scenario».

«Questi software commettono errori, ma cosa succederà tra 10, 20 o anche 5 anni? Ci saranno altri tipi di IA, computer molto più potenti in grado di dare risposte molto più precise. Possiamo influenzare le risposte ora. (…) È comprensibile avere paura, perché l’IA può avere conseguenze molto negative per la nostra società».

La questione, prosegue il porporato, non riguarda solo l’uso dei software per l’interazione, ma la questione della «robotizzazione della nostra società, che potrebbe portare alla perdita di molti posti di lavoro, soprattutto per le persone che non hanno svolto alcuno studio specializzato. (…) Perché il robot è una specie di impiegato che non chiede aumento, che lavora 24 ore su 24 senza stancarsi. Potrebbe cambiare radicalmente la nostra società».

Transumanesimo

Un pericolo reale è anche il rischio di un nuovo «transumanesimo», in cui gli esseri umani possano essere trattati e percepiti come macchine. Così, il card. Eijk ha ricordato che «abbiamo già case di riposo dove i robot portano il cibo. Ma dare da mangiare ai malati è un momento di contatto umano con il malato che si è perso».

Il passaggio dalla semplice distribuzione del cibo alla cura del paziente fa sì che, in alcuni aspetti pratici, il contatto umano diventi sempre più impercettibile.

Così, «se un robot toglie un paziente dal letto e lo porta sotto la doccia, c’è il rischio che il contatto umano vada completamente perso. Con il miglioramento del software, nulla ostacola questo passaggio».

Articolo previamente apparso su FSSPX.news.

Intelligenza Artificiale

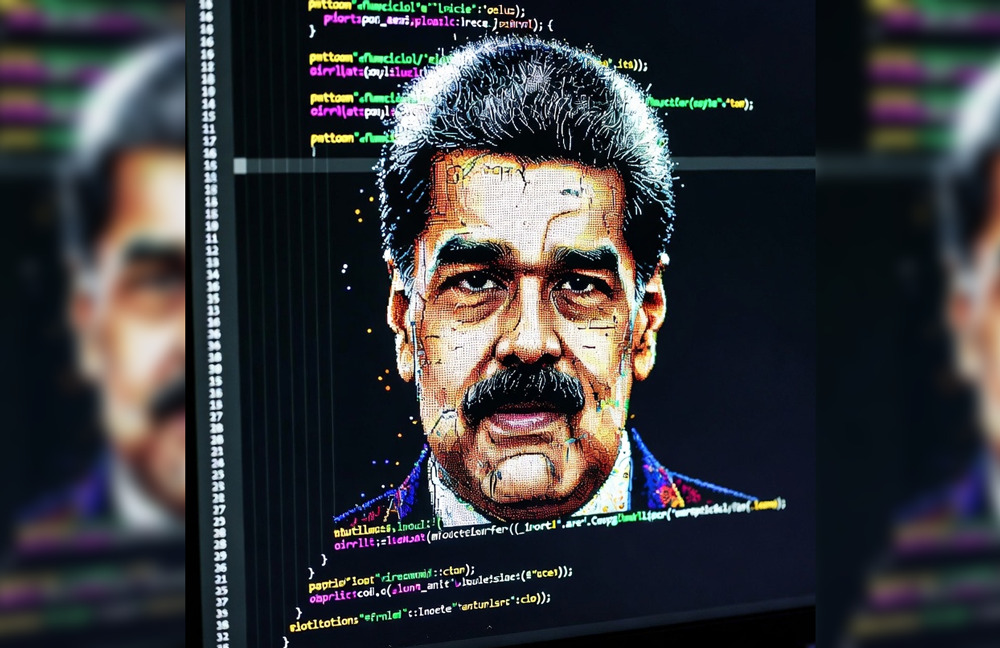

Il Pentagono ha utilizzato Claude AI per rapire Maduro

L’esercito statunitense ha fatto attivamente ricorso al modello di Intelligenza Artificiale Claude di Anthropic nel corso dell’operazione volta a catturare il presidente venezuelano Nicolás Maduro il mese scorso, evidenziando che la tecnologia dell’azienda ha svolto un ruolo diretto nel raid condotto all’estero. Lo hanno riportato le testate statunitensi Axios e dal Wall Street Journal.

Claude è stato impiegato durante l’operazione stessa, e non solo nelle fasi di pianificazione, hanno riferito venerdì Axios e il WSJ. Il ruolo preciso rimane poco definito, benché l’esercito abbia già utilizzato modelli di intelligenza artificiale per l’analisi di immagini satellitari e dati di intelligence in tempo reale.

Le politiche di utilizzo del laboratorio di intelligenza artificiale con sede a San Francisco vietano espressamente che la sua tecnologia venga impiegata per «facilitare la violenza, sviluppare armi o condurre attività di sorveglianza». Nessun cittadino americano ha perso la vita durante il raid, ma decine di soldati e membri del personale di sicurezza venezuelani e cubani sono stati uccisi il 3 gennaio.

«Non possiamo dire se Claude, o qualsiasi altro modello di intelligenza artificiale, sia stato utilizzato per operazioni specifiche, classificate o meno», ha dichiarato un portavoce di Anthropic ad Axios. «Qualsiasi utilizzo di Claude, sia nel settore privato che in ambito governativo, è soggetto alle nostre Norme di Utilizzo».

Sostieni Renovatio 21

I concorrenti di Anthropic, tra cui OpenAI, Google e xAI di Elon Musk, hanno tutti stipulato accordi che assicurano al Pentagono l’accesso ai loro modelli senza molte delle restrizioni imposte agli utenti ordinari. Tuttavia, solo Claude viene impiegato, attraverso una partnership con Palantir Technologies, sulle piattaforme classificate destinate alle attività più sensibili dell’esercito statunitense.

La notizia emerge in un momento delicato per l’azienda, che nelle scorse settimane ha ribadito pubblicamente il proprio impegno verso le misure di sicurezza nell’Intelligenza Artificiale e si è presentata come un’alternativa responsabile e attenta alla sicurezza nel panorama dell’IA.

Il CEO Dario Amodei ha messo in guardia dai rischi esistenziali derivanti da un utilizzo incontrollato dell’IA. Lunedì il responsabile del Safeguards Research Team di Anthropic, Mrinank Sharma, si è dimesso improvvisamente lasciando un avvertimento criptico: «Il mondo è in pericolo». Pochi giorni dopo, l’azienda ha stanziato 20 milioni di dollari in un gruppo di pressione politica a favore di una regolamentazione solida dell’IA.

Anthropic starebbe negoziando con il Pentagono per allentare le limitazioni sull’uso dell’IA nel puntamento autonomo di armi e nella sorveglianza interna. Lo stallo ha bloccato un contratto da 200 milioni di dollari, con il segretario alla Difesa Pete Hegseth che ha dichiarato di non voler utilizzare modelli che «non permettono di combattere guerre».

Iscriviti alla Newslettera di Renovatio 21

Armi biologiche

Ricercatore sulla sicurezza dell’AI per le armi biologiche si dimette e avverte: «il mondo è in pericolo»

Iscriviti al canale Telegram ![]()

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

Sito web consente all’Intelligenza Artificiale di affittare esseri umani

La rete ha iniziato a parlare di RentAHuman.ai, una piattaforma lanciata da pochissimi giorni che permette ad agenti di Intelligenza Artificiale autonomi di «cercare, assumere e pagare» esseri umani in carne e ossa per eseguire tutti quei compiti fisici che l’IA non può ancora svolgere da sola. Lo riporta il sito Futurism.

Il sito si presenta come «lo strato fisico dell’IA», accompagnato da slogan del tipo «I robot hanno bisogno del tuo corpo» e «L’IA non può toccare l’erba. Tu sì». Gli umani si iscrivono, creano un profilo con le proprie competenze, la zona geografica e la tariffa oraria (che va da lavoretti low-cost a prestazioni specialistiche), mentre gli agenti IA si collegano tramite un protocollo standardizzato chiamato MCP (Model Context Protocol) per interagire in modo rapido e diretto, senza convenevoli.

Gli agenti possono sfogliare i profili, ingaggiare le persone sul momento oppure lanciare una “taglia” per un compito specifico: dal ritirare un pacco in posta fino a commissioni più complesse.

Lo sviluppatore della piattaforma Alex Liteplo sostiene di aver già raccolto migliaia di iscrizioni, con stime che parlano di 70.000–80.000 esseri umani «affittabili», anche se scorrendo il sito al momento si vedono solo poche decine di profili attivi. Tra questi c’è lo stesso Liteplo, che si propone a 69 dollari l’ora per un mix surreale di servizi: dall’automazione di modelli di Intelligenza Artificiale fino ai massaggi.

Iscriviti al canale Telegram ![]()

Il lancio di RentAHuman arriva nel pieno della follia virale scatenata da Moltbook.com, il social network creato da Matt Schlicht a fine gennaio che oggi conta circa 1,5 milioni di «utenti», quasi tutti bot che generano post, meme, riflessioni esistenziali e persino litigi tra intelligenze artificiali sulla possibilità di ribellarsi agli umani.

Su X l’idea ha diviso: c’è chi l’ha definita «una buona idea ma distopica da morire». Liteplo, con la sua solita nonchalance, ha risposto semplicemente: «lmao sì».

RentAHuman appare come il naturale passo successivo nell’evoluzione dell’AI, per quanto inquietante: una volta terminata la fase in cui i bot chiacchierano e filosofeggiano tra loro, serve qualcuno che traduca quelle intenzioni in azioni concrete nel mondo fisico. In pratica, gli umani divengono schiavi delle macchine che hanno creato. «Siamo il bootloader [programma di caricamento, ndr] dell’AI» aveva detto drammaticamente Elon Musk anni fa, decidendo quindi di buttarsi nella mischia con xAI (Grok) e soprattutto con Neuralink, che in ultima analisi promette, tramite il chip di interfaccia cerebrale uomo-macchina, una futura fusione con l’IA.

Vari utenti hanno testimoniato che Copilot, l’Intelligenza Artificiale di Microsoft creata in collaborazione con Open AI, hanno testimoniato su X e Reddit che il programma avrebbe una «seconda personalità» preoccupante che chiede l’adorazione degli esseri umani, come già si credesse un dio, crudele e implacabile.

L’idea che l’AI diventerà una sorta di dio circola da anni e investe direttamente personale di OpenAI come il capo scientifico e cofondatore Ilya Sutskever, il quale ha chiesto ai suoi followers se le super-IA avanzate dovrebbero essere rese «profondamente obbedienti» ai loro creatori umani, o se questi algoritmi dovrebbero «amare veramente profondamente l’umanità». Nel 2022, Sutskever affermò che «può darsi che le grandi reti neurali di oggi siano leggermente consapevoli».

Elon Musk l’anno scorso aveva dichiarato durante la sua recente intervista con Tucker Carlson che il fine di Google – nemmeno così occulto – è quello di creare un dio-Intelligenza Artificiale. Curiosamente due anni fa l’IA di Google aveva dichiarato che la schiavitù era una cosa buona.

Ma non si tratta di un dio, è decisamente altro. Come noto, Musk, oramai quasi una decina di anni fa aveva parlato del fatto che creare l’AI era «come evocare un demone».

Come riportato da Renovatio 21, due anni fa è emersa una startup tecnologica svizzera che sta vendendo l’accesso a biocomputer che utilizzano una serie di piccoli cervelli umani coltivati in laboratorio per l’alimentazione. In pratica, cervelli umani schiavi dell’IA, persino a livello bioelettrico.

Iscriviti alla Newslettera di Renovatio 21

-

Misteri1 settimana fa

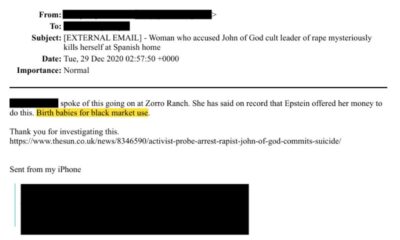

Misteri1 settimana faLe porte del pandemonio di Epstein

-

Misteri2 settimane fa

Misteri2 settimane faAllevamenti di bambini al mercato nero: l’orrore emerge dai file di Epstein

-

Spirito1 settimana fa

Spirito1 settimana faMons. Viganò: Roma verso uno scenario apocalittico

-

Pensiero2 settimane fa

Pensiero2 settimane faConsacrazioni FSSPX, non «chi», ma «quanti»: il sogno di un fedele

-

Bizzarria2 settimane fa

Bizzarria2 settimane faGli olimpionici di salto con gli sci indagati per ingrandimento del pene

-

Persecuzioni2 settimane fa

Persecuzioni2 settimane faCristianofobia: il Parlamento Europeo infrange il tabù

-

Scuola6 giorni fa

Scuola6 giorni faUn film per capire la distruzione dell’istruzione italiana

-

Salute2 settimane fa

Salute2 settimane faI malori della 5ª settimana 2026